Cerf

25.02.2011, 15:09 Uhr

Auf dem Weg zum Weltraum-Internet

Vinton Cerf nimmt seinen Titel als Chief Internet Evangelist für Google ernst: Er steckt knietief in einigen Zukunfts-Projekten für das Internet. Im Interview äussert sich der Webguru über die neusten Entwicklungen des Netz der Netze.

Vinton Cerf gilt als einer der Väter des TCP/IP-Protokolls und der Entwicklung des Internet ganz generell. Seit 2005 hält er bei Google den Posten eines Chief Internet Evangelist. Als solcher ist er bemüht, die neusten Webtrends zu identifizieren und diese dann auch für die Weiterentwicklung der Google-Dienste zu nutzen. Julie Bort von unserer US-Schwesterpublikation Networkworld hat Cerf am Rande der jährlich stattfindenden Konferenz Digital Broadband Migration in Boulder im US-Bundesstaat Colorado getroffen. Sie diskutiert mit ihm die Zukunft von IP, Heimnetzwerkerei, das Internet der Dinge, die Verhinderung des sogenannten Kill-Switches und das interplanetare Internet. Wird es ein IPv7 geben und welche Probleme wird es lösen? Vor Jahren, als wir uns überlegten, wie wir den IP-Adressraum effizient erweitern könnten, wurden vier Vorschläge gemacht. Schlussendlich einigte man sich auf einen, der dann zu IPv6 ausgearbeitet wurde. Nein, es gibt keine 7., 8. und 9. Version des Protokolls. Und derzeit gibt es auch keinerlei Anreize, eine weitere Version zu erfinden. Zur Zeit fokussieren wir uns ganz darauf, dass IPv6 eine möglichst weite Verbreitung erhält, bevor wir tatsächlich keine IPv4-Adressen mehr haben. Das sollte aber niemanden daran hindern, über neue Arten für ein Redesign des Internet nachzudenken. Tatsächlich gibt es ein «Tabula rasa»-Projekt an der Stanford University, das von der National Science Foundation unterstützt wird. Dabei wird das Internet mit unserem heutigen Wissen neu entworfen. Ein Ergebnis hat das Projekt auch schon aufzuweisen, und zwar mit dem "Openflow Router", der Datenpakete anders behandelt als klassische Wegplaner. So weit ich weiss, gibt es allerdings keine Pläne, auf dem IP-Level weitere Änderungen vorzunehmen. Das heisst nicht, dass dies in Zukunft nicht geschieht.

Wird sich der Endanwender darum kümmern müssen, ob alle seine Gerätschaften IPv6 verstehen oder wird er sich darauf verlassen können, dass die Carrier und Internetprovider mit NAT-Geräten (Network Address Translation), die IPv4 in IPv6 übersetzen, ihm dies abnehmen? Nein, das wird er nicht können. Ich bin auch kein grosser Fan dieser Carrier-seitigen NAT. Das Konzept ist etwas faul, denn es sieht nicht vor, dass auch auf der Consumer-Seite Server stehen. Das Internet ist noch sehr asymmetrisch, will heissen, dass der Download-Verkehr schneller befördert wird als der Upload-Verkehr. In dieser Situation sehen es die Provider nicht gerne, wenn die Endanwender Server aufstellen, weil dies zuviel Uplink-Bandbreite verbraucht. Doch in nicht allzu ferner Zukunft wird es normal und zu bevorzugen sein, wenn auch zuhause Server stehen. Deshalb sollte man auch in den eigenen vier Wänden auf IPv6 setzen. Klar, für eine Übergangszeit sind solche Carrier-seitigen NAT ganz nützlich. Ist denn IPv6 im Heimnetz so wichtig wie in Firmennetzen? In beiden ist es wichtig, beide Protokolle zu unterstützen. Denn der Tag wird kommen, wenn Server nur noch IPv6 verstehen. Daher müssen auch zuhause, die Geräte mit dem neuen Internet-Protokoll klar kommen. Laptops und Desktop-PC können dies bereits. Gewöhnlich sind es die Firewall, die NAT-Box oder das Breitband-Modem, die mit IPv6 nicht umgehen können. Interessant wird es am 8. Juni 2011. Dann wird ein 24-stündiger, weltweiter Bereitschaftstest für IPv6 durchgeführt. Ich bin sicher, da werden wir Einiges finden, was noch nicht funktioniert und das wir dann im wahrsten Sinne des Wortes adressieren müssen.

Wo sehen Sie den nächsten grossen Internet-Boom für Endverbraucher? Wenn ich das wüsste, würde ich in die entsprechende Firma investieren. Aber es ist mittlerweile klar, dass Soziale Netze viel damit zu tun haben. Die Plattformen, die es den Usern erlauben, Ihre eigenen Inhalte zu kreieren und zu teilen, werden an Wichtigkeit noch gewinnen. Eine weitere zukunftsträchtige Entwicklung ist das Internet der Dinge, über das wir eine Vielzahl von Gadgets und Geräte verbinden, die uns einerseits helfen, die wir andererseits auch verwalten müssen. Hier wird es demnächst Firmen geben, die uns diese Verwaltungsarbeit abnehmen werden. Unsere Unterhaltungselektroniksysteme könnte beispielsweise von einem Drittanbieter gemanagt werden, der nichts mit dem Inhalt selbst zu tun hat. Die Ereignisse in der arabischen Welt insbesondere in Ägypten haben gezeigt, dass Regierungen das Internet einfach abschalten können. Auch in den USA wird von einem sogenannten «Kill Switch» gesprochen. Gibt es technisch gesehen eine Möglichkeit, die Regierung davon abzuhalten, das Internet abzuschalten? Man sollte immer folgendes bedenken: Das Internet läuft auf einem hierarchisch aufgebautes Fundament. Und so lange dieses Fundament von der Regierung kontrolliert werden kann, so wird es möglich sein, dass sie das Netz auch einfach abstellt. Erst wenn wir wirklich ein Maschennetz haben, das aus vielen gleichberechtigten Punkt-zu-Punkt-Verbindungen besteht, das ohne die zentralen Router von Internetprovidern funktioniert, erst dann wird es möglich sein, den «Kill Switch» der Regierung zu blockieren. Die Lösung wäre also ein solches sich selbst zusammenstellendes und organisierendes sowie aus gleichberechtigten Knoten bestehendes Netz. Die Technik hierfür gibt es zwar grundsätzlich, sie wird aber nicht eingesetzt.

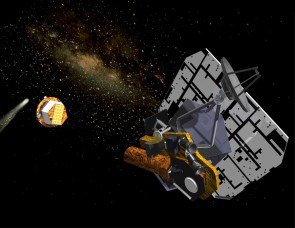

Auf dem Weg zum intergalaktischen Backbone

Vor einem Jahr haben Sie begonnen, vom inter-planetaren Internet zu sprechen, also die Erweiterung des Netzes ins Universum. Wie steht es um dieses Projekt?

Es kommt gut voran. Dieses Internet benutzt nicht das Internet-Protokoll, es basiert vielmehr auf dem «Bundle Protocol». Dieses wurde entwickelt, um ein Netz zuzulassen, das mit Verzögerungen und Unterbrechungen besser klar kommt. Bei IP sieht das anders aus: Dieses geht davon aus, dass die Verbindungen gut sind und sich die Latenzzeiten in einem gewissen Rahmen bewegen. Im Weltraum sprechen wir aber selbst bei der Verwendung von Lichtgeschwindigkeit von Verzögerungen, die Minuten bis Tage dauern können. Hier soll das Bundle Protocol weiterhelfen. Es kommt beispielsweise an Bord der Internationalen Weltraumstation ISS bereits zum Einsatz. Zudem verwenden es einige Labore der Nasa und einige Hochschulen. So wurde bereits ein Bundle Bone erstellt, also ein Netzwerkhauptstrang vergleichbar mit dem IPv6-Backbone, der die verschiedenen Stationen miteinander verbindet. Aber auch schon ausserhalb der Forschung ist das interplanetare Protokoll anzutreffen. So gibt es eine Implementierung des Bundle Protocol für Android, allerdings noch in einer sehr frühen Vorversion, die alles andere als stabil ist. Daneben laufen Test auf dem Raumschiff EPOXI, das einmal Deep Impact genannt wurde. Vor einigen Jahren schoss dieses eine Sonde in einen Kometen, um eine Spektografieanalyse zu erstellen. Dieses Raumschiff ist immer noch im Weltraum. Derzeit ist es in der Nähe der Sonne und besuchte Ende 2010 den Kometen Hartley 2. Auf EPOXI haben wir die interplanetarischen Protokolle hochgeladen und haben sie mit ungefähr 80 Lichtsekunden getestet. Im Jahr 2011 werden wir nun daran gehen und diese Protokolle standardisieren, so dass alle Weltraum-Nationen diese dann adaptieren können. Geschieht das, wird jedes neue Raumschiff und jeder neue Satellit über dieses Protokoll verbunden sein. Was noch wichtiger ist: Haben diese Vehikel im Weltall ihren ursprünglichen Zweck erfüllt, sind sie ja meistens noch da und verfügen über Energie und Rechenleistung. Dann können wir sie über unsere Protokolle ansprechen und als Knoten eines interplanetarischen Backbones einsetzen. Dadurch kann die derzeit noch sehr simple Punkt-zu-Punkt-Kommunikation per Funk in der Raumfahrt verbessert werden. Und für künftige Missionen werden wir auch ein komplexeres Kommunikationssystem benötigen.

Hier auf der Erde ist Google derweil in zahlreichen Projekten involviert, die das Internet beschleunigen sollen. So wurde unlängst das Protokoll SPDY vorgestellt. Wie ernst muss man dies nehmen? Sehr ernst. Dies sind alles Bemühungen von Google, die Implementationen des Internets effizienter werden zu lassen. Vieles ist dabei quelloffen und wird von einer Handvoll Ingenieuren bei Google betreut. Das ist das coole an Google, dass man mit wenigen Leuten bereits viel bewegen kann. Eine Zeitlang wurde viel vom semantischen Web gesprochen. Ist das noch aktuell? Das weiss ich nicht. Ich weiss nur, dass Tim Berners-Lee immer noch sehr, sehr entschlossen ist, in diese Richtung weiter zu forschen. Er nennt das jetzt "Deep Linking". Es geht schlussendlich darum, einen Weg zu finden, um Daten sinnvoll zu verbinden, die aus den unterschiedlichsten Ecken und Quellen des Internet stammen. So wie ich das sehe, ist das eine Mammutaufgabe, die bereits seit einem Jahrzehnt läuft. Aber Tim war in der Vergangenheit erfolgreich, deshalb schliesse ich nicht aus, dass daraus noch etwas wird. Aber es wird ein langer, steiniger Weg sein. Sie haben im vergangen Jahr viel von Cloud-Standards gesprochen. Heute kann sich OpenStack von Rackspace einer grossen Unterstützung erfreuen. Hat diese Norm deshalb schon gewonnen? Ich würde sie noch nicht zum Gewinner erklären. Dies nicht, weil ich einen anderen Standard bevorzugen würde. Doch meiner Meinung nach müsste es 25 bis 30 Gruppen geben, die sich um Cloud-Standards kümmern. Das grösste Problem wird in jedem Fall die Implementation und das Erproben der Standards sein. Bis wir wirklich ernst zu nehmende Erfahrungen darin haben, wie Clouds unter einander in verschiedenen Situationen interagieren, werden wir nicht sagen können, was wirklich funktioniert und was nicht. Alle diese Bemühungen sind lobenswert, aber sie müssen noch den Realitätstest bestehen, bevor wir sie zu Gewinnern erklären können.