Internet der Dinge

24.05.2018, 14:30 Uhr

Mit IoT Analytics Maschinendaten richtig auswerten

Die Auswertung massenhaft anfallender Sensordaten erfordert eine besondere Strategie. Verschiedene IoT-Analyseplattformen helfen bei der Verarbeitung der Datenflut.

Datenmassen überschwemmen das Internet der Dinge. «Die schiere Zahl neu angeschlossener Geräte und Sensoren, die in den letzten Jahren implementiert wurden, hat zu einem wahren ‚Daten-Tsunami’ geführt», sagt Theresa Bui, Director of IoT Strategy bei Cisco IoT.

Diese Situation wird sich noch verschärfen: Je nach Studie sollen bis zum Jahr 2020 zwischen 20 und 50 Milliarden Geräte über das Internet kommunizieren und pro Tag mehrere Trillionen Byte an Daten produzieren.

«Bei bestimmten Projekten im Automotive-Umfeld reden wir von einem Datenvolumen von bis zu 15 Terabyte pro Tag und Auto», umreisst Christian Dornacher, Director Storage und Analytics Solutions EMEA bei Hitachi Vantara, die gewaltigen Dimensionen, «Aktuelle Netzwerklösungen sind da bereits nicht mehr in der Lage, das mit Standardmitteln zu übertragen.»

Aber nicht nur die Netze, auch die herkömmlichen Datenbanken und Analysesysteme sind damit überfordert. «Ab einer gewissen Grösse wird es unwirtschaftlich, die IoT-Daten in Online-Datenbanken zu speichern», weiss Jan Metzner, Specialist Solutions Architect IoT, EMEA bei Amazon Web Services (AWS). «Deswegen muss man Wege finden, eine solche hohe Anzahl an Daten speichern und analysieren zu können.»

IoT-Daten treten aber nicht nur in Massen auf, sie sind zudem auch noch extrem heterogen. «Viele Kunden haben mit der Historie ihrer Maschinen zu kämpfen», weiss Erich Barnstedt, Azure Industrial IoT Engineering Lead bei Microsoft. «Sie sind zum Teil 30 Jahre alt, sprechen verschiedene Sprachen und übermitteln die Informationen in den unterschiedlichsten Datenformaten.» Die verschiedenen Feldbus- und Industrial-Ethernet-Versionen, in denen die Daten meist vorliegen, müssten in ein konsistentes Datenformat umgewandelt werden, um sie analysieren zu können, so Barnstedt weiter, «das ist mit viel Aufwand verbunden.»

Eine weitere besondere Herausforderung ist die Absicherung der Datenströme. «Das Übermitteln der Daten muss auf sichere Art und Weise erfolgen, was zwingend asymmetrische Kryptosysteme erfordert», so Jan Metzner von AWS. «Solche Software für Mikrocontroller zu entwickeln ist aufgrund geringer Rechenkapazität meist mit grösserem Aufwand verbunden.»

Das Rauschen im IoT-Netz

Noch ein Faktor, der die Auswertung von IoT-Daten erschwert, ist ihre Unzuverlässigkeit. Verschmutzte oder defekte Sensoren sowie Übertragungsprobleme verursachen ein erhebliches Rauschen. Analysesysteme für IoT-Daten sind daher mit einer ganzen Reihe zusätzlicher Funktionen ausgestattet. Sie können Daten reinigen und filtern, transformieren, mit Metadaten anreichern und ergänzen, falls Lücken in den Zeitreihen auftreten.

Gerade Zeitreihenanalysen sind im IoT-Umfeld besonders wichtig und informativ. Mit ihrer Hilfe lassen sich Nutzungsverlauf und Leistung von Maschinen und Geräten dokumentieren, um so Prognosen für potenzielle Probleme zu erstellen und optimale Wartungszyklen zu definieren.

Sogenannte Streaming-Analytics-Verfahren können zudem in Echtzeit oder nahezu in Echtzeit auf Veränderungen reagieren. Sie eignen sich allerdings nur für enge Zeitfenster. Für längere Messungen müssen die Informationen aufbereitet und gespeichert werden. «Je mehr Daten über einen grösseren Zeitraum vorhanden sind, desto mehr ist aus den Daten herauszulesen», sagt AWS-IoT-Spezialist Metzner.

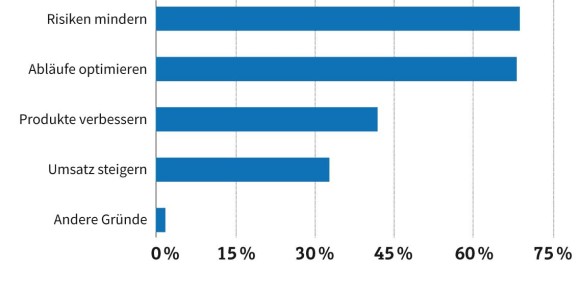

Die separate Auswertung der Maschinendaten genügt jedoch nicht. Laut einer Umfrage des Marktforschungsunternehmens 451 Research wollen mehr als zwei Drittel der Befragten mit Hilfe der IoT-Analyse vor allem Risiken reduzieren und Betriebsabläufe optimieren. Um das zu erreichen, müssen die IoT-Daten mit Informationen aus Unternehmenssystemen wie Enterprise Resource Planning (ERP), Business Process Management (BPM) oder Supply-Chain Management (SCM) zusammengeführt und kombiniert werden können. «In Kombination mit anderen Datenquellen eröffnen IoT-Daten grosse Chancen für Unternehmen», sagt Igor Ilunin, Leiter der IoT-Abteilung beim Software- und Beratungshaus DataArt, das mit der Open-Source-Lösung DeviceHive eine eigene IoT-Plattform betreibt.

Neben einer Echtzeitanalyse ist dabei auch die Möglichkeit entscheidend, Daten retrospektiv auswerten und Was-wäre-wenn-Szenarien rechnen zu können. «Wenn es gelingt, durch die Kombination von IoT- und Business-Daten Zusammenhänge besser zu verstehen, lassen sich Einsparungen im zweistelligen Prozentbereich realisieren», ergänzt Dorian Selz, Geschäftsführer des Schweizer Unternehmens Squirro, das mit KI-gesteuerten Cognitive-Insights-Lösungen umfassende Analysen von unstrukturierten Daten ermöglicht.

Verteilte Aufgaben

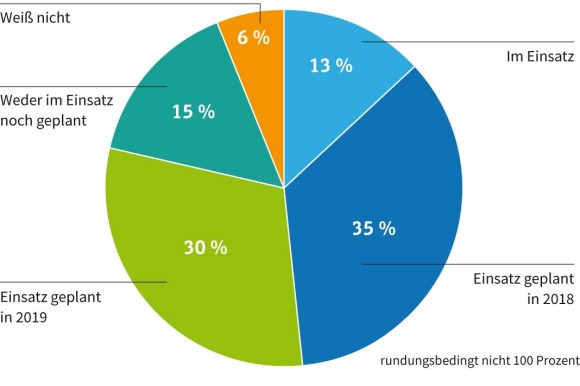

Die Analyse von IoT-Daten findet zunehmend dezentral statt. Laut einer aktuellen Umfrage des Marktforschungsunternehmens IDC planen 57 Prozent der befragten Unternehmen, IoT-Analysen bis 2019 am Edge einzusetzen, 14 Prozent tun das bereits. 65 Prozent wollen auch das Endgerät selbst für Analysen nutzen, bei 13 Prozent ist dies bereits Realität. Die Analysten gehen davon aus, dass bis 2019 40 Prozent der IoT-Daten im oder in der Nähe der Endpoints verarbeitet werden. «Je zeitkritischer die Ergebnisse der Datenanalyse, desto näher sollte diese am Entstehungsort stattfinden», sagt Mark Schulte, Senior Consultant bei IDC.

Schon heute haben Geräte auf Arduino- oder Raspberry-PI-Basis genügend Rechenleistung, um anspruchsvolle Aufgaben abzuarbeiten. So kann beispielsweise die AWS-Software Greengrass, die unter anderem auf der Raspberry-Plattform läuft, nicht nur Funktionen des Serverless-Computing-Dienstes Lambda lokal ausführen, sondern auch vortrainierte Machine-Learning-Modelle im Gerät selbst auf aktuelle Daten anwenden.

Genügt die Performance der Endgeräte nicht oder sind die Daten Tausender Sensoren zu verarbeiten, kommen Edge-Server oder -Rechenzentren zum Einsatz. Eigens für diesen Zweck entwickelte Systeme wie der Intel Xeon D-2100, der ARMv8-Chip A1 von Ampere oder der Qualcomm Centriq 2400 sollen solchen Edge-Servern zukünftig eine hohe Rechenleistung bei zugleich niedrigem Energieverbrauch ermöglichen.

Bei aller Konzentration auf die Edge-Verarbeitung spielen Cloud-Lösungen bei der Analyse von IoT-Daten eine Hauptrolle, ist sich Igor Ilunin von DataArt sicher: «Zusätzlich zu IoT-Services bieten Clouds viel Speicherplatz, leisten Big-Data-, KI- oder Monitoringdienste und erhöhen das Leistungsvermögen der Rechner um ein Vielfaches, was eine mühelose Einrichtung der Lösung erlaubt.»

IoT-Analytics-Lösungen (Auswahl)

| Hersteller / Produkt | Besonderheiten |

| Amazon Web Services / AWS IoT Analytics | vollständig verwaltete und automatisierte Erfassung, Filterung, Transformation und Analyse von Gerätedaten |

| Cisco / Jasper Control Center for IoT | Echtzeit-Monitoring von Geräten, Kostenkontrolle nahezu in Echtzeit, Muster- und Trendanalysen |

| DataArt / DeviceHive | Open-Source-Lösung, unterstützt Apache Spark und Spark Streaming |

| Hitachi Vantara / Pentaho Internet of Things Analytics | automatische Integration von Maschinen- und Sensordaten durch „Metadata Injection“ |

| IBM / Watson IoT Platform | Integration von KI-Funktionen und -Assistenten |

| IFS / IoT Business Connector | Management- und Monitoringfunktionen für Azure IoT Suite, Handlungsempfehlungen auf Basis von IoT-Daten |

| Mentor / Valor IoT Manufacturing Analytics | Big-Data- und BI-Lösung für die Elektronikindustrie |

| Microsoft / Azure IoT Suite | Erfassen und Analysieren von Gerätedaten mit Advanced Analytics |

| SAS / Analytics for IoT | Event Stream Processing extrem großer Datenmengen |

| Tellient / IoT Data Analytics | Analyseplattform für Mobilfunk-Provider und andere Telekommunikationsanbieter |

| Tibco / StreamBase | Echtzeitanalyse von Streaming-Daten |

| Treasure Data / IoT Analytics Platform | Integration, Korrelation und Auswertung von Daten aus verschiedensten Quellen |

| Für weitere IoT-Plattformen mit integrierten Analysefunktionen lesen Sie auch unseren Praxisartikel "So tief greifend verändert das IoT die Industrie" | |

IoT-Analytics-Lösungen (Auswahl)

| Hersteller / Produkt | Besonderheiten |

| Amazon Web Services / AWS IoT Analytics | vollständig verwaltete und automatisierte Erfassung, Filterung, Transformation und Analyse von Gerätedaten |

| Cisco / Jasper Control Center for IoT | Echtzeit-Monitoring von Geräten, Kostenkontrolle nahezu in Echtzeit, Muster- und Trendanalysen |

| DataArt / DeviceHive | Open-Source-Lösung, unterstützt Apache Spark und Spark Streaming |

| Hitachi Vantara / Pentaho Internet of Things Analytics | automatische Integration von Maschinen- und Sensordaten durch „Metadata Injection“ |

| IBM / Watson IoT Platform | Integration von KI-Funktionen und -Assistenten |

| IFS / IoT Business Connector | Management- und Monitoringfunktionen für Azure IoT Suite, Handlungsempfehlungen auf Basis von IoT-Daten |

| Mentor / Valor IoT Manufacturing Analytics | Big-Data- und BI-Lösung für die Elektronikindustrie |

| Microsoft / Azure IoT Suite | Erfassen und Analysieren von Gerätedaten mit Advanced Analytics |

| SAS / Analytics for IoT | Event Stream Processing extrem großer Datenmengen |

| Tellient / IoT Data Analytics | Analyseplattform für Mobilfunk-Provider und andere Telekommunikationsanbieter |

| Tibco / StreamBase | Echtzeitanalyse von Streaming-Daten |

| Treasure Data / IoT Analytics Platform | Integration, Korrelation und Auswertung von Daten aus verschiedensten Quellen |

| Für weitere IoT-Plattformen mit integrierten Analysefunktionen lesen Sie auch unseren Praxisartikel "So tief greifend verändert das IoT die Industrie" | |

Herausforderung IoT Analytics

Daten aus dem Internet der Dinge stellen ganz eigene Anforderungen an Analysesysteme. «Anders als bei BI-Systemen spielen hier Aspekte wie Latenzzeit, Echtzeitfähigkeit, begrenzte Übertragungsbandbreite, Erfassung der Daten von Maschinen im Eigentum Dritter, Datenschutz bei der Erfassung und Übertragung, Aggregation über grosse Flotten sowie das Device and Fleet Management eine grosse Rolle», erläutert Tobias Joppe, Business Solution Manager bei der Innovationsberatung Zühlke Engineering, die unter anderem Lösungen zur intelligenten Gebäudevernetzung sowie zur Fernwartung von Maschinen und Industrieanlagen entwickelt und umsetzt.

Hinzu kommen spezifische Analysemethoden, die eine Vorhersage von Ereignissen ermöglichen (Predictive Analytics), beispielsweise um Maschinen abschalten oder warten zu können, bevor sie ausfallen (Predictive Maintenance). «Herkömmliche BI-Systeme werden typischerweise für die deskriptive Datenanalyse im Business-Kontext eingesetzt, beispielsweise wenn es um die Frage geht: Welcher Maschinentyp wurde von welchen Kundenarten bevorzugt gekauft?», erklärt Joppe. «Bei IoT-Analyseplattformen geht es zumeist darum, vorausschauende Aussagen zu treffen, indem man Daten von technischen Geräten und Objekten analysiert.»

Die Nachfrage nach solchen Lösungen soll in den kommenden Jahren deutlich zunehmen. Laut dem Marktforschungsinstitut Markets and Markets wird das weltweite Volumen von rund 7 Milliarden Dollar im Jahr 2017 bis 2022 auf annähernd 28 Milliarden Dollar steigen, was einer durchschnittlichen jährlichen Wachstumsrate von 31 Prozent entspricht. Die grösste Nachfrage ist demnach aus der Fertigungsindustrie, der Energiewirtschaft und der Transport- und Logistik-Branche zu erwarten.

Zu ganz ähnlichen Zahlen kommen die Kollegen von Technavio. Sie sagen dem IoT-Analytics-Markt in den nächsten Jahren ein durchschnittliches Wachstum von 33 Prozent voraus. Laut Technavio wird der Markt mit einem Anteil von 27 Prozent durch die Fertigungsindustrie dominiert, die grössten Wachstumschancen sehen die Analysten im Retail-Bereich. Noch sind diese Umsätze allerdings sehr ungleich verteilt. Laut Persistence Market Research entfallen fasst zwei Drittel der Umsätze auf Nordamerika.

IoT-Analytics-Lösungen sind häufig Teil umfassenderer IoT-Plattformen und -Suiten, die neben der Anbindung und dem Management von Endgeräten sowie der Erfassung, Integration und Visualisierung von Daten erweiterte Analysefunktionen (Advanced Analytics) anbieten. Die Analysten von IDC bezeichnen derartige Lösungen als IoT-Plattformen der dritten Generation.

Schulte von IDC bescheinigt diesen Angeboten die grössten Zukunftschancen in einem sich konsolidierenden Markt: «Anbieter, die umfassende und innovative Funktionalitäten gerade im Hinblick auf Analytics ermöglichen, werden sich behaupten können.»

| Sechs Schritte zum IoT-Projekt |

| Je nach Anwendungsfall empfiehlt Microsoft, IoT-Projekte in folgenden sechs Schritten durchzuführen: |

| Vernetzte Fabrik |

|

1. Definieren Sie Ihre Digitalisierungsziele 2. Experimentieren Sie mit den Datenquellen 3. Schließen Sie Ihr Equipment an, ohne den Betriebsablauf zu unterbrechen 4. Kontextualisieren und visualisieren Sie Ihre Fertigungsleistung 5. Verändern Sie auf Basis der Daten Ihre Betriebsabläufe 6. Ermöglichen Sie neue Anwendungsszenarien und skalieren Sie |

| Fernüberwachung |

|

1. Identifizieren Sie Ihre Geschäftsziele 2. Profilieren Sie die beteiligten Assets 3. Stellen Sie fest, welche zusätzlichen Komponenten benötigt werden 4. Verstehen Sie Ihre Daten 5. Definieren Sie Geschäftsregeln 6. Operationalisieren Sie und liefern Sie Mehrwert |

| Prädikative Wartung |

|

1. Identifizieren Sie das gewünschte Ergebnis 2. Inventarisieren Sie Ihre Datenquellen 3. Erfassen und kombinieren Sie Ihre Daten 4. Modellieren, testen und integrieren Sie Ihre Modelle 5. Validieren Sie Ihr Modell in einem realen operativen Umfeld 6. Integrieren Sie das fertige Modell in den Betriebsablauf |

|

Quellen: https://cloud-platform-assets.azurewebsites.net/connected-factory https://cloud-platform-assets.azurewebsites.net/remote-monitoring https://cloud-platform-assets.azurewebsites.net/predictive-maintenance |

| Sechs Schritte zum IoT-Projekt |

| Je nach Anwendungsfall empfiehlt Microsoft, IoT-Projekte in folgenden sechs Schritten durchzuführen: |

| Vernetzte Fabrik |

|

1. Definieren Sie Ihre Digitalisierungsziele 2. Experimentieren Sie mit den Datenquellen 3. Schließen Sie Ihr Equipment an, ohne den Betriebsablauf zu unterbrechen 4. Kontextualisieren und visualisieren Sie Ihre Fertigungsleistung 5. Verändern Sie auf Basis der Daten Ihre Betriebsabläufe 6. Ermöglichen Sie neue Anwendungsszenarien und skalieren Sie |

| Fernüberwachung |

|

1. Identifizieren Sie Ihre Geschäftsziele 2. Profilieren Sie die beteiligten Assets 3. Stellen Sie fest, welche zusätzlichen Komponenten benötigt werden 4. Verstehen Sie Ihre Daten 5. Definieren Sie Geschäftsregeln 6. Operationalisieren Sie und liefern Sie Mehrwert |

| Prädikative Wartung |

|

1. Identifizieren Sie das gewünschte Ergebnis 2. Inventarisieren Sie Ihre Datenquellen 3. Erfassen und kombinieren Sie Ihre Daten 4. Modellieren, testen und integrieren Sie Ihre Modelle 5. Validieren Sie Ihr Modell in einem realen operativen Umfeld 6. Integrieren Sie das fertige Modell in den Betriebsablauf |

|

Quellen: https://cloud-platform-assets.azurewebsites.net/connected-factory https://cloud-platform-assets.azurewebsites.net/remote-monitoring https://cloud-platform-assets.azurewebsites.net/predictive-maintenance |

Der digitale Zwilling

Ein Beispiel, wie die Analyse von IoT-Daten im Zusammenspiel mit anderen Komponenten Mehrwert bieten kann, ist der sogenannte digitale Zwilling, auch «Digital Shadow» genannt. Er stellt ein virtuelles Abbild einer realen Maschine oder Fabrikanlage dar. «Solche Modelle können industrielle Prototypen sein, Produktionsanlagen, Baustellen oder komplexe Gebäude wie Sportstadien, Kaufhäuser oder Krankenhäuser», erklärt Dominik Rüchardt, Senior Director & Head of Business-, Market- and Partner-Development Central Europe beim IoT-Plattformanbieter PTC, das Prinzip.

Die Sensordaten werden dazu in Echtzeit in die Analysesysteme gestreamt, die daraus den entsprechenden Zustand des Zwillings berechnen und die Informationen mit Daten beispielsweise aus CAD-Systemen zusammenbringen. So lässt sich beispielsweise laut Bernhard Kirchmair, Chief Digital Officer (CDO) bei Vinci Energies Deutschland, ein vorausschauendes Monitoring implementieren: «Wenn das virtuelle Abbild dem Original ein paar Sekunden voraus ist, kann es Probleme in der Produktion rechtzeitig aufdecken und gegensteuern.»

Interessant wird der digitale Zwilling vor allem, wenn man IoT-Daten mit anderen Technologien wie Augmented- oder Virtual-Reality-Systemen kombiniert. Über Brillen wie die Microsoft HoloLens lassen sich die Sensorinformationen dann visualisieren und erfahrbar machen. «So werden komplexe Zusammenhänge leichter verständlich», sagt Kirchmair. Die Vorteile sind vielfältig: Schon vor der Inbetriebnahme können Unternehmen Anlagen oder ganze Fabriken virtuell in Testläufen überprüfen, Produktionsprozesse überwachen und optimieren oder neue Maschinen und Produkte bereits im Vorfeld ausprobieren.

Derzeit kommt der digitale Zwilling hauptsächlich im industriellen Umfeld zum Einsatz. Das Beratungsunternehmen Deloitte sieht darin aber erst den Anfang. Vom Connected Car über Energie- und Gesundheitsversorgung, Logistik und Luftfahrt bis hin zu Smart Home und Smart City sehen die Analysten eine Vielzahl von Anwendungsmöglichkeiten. «In den kommenden fünf Jahren werden die beteiligten Akteure in allen aufgeführten Einsatzgebieten erste digitale Zwillinge und damit verbundene Dienste und Geschäftsmodelle etablieren», heisst es in der Deloitte-Studie «Grenzenlos vernetzt».

Einfach anfangen

Microsoft hat für die Umsetzung von IoT-Projekten in unterschiedlichen Anwendungsszenarien jeweils einen Sechs-Schritte-Plan entwickelt. Es sei vor allem wichtig, eigene Erfahrungen zu machen, betont IoT-Experte Barnstedt: «Fangt an und wartet nicht auf fertige Lösungen!»

“„Viele Kunden haben mit der Historie ihrer Maschinen zu kämpfen.“„

Tobias Joppe von Zühlke Engineering, ist derselben Meinung. «Wir empfehlen zunächst einen eher leichtgewichtigen Einstieg mit einer klaren Nutzendefinition – zum Beispiel mit einem Pilotprojekt auf einer einzelnen Maschine und ausgesuchten, freundlich gesinnten Kunden. So können Unternehmen mit vergleichsweise geringen Investitionen erste Erfahrungen sammeln und schon frühzeitig prüfen, ob die gesammelten Daten den erhofften Nutzen bringen.»

Barnstedt empfiehlt ausserdem, von Anfang an auf offene Standards wie OPC UA zu setzen. Microsoft selbst ist Mitglied in der OPC Foundation, die den Standard Open Platform Communications (OPC) entwickelt hat. Ursprünglich war OPC ein Windows-basiertes System, mit dem sich die Befehle spezifischer SPSS-Protokolle wie Profibus oder Modbus standardisieren liessen.

Mit der Spezifikation OPC UA (OPC Unified Architecture) wurde der Standard 2008 zu einer plattformunabhängigen, serviceorientierten Architektur weiterentwickelt, die auf PCs, in Cloud-Umgebungen, speicherprogrammierbaren Steuerungen oder Mikrocontrollern unter Windows, Mac OS X, Android und Linux betrieben werden kann. «Wir halten OPC UA für zielführend», sagt Barnstedt, «der Standard wird sich langfristig durchsetzen.»

OPC UA bietet ein konsistentes Informationsmodell, das den Datenaustausch zwischen Sensoren und Analysesystemen erheblich erleichtert. Daten lassen sich so je nach Anwendungszweck und Bedarf direkt auf dem Edge-Gateway, in der Cloud oder im eigenen Rechenzentrum verarbeiten. «Entscheidend dafür ist, dass die Daten in einem konsistenten Format vorliegenv, betont Barnstedt.

Daten finden

Nachdem Unternehmen die Probleme der Konnektivität und Sicherheit gelöst haben, stellt sich die Frage, welche Daten denn nun wirklich relevant sind. «Das ist die Kür», sagt Barnstedt, und rät mit Maschinenbauern und Automatisierungsanbietern aus der Branche zusammenzuarbeiten. «Diese Experten verfügen über das nötige Domänenwissen, um die für einen bestimmten Zweck wichtigen Daten von unwichtigen zu unterscheiden.»

Bei allen Unterschieden sieht Cisco-IoT-Expertin Theresa Bui aber auch grundlegende Anforderungen, die alle IoT-Projekte auszeichnen: «Was überall gleich ist, ist der Kernbedarf an Best Practices für das IoT-Datenmanagement: das Extrahieren und Sammeln von Daten, das Sicherstellen eines einheitlichen Datenmodells, das flexible Bestimmen, wo die Daten verarbeitet werden sollen, das Verschieben verschiedener Datensätze an mehrere Orte, wann immer sie benötigt werden, und das Ermöglichen der Anwendung von Data-Governance-Richtlinien und die Gewährleistung ihrer Durchsetzung.»

Die Integrationsarbeit hört jedoch bei der Auswahl der richtigen Maschinendaten nicht auf, die Einbindung zusätzlicher Informationen etwa aus der Gebäudetechnik oder auch öffentliche Informationen wie Wetterprognosen und Verkehrsströme können zusätzlichen Mehrwert bieten.

«Manchmal ist die Produktion vielleicht deswegen schlecht, weil die Umgebungstemperatur zu hoch ist», sagt Barnstedt. Microsoft kooperiert unter anderem mit dem Industrial-IoT-Experten Honeywell, um solche Daten ebenfalls in einem einheitlichen Format zur Verfügung zu stellen.

Eine andere Initiative in diese Richtung ist die «Verwaltungsschale», ein Modell, das von der Arbeitsgruppe «Referenzarchitekturen, Standards und Normung» (AG 1) der Plattform Industrie 4.0 in Zusammenarbeit mit dem Zentralverband der Elektroindustrie (ZVEI) entwickelt wurde. Es basiert auf dem Referenzarchitekturmodell Industrie 4.0 (RAMI 4.0) und soll Daten und Funktionen aus verschiedensten Systemen aufnehmen und in unterschiedlichsten Anwendungsszenarien bereitstellen können.

Fazit & Ausblick

Die Analyse der Datenflut aus dem Internet der Dinge stellt Unternehmen zweifelsohne vor ganz besondere Herausforderungen. Die Verarbeitung grosser Mengen unstrukturierter, heterogener Daten von oft zweifelhafter Qualität erfordert nun einmal andere Verarbeitungsstrategien als die herkömmlichen Methoden der klassischen Business-Intelligence-Systeme. IoT-Analyseplattformen bieten aus diesem Grund eine ganze Reihe von Zusatzfunktionen, zum Beispiel Aufbereitung, Filterung, Konsolidierung und Normalisierung von Daten.

Unternehmen sollten bei der Auswahl einer Lösung darauf achten, dass die Analysefunktionen in ein Ökosystem eingebettet sind, das auch Aspekte wie die IT-Sicherheit, das Gerätemanagement und die Datenübertragung abdeckt. Wichtig ist ausserdem, dass Analysen ganz oder zum Teil in die Endgeräte selbst oder in deren Nähe ausgelagert werden können. Das spart zum einen Kosten, weil der Transport und die Speicherung grosser Datenmengen vermieden werden können, zum anderen sind zeitkritische Analysen, die eine Reaktion in Echtzeit oder nahezu in Echtzeit erfordern, gar nicht anders realisierbar.

Ob man dabei alles aus einer Anbieterhand bezieht, auf Open Source setzt oder sich nach dem Best-of-Breed-Ansatz selbst die Komponenten zusammensucht, hängt letztlich vom Anspruch, der Zielsetzung und vor allem auch der Expertise im eigenen Haus ab. Die Hände in den Schoss zu legen, ist dagegen keine Alternative, ist sich Theresa Bui von Cisco IoT sicher: «Unternehmen haben zwei Möglichkeiten: Sie können entweder im IoT-Daten-Tsunami untergehen – oder ihn beherrschen.»

Im Gespräch mit Wolfgang Auer, CEO von Smartbow

Das Verhalten einer Kuh sagt viel darüber aus, wie es ihr geht. Wolfgang Auer, CEO des österreichischen Unternehmens Smartbow erklärt, wie sich diese Erkenntnis mit Hilfe moderner Analyseverfahren in eine IoT-Anwendung für Landwirte umsetzen lässt.

Computerworld: Herr Auer, was genau macht Ihre Lösung?

Wolfgang Auer: Wir haben eine Ohrmarke für Kühe entwickelt. Damit kann man die Tiere orten, ihren Gesundheitszustand überwachen und erkennen, wenn eine Kuh brünstig wird.

Computerworld: Wie funktioniert das?

Auer: Über die Marken wird ein Timing-Signal versendet, das es erlaubt, ein Tier auf einen Meter genau zu lokalisieren. Diese Information wird im Sekundentakt übermittelt. So lassen sich die Bewegungsprofile einer Kuh ermitteln und Verhaltensveränderungen sehr schnell erkennen. Ein Beschleunigungssensor in den Marken misst zudem die Ohrbewegungen, die ihrerseits ein guter Indikator für den Gesundheitszustand sind. Gesunde Kühe wackeln mit den Ohren.

Computerworld: Welche besonderen Herausforderungen stellen Kühe an die Erfassung, Übermittlung und Analyse von Daten?

Auer: Generell müssen die Sensoren für die Datenerfassung sehr robust sein, lange halten und sich natürlich drahtlos auslesen lassen. Die nächste Herausforderung ist die Datenmenge. Pro Kuh und Tag fällt circa 1 MByte an Daten an. Bei einem grossen Betrieb mit vielleicht 5.000 Tieren sind das 5 GByte. Das lässt sich nicht in Echtzeit in eine Cloud übertragen und dort verarbeiten, zumal die meisten landwirtschaftlichen Betriebe nicht oder nur unzureichend mit Internetzugängen versorgt sind. Wichtig sind auch Datensicherheit und Datenschutz.

Computerworld: Wie haben Sie diese Probleme gelöst?

Auer: Für die Übermittlung verwenden wir ein Wireless-System im 2,4-GHz-Band. Im Aussenbereich können die Empfänger mit Solarpanels betrieben werden. Die Daten werden in Echtzeit an einen lokalen Server gestreamt und dort direkt analysiert. Sofern der Landwirt einverstanden ist, können wir die Daten dann in unsere Cloud übertragen, um unsere Algorithmen betriebsübergreifend trainieren zu können.

Computerworld: Welche technische Infrastruktur nutzen Sie für Ihre Plattform?

Auer: Red Hat OpenShift Container Platform, da diese Lösung weltweit, dezentral und Provider-unabhängig genutzt werden kann.

Computerworld: Wie funktioniert die Datenauswertung?

Auer: Mit Hilfe von Machine Learning haben wir über 20 Algorithmen entwickelt, die anhand der erfassten Daten eine Prognose ermöglichen. Dabei versuchen wir, so wenig Datenquellen wie möglich zu nutzen und so viele Informationen wie möglich daraus zu generieren.

Computerworld: Vernetzen Sie Ihre Daten mit anderen Informationsquellen?

Auer: Prinzipiell wäre das denkbar. Leider sind die Daten vieler Fütterungs- oder Melksysteme nicht offen zugänglich und nicht normalisiert. Dabei wäre es ausgesprochen hilfreich, wenn die Daten in offenen Formaten zur Verfügung stehen würden.

Computerworld: Sind alle Kühe gleich?

Auer: Ganz und gar nicht, es gibt sehr aktive und ruhigere Tiere. Das System lernt, solche individuellen Unterschiede zu erkennen, und generiert für jedes Tier sozusagen ein «Normalprofil».

Computerworld: Wie lange dauert das?

Auer: Unsere KI kann sich in zwei bis drei Tagen an jeden Stall anpassen.

Computerworld: Spielen auch Umweltparameter eine Rolle?

Auer: Gewiss. Eine Kuh in Kanada wird sich bei 40 Grad minus Aussentemperatur anders verhalten als eine in Dubai bei 40 Grad plus. Auch verändert sich das Verhalten etwa bei einer Futterumstellung oder wenn eine Klauenpflege ansteht. Solche Einflüsse können wir aber erkennen und entsprechend berücksichtigen.

Computerworld: Was hat der Landwirt von Ihren Ohrmarken?

Auer: Er kann Stress- und Krankheitssymptome, aber auch den Beginn einer Brunst frühzeitig bemerken und Massnahmen ergreifen. Dadurch vermeidet er einen Abfall in der Milchleistung, braucht weniger Medikamente und erhöht den Besamungserfolg. Durch die genaue Ortung der Kühe weiss er zudem immer, wo sich jedes Tier befindet, verschwendet keine Zeit bei der Suche und kann Optimierungsmöglichkeiten im Stall erkennen.