10.02.2006, 19:34 Uhr

Infiniband wird reanimiert

Infiniband galt lange als schneller Nachfolger des PCI-Bus, wurde dann aber nur mehr im High-Performance-Computing eingesetzt. Jetzt scheint sich das I/O-System doch noch im kommerziellen Umfeld zu etablieren.

Bereits Mitte 2000 legte die Infiniband Trade Association (IBTA) die erste Spezifikation der I/O-Schnittstelle vor, die zukünftig in Servern, Speichern und Netzgeräten für mehr Datendurchsatz sorgen sollte. Damals konnte sich Infiniband im Massenmarkt aber nicht durchsetzen, weil die Schwergewichte Intel und Microsoft ihre Entwicklung und Unterstützung dafür weitgehend einstellten und stattdessen den PCI-X-Bus favorisierten. Infiniband wurde zum Nischenprodukt - allerdings in prominentem Umfeld: Das High-Performance-Computing (HPC) entdeckte die Vorzüge der Architektur und koppelte über Infiniband Server zu Cluster-Verbünden.

Raus aus der Nische

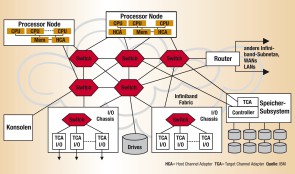

Jetzt scheint die Schnittstelle aus dem wissenschaftlich-technischen Bereich in den kommerziellen Markt zurückzukehren. Die IBTA hat mittlerweile über 70 Mitglieder und arbeitet an Spezifikationen, die Durchsatzraten von bis zu 120 GBit pro Sekunde ermöglichen sollen. In Zukunft wird Infiniband nach Meinung der IBTA nicht nur zur Rechnerkopplung verwendet werden, sondern auch Speichergeräte mit Servern und Clustern verbinden und Blade-Rechnern mehr I/O-Bandbreite verschaffen. Zudem lässt sich die Schnittstelle auch im Rechner für einen schnellen und verzögerungsarmen Datentransfer zwischen Prozessor und I/O-System nutzen. Infiniband ist ein Konzept für die schnelle Datenkommunikation, das nicht als Bus, sondern als «Switched Fabric» entworfen wurde. Es basiert auf Punkt-zu-Punkt-Verbindungen, die voll duplex kommunizieren und je Leitung eine Transferleistung von 2,5 GBit in der Sekunde liefern. Durch Bündelung der Kanäle erreicht man derzeit eine Geschwindigkeit von 10 (4X) bis 30 (12X) GBit pro Sekunde. Zum Vergleich: Die neuste Version des Fibre Channel bietet eine Transferrate von lediglich 4 GBit pro Sekunde. Die angeschlossenen Komponenten sind über den I/O-Switch verbunden. Die komplette Architektur besteht aus dem Host Channel Adapter (HCA), dem Target Channel Adapater (TCA), dem Switch und dem Router. Jede Komponente hat mindestens einen Port, über den sie mit einer anderen verbunden ist. Der Switch erlaubt den Aufbau von Multi-Punkt-Verbindungen. Die Datenübertragung erfolgt paketorientiert, wobei jedes Datenpaket eine Länge von 4096 Bytes aufweist. Als Übertragungsmedium können Kupfer- und Lichtwellenleiter verwendet werden.

Neue Einsatzgebiete

Zusätzlich zu dem schon bewährten Einsatz von Infiniband zum Aufbau von Clustern im HPC-Bereich tauchen jetzt neue Anwendungen auf. So will beispielsweise IBM heuer ein neues Gehäuse für die Blade-Server auf den Markt bringen, dessen Backplane Daten mit bis zu 40 Gigabit in der Sekunde transferiert und damit für Infiniband-Umgebungen geeignet ist. Big Blue hat zudem im Rahmen der Campus-Forschung «Extreme Blue» unter anderem das Entwicklungsprojekt «Infiniband Onloading for Microprocessors» aufgelegt. Gesucht wird ein neuer Kommunikationsweg, der nicht mehr über den Hauptspeicher, sondern über den näher am Prozessor befindlichen Cache-Speicher führen soll. SGI nutzt die schnelle Interconnect-Lösung für die Kopplung von Speicher und Server: Die Company stellte Ende letztes Jahr auf der Supercomputing-Messe SC05 in Seattle eine Server-to-Storage-Lösung vor, bei der das Disk-Array TP0700 über eine Infiniband-Schnittstelle nativ an die Infiniband-Fabric angeschlossen und darüber mit einem Cluster verbunden wird.

Fibre Channel eingespart

SGI erwartet sich neben dem Geschwindigkeitsvorteil hauptsächlich eine Vereinfachung bei der Speicheranbindung an ein Infiniband-Cluster. Bislang mussten die Speicher mit Fibre-Channel-Platten wegen der Protokollkonvertierung entweder über ein Gateway an die Infiniband-Fabric angebunden oder ein eigenes FC-Netz aufgebaut werden. Die Company erwartet, dass sich für eine solche Lösung auch Firmen aus dem kommerziellen Umfeld interessieren, die mit großen Datenbergen kämpfen. Das Herzstück der SGI-Lösung liefert Engenio (vormals LSI Logic) mit dem Controller und dem modular aufgebauten Array 6498 mit nativer Infiniband-Unterstützung. Die dual-active Raid-Controller liefern vier Kanäle mit einer Transfergeschwindigkeit von jeweils 10 GBit pro Sekunde. Auf Laufwerksseite können bis zu 224 Platten vom Typ Fibre Channel oder SATA (Serial ATA) angeschlossen werden. Die Anbindung von Speichern an Server-Cluster verspricht ein lukrativer Markt zu werden, denn derzeit geht etwa die Hälfte der neu ausgelieferten Festplattenkapazitäten an solche Rechnerverbünde. Falconstor, Spezialist für Speichersoftware, und Voltaire, Entwickler von Hardware-Infrastrukturlösungen für Grid-Computing, wollen sich von diesem Markt ebenfalls ein Stück einverleiben. Auch sie liefern eine Speicherlösung mit nativer Infiniband-Unterstützung.

ISCSI über Infiniband

Voltaire, an der unter anderem Hitachi und Quantum beteiligt sind, hat für ihre Produkte das ISER-Protokoll entwickelt, das ISCSI über Inifiniband möglich macht. Zusammen mit Falconstors Replikations-, Backup- und Recovery-Software IP-Stor sollen sich heterogene Speicherumgebungen über ein Protokoll und eine Management-Infrastruktur aufbauen lassen, die mit Transferraten von 10 GBit pro Sekunde arbeiten und billiger als Fibre-Channel zu betreiben sind, verspricht die Herstellerin.Voltaire ist auch Begünstigte eines Open-Source-Programms, das das US-Department of Energy (DOE) aufgelegt hat. Das Ministerium hat an Intel, Voltaire und Topspin den Auftrag vergeben, eine einheitliche Software für den Einsatz von Infiniband auf Open-Source-Rechnern zu entwickeln und der Open-IB-Allianz zur Verfügung zu stellen.

Kriemhilde Klippstaetter