Datenanalyse-Tools

16.11.2018, 09:30 Uhr

Data Science für Nicht-Programmierer

Selfservice-Plattformen sollen selbst anspruchsvolle Big-Data-Analysen bewältigen. Damit steht Data Science auch Unternehmen ohne eigenen Datenwissenschaftlern zur Verfügung.

Data Science – was ist das überhaupt? Der amerikanische Psychologe und Verhaltensökonom Dan Ariely hat einen drastischen Vergleich für den in Mode gekommenen Umgang mit riesigen Datensammlungen gefunden: Big Data sei «wie Teenager-Sex – alle reden drüber, keiner weiss wirklich wie’s geht, aber weil alle denken, die anderen täten es bereits, behauptet jeder, es auch zu tun».

Tatsächlich bezeichnet der Begriff Data Science ein interdisziplinäres Arbeitsfeld, das Methoden aus der Statistik, Informatik, Datenverwaltung, Archivierung, Programmierung und verwandten Gebieten nutzt, um in sehr grossen Datenbeständen sinnvolle Informationen zu erkennen, sie zu isolieren, zu analysieren und daraus Handlungsempfehlungen für Unternehmensleitung und Management abzuleiten.

Die zugehörige Berufsbezeichnung lautet Data Scientist, im Deutschen auch Datenwissenschaftler. Dieser Spezialist sollte neben Branchenwissen über Kenntnisse in statistischen Programmiersprachen zum Aufbau von Datenverarbeitungssystemen, Datenbanken und Visualisierungswerkzeugen verfügen. Denn seine Aufgabe ist es, sowohl verwertbare Ergebnisse aus dem zur Verfügung stehenden, oft unstrukturierten Datenmaterial zu extrahieren, als auch die gewonnenen Einsichten für alle Unternehmensebenen verständlich aufzubereiten und zu präsentieren.

Der Weg zur Data Science

Dem Data Scientist helfen Abfrage- und Analyse-Tools, angeführt von diversen Programmiersprachen, die, wie etwa die Open-Source-Sprache R, besonders für statistische Aufgaben und die Ausgabe von Grafiken geeignet sind. Entsprechend sind Codierkenntnisse sowie der Umgang mit Programmier- und Abfragesprachen wie Python, R, C/C++ oder SQL eigentlich ein integraler Bestandteil der Datenwissenschaft. Wer Programmierlogik, Schleifen und Funktionen versteht, hat deutlich höhere Chancen, erfolgreich eine Karriere als Datenwissenschaftler zu durchlaufen.

Der Weg zu einem der begehrten und meist hoch dotierten Jobs in diesem Aufgabenfeld führt in den meisten Fällen über die Universität. Mehrere Hochschulen im deutschsprachigen Raum, etwa München, Stuttgart, Mannheim, Marburg und Darmstadt, bieten gegenwärtig Bachelor- oder Masterstudiengänge im Fach Data Science an. Weitere kommen ständig hinzu. Daneben gibt es aber auch spezialisierte Weiterbildungsangebote sowie berufsbegleitende Studiengänge, die engagierte Datengräber ans Ziel führen.

Auf dem Höhepunkt der digitalen Transformation und dem damit verbundenen Boom der Datenanalyse ist die Nachfrage vonseiten der Unternehmen dennoch höher als das Angebot an ausgebildeten Datenwissenschaftlern. Gleichzeitig sind auch viele Beschäftigte daran interessiert, diese Richtung einzuschlagen, obwohl sie sich mit Codierung nie zuvor beschäftigt haben. Das wirft die Frage auf: Wie stehen die Chancen für Nicht-Programmierer, als Data Scientist erfolgreich tätig zu werden?

Tools für Nicht-Programmierer

Der typische Datenwissenschaftler ist wissbegierig und stets auf der Suche nach neuen Werkzeugen, die ihm helfen, seine Kenntnisse zu vertiefen und neue Antworten zu finden. Und es gibt in der Tat Tools, die hier einen möglichen Ausweg oder zumindest einen Einstieg für Lernwillige bieten. Sie klammern den Programmieraspekt weitgehend aus und setzen zur Bedienung auf eine benutzerfreundliche grafische Oberfläche. So kann sie im Grunde jeder mit minimalen Kenntnissen von Algorithmen einsetzen, um Maschinenlernprozesse oder Vorhersagemodelle zu erstellen.

Viele Unternehmen, denen ausgebildete Spezialisten fehlen oder die gar keine volle Stelle für dieses Aufgabengebiet einrichten wollen oder können, ziehen solche GUI-gestützten Data-Science-Tools als Alternative in Betracht. Dabei gilt allerdings auch hier, dass es die eierlegende Wollmilchsau nun einmal nicht gibt. Komfort bei der Bedienung und Vereinfachungen bei der Modellierung bezahlt man letztlich mit Einschränkungen hinsichtlich Flexibilität und Vielseitigkeit der Lösung.

Dazu kommt, dass die gewonnenen Erkenntnisse meist nicht selbsterklärend sind, sie wollen interpretiert werden. Und gerade bei der Auswertung grosser, unstrukturierter Datenbestände sind die Zusammenhänge selten eindeutig, Korrelation bedingt nicht zwangsläufig Kausalität. Berühmt-berüchtigt ist das Beispiel mit dem Vogel: In einem nördlichen Bundesland beobachteten Statistiker, dass in Jahren, in denen besonders viele Störche aus dem Süden zurückkehrten, auch die Geburtenrate in der Bevölkerung signifikant anstieg. Daraus zu schliessen, dass der Storch die Babys bringt, wäre jedoch abenteuerlich.

Auch weitgehend automatisierte und bedienfreundliche Data-Science-Tools sind also letzten Endes kein Ersatz für einen gut ausgebildeten und findigen Spezialisten, wenn ein Unternehmen im Zuge der digitalen Transformation verstärkt auf Big Data setzt. Was sie leisten können, ist hingegen eine gewisse Demokratisierung der Methodik, indem sie auch unausgebildeten Nutzern einen Zugang zu einfachen Modellen bieten. Und sie können den Einstieg ermöglichen, wenn ein Unternehmen noch vor der Frage steht, ob Data Science in grossem Umfang in die Geschäftsprozesse einfliessen sollte oder nicht.

Im Folgenden stellt com! professional sechs Lösungen vor, die erfolgreiches Data Mining auch ohne Universitätsabschluss versprechen: RapidMiner, DataRobot, Driverless AI, Alteryx, BigML und Trifacta Wrangler.

RapidMiner

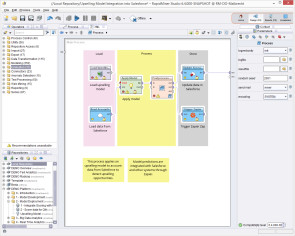

RapidMiner ist eine Data-Science-Plattform, die eine integrierte Umgebung für maschinelles Lernen, Deep Learning, Text- und Data Mining, Business Analytics sowie Predictive Analytics bietet. Dabei sollen sich die einzelnen Produkte RapidMiner Studio, Server, Radoop und Streams sowohl für Business-Anwendungen wie für Ausbildung, Training, Rapid Prototyping oder zur Anwendungsentwicklung eignen.

RapidMiner Studio ist eine visuelle Design-Umgebung zum schnellen Aufbau vollständiger prädiktiver Analyse-Workflows unter einer grafischen Oberfläche. Die Workflows werden als Prozesse bezeichnet und bestehen aus mehreren Operatoren. Jeder Operator führt im Prozess eine einzelne Aufgabe aus, die Ausgabe eines Operators bildet jeweils die Eingabe für den nächsten. Die Engine kann von anderen Programmen aufgerufen oder als API verwendet werden.

Studio verfügt über eine umfangreiche Bibliothek mit Algorithmen für maschinelles Lernen, Datenaufbereitung und -exploration sowie Modellvalidierungs-Tools zur Unterstützung nahezu beliebiger Data-Science-Projekte und Anwendungsfälle. Dank offener APIs lassen sich auch vorhandene, spezialisierte Algorithmen integrieren. Ausserdem kann die Funktionalität mit zusätzlichen Plug-ins erweitert werden. Ein Extensions-Marktplatz bietet Entwicklern eine Plattform, um Datenanalyse-Algorithmen zu veröffentlichen.

Mit RapidMiner Server lässt sich das Programm auf Unternehmens-Hardware von jedem Gerät ohne Einschränkungen ausführen. Der Server kann verwendet werden, um Analysen zu planen, auszuführen und Echtzeitergebnisse zu erhalten. Er lässt sich in alle Datenquellen integrieren und erlaubt den Einsatz eigener Algorithmen fürs Data Mining. Über interaktive Dashboards kann man auf Informationen zugreifen, sie überwachen und freigeben sowie Aufgaben zuweisen.

RapidMiner Radoop bietet eine Plattform für die Verarbeitung von Big Data, einschliesslich Analysen und Vorhersagen. Dazu gehört eine visuelle Schnittstelle für Big-Data-ETL (Extract, Transform, Load), Analysen, Ad-hoc-Reporting, prädiktive Modellierung und Visualisierung.

Mit RapidMiner Streams schliesslich lassen sich Verarbeitungsanwendungen ohne Code streamen. So können Streaming-Analysen auf verteilten Apache-Storm-Clustern für das Datenmischen und Modell-Scoring bei Streaming-Daten bereitgestellt werden.

Neben der Möglichkeit, komplexe Workflows über die grafische Bedienoberfläche zu erstellen, unterstützt RapidMiner auch Skripting in mehreren Sprachen. Das System vereinfacht den Datenzugriff und ermöglicht das Laden und die Auswertung aller Arten von Daten, einschliesslich Texten, Bildern und Audiotracks.

DataRobot

DataRobot will eine maschinelle Lernplattform für Datenwissenschaftler aller Fähigkeitsstufen bieten. Das Ziel ist, präzise Vorhersagemodelle in einem Bruchteil der bisher benötigten Zeit zu erstellen und einzusetzen. Auch hier hat man den kritischen Mangel an Datenwissenschaftlern erkannt und will das Problem adressieren, indem Geschwindigkeit und Wirtschaftlichkeit der Vorhersageanalytik verbessert werden, um Zeit zu sparen.

Die Plattform verwendet daher massiv parallele Verarbeitung, um Modelle in R, Python, Spark MLlib, H2O und anderen Open-Source-Bibliotheken zu trainieren und zu bewerten. Dabei werden Millionen möglicher Kombinationen von Algorithmen, Vorverarbeitungsschritten, Features, Transformationen und Optimierungsparametern durchsucht, um die besten Modelle für die jeweiligen Datasets und Vorhersageziele zu liefern. Der Vorgang ist transparent, sodass der Benutzer die Gültigkeit seiner Ergebnisse verfolgen und überprüfen kann. Darüber hinaus lassen sich eigene Modelle auf der Plattform programmieren, trainieren, testen und vergleichen.

Da maschinelles Lernen ständig mehr Geschäftsprozesse beeinflusst, sind neben der Leistung auch Sicherheit und Integrationsfähigkeit der Plattform von wesentlicher Bedeutung. Zu seinen Stärken zählt DataRobot eine hohe Verfügbarkeit von 99,99 Prozent, eine verteilte und «selbstheilende» Architektur, die Möglichkeit zur nahtlosen Integration in Unternehmenssicherheits-Technologien, Plug and Play von Hadoop sowie zahlreiche gängige Datenbankzertifizierungen.

Das System kann auf dem Hadoop-Cluster ausgeführt werden und bringt damit eine integrierte maschinelle Lernautomatisierung auf den Hadoop-Stack. Mit Spark für die Verarbeitung grosser Datenmengen ist es für Datensicherheit und -management ausgelegt. So sind Machine-Learning-Datenobjekte und -Operationen für Hadoop-Managementprozesse und -Richtlinien sichtbar und stehen unter deren Kontrolle.

DataRobot findet auch wichtige Treiber in Geschäftsmetriken, identifiziert Schlüsselwörter und Phrasen in unstrukturiertem Text und kann grundlegende Visualisierungen seiner Ergebnisse ausgeben.

Wichtig ist, dass das System bei all dem nicht dazu gedacht oder geeignet ist, den Datenwissenschaftler zu ersetzen, sondern seine Arbeit vielmehr zu unterstützen und zu verbessern. DataRobot-Anwender brauchen daher zumindest ein grundlegendes Verständnis von Data-Science-Methoden und Business-Intelligence-Tools wie Tableau oder Excel.

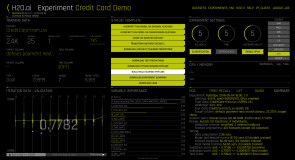

Driverless AI

Driverless AI von H2O.ai soll die Schwelle beim Einsatz von Data Science im Unternehmenskontext senken. Die Automatisierungsplattform unterstützt nichttechnische Mitarbeiter bei der Aufbereitung der Daten, der Kalibrierung der Parameter und dem Finden optimaler Algorithmen zur Lösung spezifischer Probleme mit maschinellem Lernen.

Solche Probleme sind oft komplex und unvorhersehbar. In der Praxis nutzen heute viele Unternehmen maschinelles Lernen für relativ vorhersehbare Fälle wie die Auswertung von Ausfallraten, doch selbst diese relativ einfachen Probleme sind für nichttechnische Mitarbeiter oft schwer zu durchschauen. Driverless AI automatisiert deshalb viele der Entscheidungen, die bei der Vorbereitung eines Modells getroffen werden müssen.

Trotz einer Reihe von eingebauten Use-Cases, die Benutzer an ihre eigenen Bedürfnisse anpassen können, löst das Tool allerdings nicht jedes Lernproblem automatisch. Es zielt vielmehr darauf ab, genügend Standardmodelle zu finden und einzustellen, um zumindest einen möglichst grossen Teil der Abläufe zu automatisieren. So sollen auch Benutzer ohne fachspezifisches Know-how in die Lage versetzt werden, mit der Komplexität von Big Data umzugehen.

Dazu unterstützt das System GPU-Beschleunigung, XGBoost, Multi-GPUs, K-Means, GLM und weitere Verfahren, um eine bessere Leistung zu erzielen. AlphaGo für AI erhöht die Genauigkeit durch automatisches Feature-Engineering, während automatisches maschinelles Lernen dabei hilft, die richtigen Modelle zu finden und anzupassen, um den unterschiedlichen Geschäftsanforderungen gerecht zu werden.

Insgesamt zielt Driverless AI also – im Gegensatz etwa zu DataRobot – darauf ab, Data Science und KI für Unternehmen nutzbar zu machen, ohne dass diese über ausgewiesene Datenwissenschaftler verfügen müssen, indem es nichttechnischen Benutzern erlaubt, mit leistungsstarker Technologie zu experimentieren.

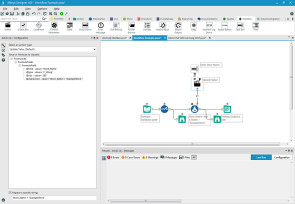

Alteryx

Alteryx ist zugeschnitten auf die Bedürfnisse von Business-Analysten, die eine Selfservice-Lösung suchen. Die Plattform besteht aus drei Komponenten namens Galerie, Designer und Server, die jeweils auch separat verwendet werden können. Sie ist sowohl vor Ort als auch in der Cloud verfügbar. Abgedeckt werden vor allem Data Blending, Predictive Analytics, Geoanalysen und Sharing Insights

Das System strukturiert und bewertet Input aus verschiedenen externen Quellen und ist besonders darauf ausgelegt, die Daten in sich wiederholende Arbeitsabläufe zu überführen, zu mischen und zu umfassenden Erkenntnissen zusammenzufassen. Eine Reihe R-basierter Vorhersagewerkzeuge erstellt Berichte. Hadoop-Abfragen können in jede Datenquelle integriert werden, die später verwendet werden soll.

Dank Drag-and-Drop-Schnittstelle sollen vor allem erfahrene Analysten wenig Zeit zur Einarbeitung benötigen. Gleichzeitig will man einen für BI ungewöhnlich hohen Grad an Anpassung und Personalisierung bieten. Alteryx ist mit offenen APIs ausgestattet, über die sich die Fähigkeiten der Software bei Bedarf erweitern lassen. Sie sammelt Daten in allen Formaten und aus beliebigen Quellen wie Datenbanken, Warehouses, Hadoop-Stores oder Office-Dateien und übergibt sie sofort an Scripting-Tools, die sie in die vorhandenen Informationen integrieren. Laut Anbieter soll der Workflow für die Datenmischung bis zu 100-mal schneller als herkömmliche Ansätze arbeiten. In Sachen Predictive Analytics betont man die einfachen und intuitiven Funktionen der Software. Im Gegensatz zu herkömmlichen Systemen, die nur von erfahrenen Datenwissenschaftlern abgefragt werden können, soll Alteryx die Verwendung von Prognosefunktionen für alle Benutzer ermöglichen.

Auch auf Analyseebene verfügt Alteryx über komfortable Tools, um Infos aus allen Kanälen und Systemen zusammenzuführen. Sie ermöglichen etwa einen einfachen Zugriff auf Big-Data- und Kundenanalysen, Darüber hinaus gibt es eine Customer-Churn-Analytics-Funktion, die alle Kundendaten kombiniert und Vorhersagen über die Wahrscheinlichkeit von Abwanderungen oder Ausfallraten ermöglicht.

Alteryx arbeitet auch mit Salesforce zusammen und ergänzt die dortigen Informationen zum Kundenbeziehungsmanagement um umfangreiche Daten wie demografische Merkmale, geografische Daten und Segmentierung.

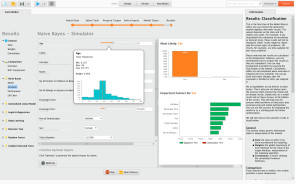

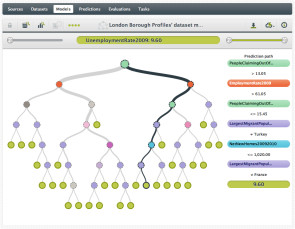

BigML

BigML ist eine pragmatische und dank grafischer Oberfläche einfach zu bedienende Plattform zum Erstellen leistungsfähiger Vorhersagemodelle. Die cloudbasierte Machine-Learning-Plattform kombiniert überwachtes und unüberwachtes Lernen, Anomalie-Erkennung, Datenvisualisierungs-Tools und Mechanismen zur Datenanalyse. Resultierende Vorhersagemodelle können in verschiedenen Formaten und Sprachen exportiert werden und lassen sich über eine REST-API einfach in Produktionsanwendungen einbinden. Die Zielgruppe sind mittlere und grosse Unternehmen, die die Vorteile des maschinellen Lernens ohne grosse Vorlaufkosten oder Implementierungsverzögerungen ausprobieren beziehungsweise nutzen möchten.

Die Nutzer von BigML kommen aus zahlreichen Branchen. Die integrierten Anomalie-Erkennungsalgorithmen sind ideal für die Betrugserkennung und finden daher bevorzugt bei Finanzdienstleistern Anwendung. Die Clustering-Methoden eignen sich zur Untersuchung des Marktverhaltens und aller Daten, aus denen sich ein Gruppenverhalten ableiten lässt. Per überwachtem Lernen können Prognosemodelle entwickelt werden, mit denen sich etwa Projektkosten, aber auch Kundenabwanderung oder andere Verhaltensweisen vorhersagen lassen. BigML bietet hier bereits eine Sammlung von Vorlagen für Vorhersagemodelle, die diverse Geschäftsprobleme abdecken.

Als cloudbasiertes System wird BigML über den Browser bedient. Daten können über mehrere Mechanismen geladen werden, auch per Direktzugriff auf Cloud-Dienste wie Amazon S3. Für Bereinigung, Normalisierung, Transformation und Feature-Engineering stehen zahlreiche Tools zur Datenvorbereitung zur Verfügung. Dabei erkennt und formatiert BigML Daten automatisch nach ihrem Typ. Zu einzelnen Attributen werden jeweils Metadaten angezeigt. Nützlich ist auch ein integriertes Verteilungsdiagramm.

Das unüberwachte Lernen basiert auf Clusterbildung und wird eingesetzt bei der Kundensegmentierung, Betrugserkennung, Objektverifizierung und etlichen anderen Anwendungen. Die überwachten Lernalgorithmen verwenden CART-Tree-ähnliche Klassifizierer und Entscheidungsbäume. Typische Anwendungen hierfür sind beispielsweise Credit Scoring, Churn Prevention und Predictive Maintenance. Die Anomalie-Erkennung isoliert und bewertet Anomalien und kann zur Verhaltensauthentifizierung, zur Datenbereinigung, für Intrusion Detection oder auch Videoüberwachung verwendet werden.

In der Benutzerumgebung lassen sich per Drag and Drop interaktive Grafiken erzeugen, anhand derer Daten und Modelldetails genauer untersucht werden können. Zur Modellauswertung dienen Splits in Trainings- und Testdaten sowie eine Konfusionsmatrix-Identifikation von Falschpositiven und Negativen. Die entstandenen Modelle können in Java, Python, Node.js und Ruby sowie ins Tableau- oder Excel-Format exportiert werden.

Trifacta Wrangler

Trifacta Wrangler ist ein cloudbasiertes Datenaufbereitungs-Tool, dessen Hauptzweck darin besteht, die Daten für die Analyse mit anderen Tools in Form zu bringen. Zu den wichtigsten Funktionen der Software gehören deshalb die Strukturierung, Anreicherung, Bereinigung und Validierung von Daten.

Eine kostenlose Wrangler-Version, die von der Betreiber-Website heruntergeladen werden kann, erlaubt es, bis zu 100 MB grosse Dateien zu bearbeiten. Die kostenpflichtige Variante bietet mehr Leistung, Zugriff auf zusätzliche Datenquellen wie Hadoop und Amazon S3 sowie erweiterte Funktionen, zum Beispiel Stichproben.

Trifacta Wrangler integriert sich in On-Premise-Plattformen wie Cloudera, Hortonworks und MapR sowie in cloudbasierte Dienste wie AWS, Google Cloud oder Microsoft Azure. Verfügbar sind ausserdem Integrationen mit BlueData, Hadoop, Atlas, Qlik, Salesforce, Alation und einigen anderen.

Trifacta bietet native Unterstützung für komplexere Datenformate wie JSON, Avro, ORC oder Parquet und nutzt die Multi-Workload-Fähigkeiten von Hadoop zur Skalierung der Datentransformation. Visual Data Profiling ermöglicht einen sofortigen Einblick in einzelne Elemente des Datensatzes wie Datenverteilung und Ausreisser, um Transformation und Analyse zu unterstützen.

Die Datenanreicherungsfunktionen erleichtern die Standardisierung von Daten, die Verknüpfung von Datensätzen und die Aggregation von Datenausgaben auf die richtige Ebene. Erweiterte visuelle Datenprofilierungsfunktionen verschaffen dem Benutzer ein besseres Verständnis der Eigenschaften eines Datensatzes.

Die Bedienung erfolgt im Wesentlichen per Mausklick oder Drag and Drop. Für jede Aktion des Benutzers generiert Trifacta eine Codezeile. Das so entstandene Skript lässt sich dann auch aufrufen und direkt im Editor optimieren. Über dessen eigene Wrangle-Skriptsprache lassen sich ausserdem weitere Funktionen ausführen, die keine GUI-Entsprechung haben.

Die Software erledigt Transformationen wie das Ändern von Spaltendatentypen, das Filtern nach verschiedenen Kriterien, das Aufteilen von Spalten, das Verbinden und Aggregieren mehrerer Datenquellen sowie das Neuordnen von Spalten.

Data Science Tools (Auswahl)

| Data Science Tools (Auswahl) | |

| Anbieter / Produkt | Beschreibung |

| Alteryx / Alteryx Platform | Selfservice-Datenanalyse-Plattform für Datenexploration, Modellierung und Analyse auch ohne Programmierung. Dank Drag-and-Drop-Schnittstelle sollen vor allem erfahrene Analysten wenig Zeit zur Einarbeitung benötigen |

| BigML / BigML | Cloudbasierte, pragmatische und dank grafischer Oberfläche einfach zu bedienende Machine-Learning-Plattform zum Erstellen leistungsfähiger Vorhersagemodelle |

| DataRobot / DataRobot Cloud | Machine-Learning-Plattform für Datenwissenschaftler, darauf ausgelegt, präzise Vorhersagemodelle in einem Bruchteil der früher benötigten Zeit zu erstellen und einzusetzen |

| H2O.ai / Driverless AI | Die Automatisierungsplattform unterstützt nichttechnische Mitarbeiter bei der Aufbereitung von Daten und dem Finden optimaler Algorithmen zur Lösung spezifischer Probleme mit maschinellem Lernen |

| RapidMiner / Studio | Data-Science-Plattform, die eine integrierte Umgebung für maschinelles Lernen, Deep Learning, Text- und Data Mining, Business Analytics sowie Predictive Analytics bietet |

| Trifacta / Wrangler | Cloudbasiertes Datenaufbereitungs-Tool, dessen Hauptzweck darin besteht, Datenbestände für die Analyse mit anderen Tools zu strukturieren und in Form zu bringen |

Data Science Tools (Auswahl)

| Data Science Tools (Auswahl) | |

| Anbieter / Produkt | Beschreibung |

| Alteryx / Alteryx Platform | Selfservice-Datenanalyse-Plattform für Datenexploration, Modellierung und Analyse auch ohne Programmierung. Dank Drag-and-Drop-Schnittstelle sollen vor allem erfahrene Analysten wenig Zeit zur Einarbeitung benötigen |

| BigML / BigML | Cloudbasierte, pragmatische und dank grafischer Oberfläche einfach zu bedienende Machine-Learning-Plattform zum Erstellen leistungsfähiger Vorhersagemodelle |

| DataRobot / DataRobot Cloud | Machine-Learning-Plattform für Datenwissenschaftler, darauf ausgelegt, präzise Vorhersagemodelle in einem Bruchteil der früher benötigten Zeit zu erstellen und einzusetzen |

| H2O.ai / Driverless AI | Die Automatisierungsplattform unterstützt nichttechnische Mitarbeiter bei der Aufbereitung von Daten und dem Finden optimaler Algorithmen zur Lösung spezifischer Probleme mit maschinellem Lernen |

| RapidMiner / Studio | Data-Science-Plattform, die eine integrierte Umgebung für maschinelles Lernen, Deep Learning, Text- und Data Mining, Business Analytics sowie Predictive Analytics bietet |

| Trifacta / Wrangler | Cloudbasiertes Datenaufbereitungs-Tool, dessen Hauptzweck darin besteht, Datenbestände für die Analyse mit anderen Tools zu strukturieren und in Form zu bringen |

Eine Farbkodierung zeigt im Transformationseditor die Datenqualität an – Grün gibt den Anteil der Zeilen wieder, die Einträge des richtigen Typs enthalten, andere Farben verweisen auf fehlende oder inkorrekte Datensätze. Über jeder Spalte sorgt ausserdem ein Histogramm für eine grundlegende Vorstellung von der Datenverteilung.

Qualitätsbalken und Histogramm bieten einen schnellen und grundlegenden Überblick über einen Datensatz, während die Spaltendetailansicht statistische Werte wie Median, Durchschnitt, Standardabweichung, untere und obere Quartile sowie Minimal- und Maximalwerte vermittelt.

Dank der grafischen Bedienoberfläche gestaltet sich die Arbeit mit Trifacta einfacher, als wenn man eigene Skripts von Grund auf neu schreiben müsste. Andererseits ist man dafür natürlich weniger flexibel als bei Nutzung einer Sprache wie R. Die Grenzen der gewöhnlichen Mausschnittstelle lassen sich überwinden, indem man Trifactas Wrangle-Sprache verwendet, allerdings muss der Benutzer einiges an Zeit investieren, um sich in die Skriptsprache einzuarbeiten.

Autor(in)

Charles

Glimm