16.02.2006, 19:23 Uhr

Selbst ist das System

Mit Autonomic Computing sind IT-Systeme in der Lage, sich selbst zu verwalten und zu optimieren. Scheduling-Lösungen wenden dieses Konzept nun auf die IT-Prozesse an und erreichen so eine effizientere Prozesssteuerung.

Detlev Schmitz ist Leiter Zentraleuropa bei Orsyp.

Die Administration von IT-Systemen ist in den letzten Jahren schwieriger geworden. Die Zusammenführung heterogener Landschaften, die Herstellung direkter IT-Verbindungen zwischen den Unternehmen, die umfassenden Web-Anbindungen, die Integration der Unternehmenskommunikation: all das hat dazu geführt, dass die Systeme erheblich komplexer geworden sind. Dabei hat sich die Rolle der IT im Unternehmen im letzten Jahrzehnt verschoben, von deren reibungslosen Funktionieren ein Unternehmen heute als Ganzes abhängig ist. Damit sind auch die Anforderungen an die Qualität der IT-Prozesse gewachsen: früher hat man sie notfalls manuell substituiert. Konnte die EDV etwa Lieferscheine nicht erstellen, musste man sie eben anders schreiben. Solche Behelfe funktionieren heute nirgends mehr: Lieferscheine enthalten beispielsweise Barcodes, ohne die die Verbuchung des Warenausgangs nicht erfolgen kann - und möglicherweise auch nicht der Wareneingang beim Kunden. Die gewachsene Bedeutung einzelner IT-Prozesse für die Unternehmen, aber auch für die gesamte Wirtschaft, hat im Übrigen auch in den übergreifenden Vorschriften zu IT-Compliance und -Governance ihren Ausdruck gefunden. Dabei stellen Regelwerke wie Basel II oder Sarbanes-Oxley an den IT-Betrieb erhebliche zusätzliche Anforderungen hinsichtlich Zuverlässigkeit, Dokumentation und Nachvollziehbarkeit.

Zugleich werden die IT-Budgets aber nun schon seit Jahren kurz gehalten und eine Entspannung ist nicht absehbar. Für die IT-Administration bedeutet das, dass sie in einem technisch zunehmend schwieriger werdenden Umfeld höhere Anforderungen hinsichtlich der Prozessqualität mit tendenziell geringeren Ressourcen nachkommen muss. So war bis vor einigen Jahren die durchgängige Besetzung von Rechenzentren eine Selbstverständlichkeit; nur bei Anwesenheit von Administratoren liess sich ein kontinuierlicher 24-Stunden-Betrieb aufrechterhalten. Dies ist heute nur noch in Ausnahmefällen gegeben, die Mannschaften wurden reduziert, Reserven für Nacht- und Wochenendbetrieb oder die Urlaubszeit bestehen meist nicht mehr. Sogar Hochverfügbarkeitssysteme kommen ohne Anwesenheit des Bedienerpersonals aus. An die Stelle der physischen Anwesenheit sind aufwändige Fehler-Management-Systeme, automatische Alert-Verfahren per E-Mail oder SMS sowie der Remote-Zugriff von Mitarbeitern getreten.

Dass solche Lösungen die Komplexität der Systeme weiter erhöhen, mag man, solange sie funktionieren, noch hinnehmen. Grundsätzlich kann die Lösung des RZ-Dilemmas - mit immer geringeren Ressourcen muss eine immer höhere Prozessqualität bereitgestellt werden - jedoch nicht durch die Verlagerung von klassischen Verfahren zur Fehlerbehebung in die Remote-Sphäre bestehen. Es muss vielmehr eine Veränderung der betreffenden IT-Prozesse selbst erfolgen: Sie sollen sich in Zukunft um ihre Komplexität selber kümmern und so für einen effizienten, administrationsfreien IT-Betrieb sorgen.

Selbst ist das System

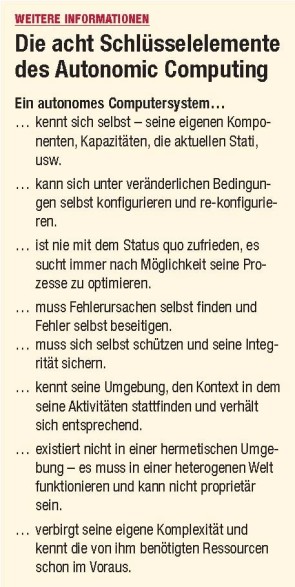

Autonomic Computing Dem Autonomic Computing (AC) liegt die Idee zugrunde, dass die Automatisierung von Verfahren und Abläufen beim IT-Betrieb nicht ausreicht, um die komplexer werdenden Systeme zu beherrschen: Autonomic Computing erweitert die Automatisierung um den Aspekt der Autonomie. Die Systeme sollen damit unabhängig von manuellen Eingriffen eines Betreuers oder Administrators, ohne Korrekturen und Anpassungen laufen, sie sollen sich dabei selbst verwalten und organisieren, Störungen und Fehler selbstständig beheben. Als Vision ist AC schon länger im Gespräch und im Grund träumt die IT davon schon immer; konkret wurde vor rund zwei Jahren IBM, die das Konzept der «Self-Managing Computer Systems» seither propagiert und zum Beispiel mit der Eliza-Technologie in ihre Server-Produkte hat einfliessen lassen. Im Wesentlichen geht es bei AC darum, die aufwändigen, aber auch fehleranfälligen Eingriffe durch Administratoren oder Benutzer von vornherein durch geeignete Algorithmen überflüssig zu machen. Dies ist gerade in Hochverfügbarkeitsszenarien wichtig, wenn die Bediener nicht kontinuierlich zur Verfügung stehen. Vier grundlegende Anforderungen sind dabei an das Self-Management zu stellen:

Self-configuration: Autonome Systeme müssen sich selbstständig installieren, konfigurieren und integrieren. Diese Arbeiten sind bisher besonders zeitaufwändig und fehlerträchtig. Zum Beispiel müssen bei steigender Last zusätzliche Ressourcen ohne spezielle Anforderungen und ohne manuellen Eingriff bereitgestellt werden. Die übrigen System-Komponenten müssen sich dem anpassen.

Self-optimization: Autonome Systeme versuchen selbstständig ihren Betrieb hinsichtlich Performance und Kosten zu verbessern; die dafür notwendigen Parameter werden automatisch überwacht.

Self-protecting: Autonome Systeme schützen sich selbstständig gegenüber Angriffsversuchen oder Fehlersituationen, geben Warnungen weiter.

Wurde dieses Konzept bisher meist hardwareorientiert auf der Ebene der Server, Server-Farmen oder Cluster diskutiert, so rückt neuerdings auch der Aspekt der IT-Prozesse in den AC-Focus. Auch wenn die meisten Benutzer aus der eigenen Anschauung nur die Online-Welt kennen, so bilden in den Unternehmen die automatisch ablaufenden Prozesse nach wie vor das Rückgrat der IT-Verfahren. In diesem Bereich kommt es ja darauf an, die grosse Zahl von Batch-Jobs, in grösseren Unternehmen können das zehntausende pro Tag sein, möglichst reibungslos durch die beteiligten Systeme, Server, Applikationen, Datenbanken und Drucker zu steuern. Diese Batch-Prozesse sind auf grossen Durchsatz ausgerichtet und haben häufig lange Laufzeiten. Sie werden deswegen oft in betriebsschwachen Zeiten, beispielsweise nachts oder am Wochenende ausgeführt, wenn die Beanspruchung der Systeme durch Online-Verfahren schwächer ist. Dann sind allerdings auch keine Administratoren direkt verfügbar. Auch kleine Störungen im Ablauf können daher gravierende Auswirkungen haben: Nicht verbuchte Umsätze, weil eine Datenbank nicht verfügbar war, nicht ausgelieferte Sendungen, weil Lieferscheine nicht gedruckt werden konnten oder nicht überwiesene Gehälter, weil ein Backup-Lauf nicht vorgenommen wurde. Deswegen will heute aber kein Unternehmen die Kosten für eine Rundum-Betreuung durch Fachpersonal tragen. Implizit erwarten die Anwender, dass gerade die Abarbeitung automatischer Prozesse möglichst autonom erfolgt.

Aus diesem Grund findet AC im Bereich des Prozess-Management und des Job-Scheduling ein passendes Einsatzgebiet und erste Anbieter haben ihre Applikationen auch schon auf das AC-Konzept abgestimmt. Diese Scheduling-Systeme sind in der Lage, während der Prozesslaufzeit auf äussere Ereignisse und Vorkommnisse selbstständig zu reagieren und die Ausführung der Prozesse laufend den neuen Gegebenheiten anzupassen. Wichtig ist dabei, dass das Job-Scheduling unabhängig von bestimmten Plattformen und Applikationen funktioniert. Die Komplexität der heterogenen Systeme liesse sich nicht bewältigen, wenn für jedes System eine separate Lösung aufgesetzt werden müsste, die eventuell noch mit aufwändigen Schnittstellen verbunden wären.

Detlef Schmitz