Big-Data-Trends

04.07.2019, 07:01 Uhr

Datenanalysen schlagen das Bauchgefühl

Unternehmen können deutlich von der Erfassung und Auswertung ihrer Daten profitieren. Allerdings müssen die Informationen in geeigneter Form aufbereitet werden, ansonsten sind sie wertlos.

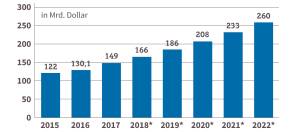

Das weltweite Datenvolumen wächst explosionsartig: Im Jahr 2011 hat es die Marke von 1 Zettabyte überschritten, das sind eine Milliarde Terabyte oder ausgeschrieben eine 1 mit 21 Nullen. Und das Wachstum beschleunigt sich immer stärker. Manche reden bereits von einem Daten-Tsunami. Schon 2020 sollen es schier unvorstellbare 35 Zettabyte sein.

Dass sich aus Daten Nutzwert fürs Unternehmen ableiten lässt, hat sich herumgesprochen. Eine Studie des Digitalverbands Bitkom besagt, dass bereits 57 Prozent der Unternehmen in Deutschland Big Data nutzen oder zumindest planen, entsprechende Techniken einzusetzen. Denn klar ist: Die Daten an sich sind praktisch wertlos, solange sie nicht in geeigneter Form aufbereitet und analysiert werden und die Entscheider Schlussfolgerungen daraus ziehen.

Hier kommt Business Intelligence (BI) ins Spiel - als technikgetriebener Prozess zur Analyse von Daten und zur Präsentation verwertbarer Informationen - der Führungskräften dabei helfen soll, fundiertere Geschäftsentscheidungen zu treffen.

BI umfasst zahlreiche Anwendungen und Methoden, um Daten aus internen und externen Quellen zu sammeln, sie für die Analyse vorzubereiten, Abfragen zu entwickeln und Berichte und Datenvisualisierungen zu erstellen. So lassen sich die Ergebnisse neben den Entscheidungsträgern im Unternehmen auch den operativen Mitarbeitern zugänglich und verständlich machen. In Zeiten komplexer und dynamischer Märkte gehen mit einem Informationsvorsprung meist auch Wettbewerbsvorteile einher.

Der eigentliche Wert der Daten liegt also in ihrer Auswertung. Der Prozess der Suche, Vorbereitung und Auswertung läuft unter dem Stichwort Data Mining. Der Begriff ist etwas irreführend, denn es geht um die Gewinnung von Wissen aus bereits vorhandenen Daten und nicht bloss um die Generierung oder Erschliessung der Daten selbst.

Es gibt mehrere Methoden, um die Daten in einen Mehrwert für das Unternehmen zu verwandeln: Business-Intelligence-Plattformen bieten Verfahren und Prozesse zur Sammlung, Analyse und Darstellung der Daten. Das Ziel besteht dabei häufig darin, Kosten zu senken und Risiken zu minimieren. Dabei gilt es, im Vorfeld detailliert zu definieren, was genau man untersuchen will und was das Ziel der Analyse ist. Business Intelligence richtet den Fokus also vorrangig auf einzelne Unternehmens-Kennzahlen und liefert viele punktuelle Einsichten.

“Wie schaffe ich es, dass mein Unternehmen weiß, was es schon lange wüsste, wenn es die vorhandenen Informationen entsprechend nutzen würde.„

Daniel Fallmann, Gründer und Geschäftsführer von Mindbreeze

Das noch nicht so weit verbreitete Process Mining verfolgt einen anderen, ganzheitlicheren Ansatz: Es analysiert nicht einzelne KPIs, sondern Prozesse, und stellt sie so dar, wie sie in der Realität ablaufen - in Echtzeit. Das ermöglicht es Unternehmen, ineffiziente Prozesse und Abweichungen von Soll-Werten schnell zu identifizieren.

Die österreichische Firma Mindbreeze ist auf Enterprise Search und Information Insight spezialisiert. Mindbreeze-Gründer Daniel Fallmann rät, folgende Frage zu stellen: «Wie schaffe ich es, dass mein Unternehmen weiss, was es schon lange wüsste, wenn es die vorhandenen Informationen entsprechend nutzen würde?» Anders gesagt: Viele Unternehmen wissen nicht, was sie wissen könnten. Die Bereitstellung von Informationen zum richtigen Zeitpunkt und im richtigen Kontext ist ausschlaggebend dafür, dass Geschäftsentscheidungen zeitgerecht getroffen werden, dass der Kunde dem Unternehmen treu bleibt, weil er sofort präzise Antworten erhält, oder dass Kosten reduziert werden, etwa weil Maschinenteile dank Predictive Maintenance ausgetauscht werden, bevor es zum teuren Produktionsstillstand kommt.

Trends in der BI

Ein nicht ganz neuer, aber sich ausweitender Trend in der Business Intelligence ist Selfservice BI. Dabei geht es darum, dass mehr Mitarbeiter Zugang zu den Daten haben und über Werkzeuge verfügen, um sie zu verarbeiten. Das Analysieren von Daten soll nicht mehr ausschliesslich eine Angelegenheit der IT-Abteilungen sein. Vielmehr sollen auch die Fachabteilungen Daten auswerten können, immerhin kennen sie sich am besten mit der jeweiligen Materie aus. Die Anwender in den Fachabteilungen können Daten aus den angeschlossenen Business-Applikationen wie CRM-Anwendungen, aus IoT-Systemen oder aus Datensilos in der Cloud beziehen. Selfservice BI soll es auch Nutzern, die wenig von Statistik wissen, ermöglichen, die gewonnenen Daten zu analysieren. Mit Data-Preparation-Tools lassen sich diese Daten automatisiert und ohne Programmierkenntnisse aufbereiten, um sie schliesslich an die BI-Systeme für eine Auswertung weiterzuleiten.

Dies alles erledigen Mitarbeiter von ihrem Arbeitsplatz aus und ohne Hilfe der IT- oder Entwicklungsabteilung. Das spart Zeit und entlastet die Technikexperten. Zudem ist der Schulungsaufwand vergleichsweise gering. Ein Beispiel: Das Sales-Team eines Eisproduzenten analysiert frei verfügbare interne Daten und externe Daten wie demografische Angaben, regionale Vorlieben oder Wetterdaten, um Absatzpotenziale zu identifizieren und das Angebot und damit den Umsatz zu optimieren.

„Auf technologischer Seite benötigt ein Unternehmen zudem ein Data-Catalog-Werkzeug», betont Jan Wetzke, Director Sales DACH bei Talend, einem Anbieter von Datenintegrationslösungen. Damit erkennen Mitarbeiter, welche Datenquellen innerhalb eines Unternehmens vorhanden sind, und können diese im Selfservice-Verfahren nutzen.

“ Auch auf BI-Ebene gilt die Weisheit: Garbage in, Garbage out.„

Jan Wetzke, Director Sales DACH bei Talend

Peter Walker, Vice President EMEA North beim Software-Haus Information Builders, beobachtet bei Selfservice BI einen interessanten Wandel: «In der Vergangenheit haben viele Unternehmen reine Selfservice-Tools gekauft, den Fachabteilungen zur Verfügung gestellt und die Nutzer dann damit alleingelassen. Heute wollen die Unternehmen dieses Chaos wieder in den Griff bekommen. Viele entscheiden sich daher für den Einsatz einer unternehmensweiten BI-Plattform. Diese kombiniert leistungsstarke BI-Architekturen mit agilen Selfservice-Analysen, die allen Entscheidern zur Verfügung stehen.» Mindbreeze-Geschäftsführer Fallmann wiederum konstatiert, dass Fachexperten aus Finanzabteilung, Vertrieb oder Marketing immer mehr Informationen in immer kürzerer Zeit analysieren müssen. Dabei verändert sich die Art und Weise, wie sie diese Informationen verarbeiten können, gerade sehr stark. «Besonders von den Entwicklungen im Bereich der Künstlichen Intelligenz profitieren die Anwender, denn es existieren mittlerweile Lösungen, die eine rasche themenspezifische Abfrage von Unternehmensdaten ermöglichen», so Fallmann. Auch Machine-Learning-, Natural-Language-Processing- und Blockchain-Techniken kommen seiner Beobachtung nach in begrenzten Anwendungsszenarien bereits zum Einsatz.

“Ich glaube, dass in ein paar Jahren jedes größere Unternehmen Process-Mining-Technologie einsetzen wird.„

Bastian Nominacher, Mitgründer und Co-CEO von Celonis

Ein zunehmend populäres Szenario ist Embedded Analytics. Dabei handelt es sich um Funktionen, die eng in bestehende Lösungen wie CRM-, ERP- oder Finanzsysteme integriert sind, um Entscheidungen im Zusammenhang mit sehr spezifischen Aufgaben zu unterstützen. Die Analysefunktionen wandern also in die Unternehmensanwendungen selbst. Auch die Auswertung ist dann direkt dort möglich. Anstatt statische Berichte für Kunden bereitzustellen, können Unternehmen interaktive Echtzeit-Analysen anbieten, auf die Kunden jederzeit, überall und auf jedem angeschlossenen Gerät zugreifen können - eine Art Analytics as a Service.

Analysen in natürlicher Sprache

Mit grossen Erwartungen verbunden sind auf dem Feld von Big Data und BI Entwicklungen unter dem Stichwort Natural Language Processing (NLP). Was Amazon, Apple, Microsoft und Google mit ihren Sprachassistenten im Verbraucherumfeld vorgemacht haben, setzt sich im Business-Bereich fort. Franz Kögl, Vorstand des Münchner Unternehmens IntraFind Software für Enterprise Search und Content Analytics, berichtet:«Neu ist der Aspekt der Conversational Systems, der virtuellen Assistenten. Das erfordert Systeme, die auf sehr unterschiedliche Datenquellen zugreifen können. Es werden immer weniger Ein-Wort-Suchen eingegeben, sondern der Benutzer stellt natürlichsprachige Fragen an die Suchmaschine und erwartet smarte Antworten.»

NLQA, Natural Language Question Answering, sei vor allem im Bereich der Chatbots brandaktuell. Systeme mit einem wirklich tiefem Textverständnis gebe es allerdings noch nicht, so Kögl. Auch Talend-Director Jan Wetzke erwartet, dass NLP-Technologien künftig immer wichtiger werden, wenn es darum geht, grosse Mengen an unstrukturierten Daten verarbeiten zu können. Darüber hinaus gelinge es damit besser, Kunden zu verstehen und ihre Wünsche und Beschwerden automatisiert zu klassifizieren.

Die Interaktion zwischen Mensch und Maschine hat sich bereits massgeblich verändert, ist Mindbreeze-Gründer Fallmann überzeugt. Dazu gehöre die Art, wie Anwender nach Informationen suchen. «Wir stellen heute Fragen und suchen seltener nach Begriffen oder einzelnen Wörtern. Das lässt sich auch an intelligenten Sprachassistenten wie Alexa oder Siri erkennen. Sie sind in der Lage, die natürliche Sprache zu verstehen und darauf akkurat zu antworten.» Dafür nutzen sie sowohl Natural Language Processing (NLP) als auch Natural Language Question Answering (NLQA).

“Die Datenmengen sind mit den heutigen Technologien nicht mehr sinnvoll auswertbar.„

Franz Kögl, Vorstand bei IntraFind Software

«NLP sorgt dafür, dass die menschliche Sprache korrekt in Maschinensprache übersetzt, verstanden und interpretiert wird, während NLQA den Dialog ermöglicht. Dadurch kann das Anliegen korrekt identifiziert und die Suchresultate können im jeweiligen Kontext angezeigt werden - und nicht einfach Treffer, in denen irgendwo der Begriff vorkommt.» Zum Beispiel erkenne das System bei einer Frage wie «Wann wurde Wolfgang Amadeus Mozart geboren?», dass «Wann» das Fragewort ist, dass jemand geboren wurde und dass es sich bei Wolfgang Amadeus Mozart um eine Person handelt, und liefert statt eines Dokuments prompt die konkrete Antwort «27. Januar 1756».

Data as a Product

Im Kommen ist für BI-Konzepte auch Visual Analytics. Manche Unternehmen integrieren diese Technik als zusätzlichen Service, um ihr eigenes Angebot aufzuwerten. Bislang sind vor allem Werbeagenturen, Beratungsfirmen und Anbieter von mobilen Apps auf diesen Zug aufgesprungen.

Ein Beispiel: Die Firma Map Case hat Apps für Skifahrer, Bergwanderer und Mountainbiker entwickelt, die damit ihre Leistungen tracken und mit denen anderer Sportler vergleichen können. Das Feedback der User analysiert Map Case mit Hilfe einer BI-Software, um es in Social Media, Hotelbewertungen, Umfragen und andere Touchpoints einzubinden.

Vorausschauende Wartung

Nicht fehlen darf bei den BI-Trends auch Predictive Analytics, die datengestützte Vorhersage bestimmter Ereignisse. Ein typisches Einsatzgebiet ist Predictive Maintenance, also die vorausschauende Wartung und Instandhaltung - ein Buzzword der digitalen Transformation. Die Deutsche Bahn etwa hat ihre Weichen in den vergangenen Jahren mit unzähligen Sensoren ausgestattet. Diese Sensoren messen den Strom, den der Motor benötigt, um eine Weiche zu stellen. Die Messwerte werden mit einer Soll-Kurve abgeglichen. Abweichungen lassen Rückschlüsse auf den Zustand der Weiche zu, und die Deutsche Bahn kann handeln, bevor die Weiche komplett ausfällt. Das spart Geld, vermeidet Zugausfälle und Verspätungen und erhöht somit gleichzeitig die Kundenzufriedenheit. Bis 2020 will die Bahn rund 30.000 Sensoren verbauen. Auch Windräder, Turbinen und Kraftfahrzeuge lassen sich mit Predictive Maintainance überwachen, indem Drehzahlen, Geräusche oder die Temperatur von Motoren erfasst und so Überhitzungen und Unwuchten frühzeitig erkannt werden. Aber es gibt auch kritische Stimmen, die Predictive Maintenance nur als Worthülse für Altbekanntes ansehen. Zudem lassen sich viele Ausfälle von Maschinen oder Bauteilen auf einen Faktor zurückführen, bei dem Predictive Maintenance wirkungslos ist, nämlich Bedienungsfehler.

Drohender Daten-GAU

Die eingangs beschriebene Datenexplosion gewinnt nicht zuletzt durch die Verbreitung des IoT an Rasanz. Schätzungen gehen von 50 Milliarden vernetzten IoT-Devices bis 2020 aus. Das wirft die Frage auf, wie sich die riesigen Datenmengen überhaupt noch sinnvoll speichern und analysieren lassen. IntraFind-Vorstand Franz Kögl sagt mit einem Augenzwinkern: «Ab und zu habe ich den Wunsch, vertrieblich bei einem Storage-Anbieter zu arbeiten.» Er ist der Ansicht, dass die Datenmengen mit den heutigen Technologien nicht mehr sinnvoll auszuwerten sind. Bei einem vernetzten Auto falle jede Stunde 1 Terabyte Messdaten an, mit denen nichts gemacht werde. «Die Daten sind da, aber sie können nicht ausgewertet werden.» Deshalb müsse man Analysesysteme einsetzen, um die Daten zu entschlacken und sich von Datenmüll zu befreien.

Mindbreeze-Geschäftsführer Daniel Fallmann ist anderer Ansicht: «Daten zu speichern, ist heute nicht mehr das grosse Problem, Speichermöglichkeiten sind ausreichend und zu günstigen Konditionen vorhanden.» Die Speicherdichte steige darüber hinaus nach wie vor rasch und die Geschwindigkeit der Speichermedien ebenfalls. «Beim Thema Daten- und Informationsanalyse wird es schon schwieriger, wenn man bedenkt, dass viele unterschiedliche Datenquellen in Unternehmen vorhanden sind und Daten sowohl strukturiert als auch unstrukturiert gespeichert werden.» Es gibt viele Konzepte der Datenspeicherung, etwa hierarchische Datenbanken, relationale Datenbanken, Cubes, In-Memory- und Spaltendatenbanken. Sie alle sind entstanden, um immer grössere und vielfältigere Datenmengen zu unterstützen.

Wer sich mit Big Data befasst, kommt schnell auf Hadoop zu sprechen, das freie Open-

Source-Framework auf Basis von Java und dem Map-Reduce-Algorithmus von Google. Die Aufgabe von Hadoop besteht darin, sehr grosse Datenmengen effizient in Clustern zu verarbeiten. Die Rechenleistung der einzelnen Knotenpunkte im Cluster wird dabei mitgenutzt. Hadoop lässt sich installieren oder über die Cloud betreiben. Ein grosser Pluspunkt liegt in der kostengünstigen Umsetzung. Dank Java läuft Hadoop zudem auf beinahe jeder Hardware.

Source-Framework auf Basis von Java und dem Map-Reduce-Algorithmus von Google. Die Aufgabe von Hadoop besteht darin, sehr grosse Datenmengen effizient in Clustern zu verarbeiten. Die Rechenleistung der einzelnen Knotenpunkte im Cluster wird dabei mitgenutzt. Hadoop lässt sich installieren oder über die Cloud betreiben. Ein grosser Pluspunkt liegt in der kostengünstigen Umsetzung. Dank Java läuft Hadoop zudem auf beinahe jeder Hardware.

Auch die an der UC Berkeley entwickelte Datenanalyse-Plattform Spark erfreut sich zunehmender Beliebtheit und wird inzwischen von vielen als ernsthafte Konkurrenz für Hadoop angesehen. Apache Spark legt im Gegensatz zu Hadoop den Fokus ganz auf die In-Memory-Datenverarbeitung. Die zu analysierenden Daten werden dabei direkt im Arbeitsspeicher der Cluster-Knoten gespeichert und verarbeitet. Dieses Verfahren bringt enorme Geschwindigkeitsvorteile gegenüber anderen Systemen, bei denen die Daten zunächst vom Festspeicher geladen werden müssen. Spark lagert die Daten nur dann auf die Festplatten aus, wenn die Datenmengen zu gross werden. Talend-Manager Jan Wetzke berichtet: «Viele Unternehmen setzen auf cloudbasierte Data Lakes. Dieser Ansatz ist kosteneffizient, skalierbar und flexibel in der Nutzung. Neue Architekturen wie Serverless und individuelle Abrechnungsmodelle helfen dabei, die beste Performance zu dem jeweils vorhandenen Budget zu erhalten.» Aber auch auf BI-Ebene gelte die Weisheit: Garbage in, Garbage out. Die Qualität der Daten entscheidet über die Qualität der Ergebnisse.

Daten lassen sich in drei Gruppen unterteilen: strukturiert, semistrukturiert und unstrukturiert. Unstrukturierte Daten enthalten Textdokumente und andere Arten von Dateien, die für einen Computer nicht leicht lesbare Formate aufweisen. Unstrukturierte Daten lassen sich nicht in Zeilen und Spalten darstellen, was für herkömmliche Data-Mining-Software eine Analyse erschwert. Der überwiegende Teil der von Unternehmen produzierten Daten - Schätzungen gehen von 85 Prozent aus - liegt aber in unstrukturierter Form vor. Bei der Suche nach einer geeigneten Business-Intelligence-Software sollte angesichts so vieler unstrukturierter Daten also die Qualität der Textanalyse eine zentrale Rolle spielen.

Mangelware Data Scientists

Was den Einsatz fortschrittlicher BI-Techniken in Unternehmen besonders erschwert, ist der Mangel an Experten. Das liegt vor allem daran, dass dieses Fachgebiet vergleichsweise jung ist. So sind Studiengänge mit einer Ausrichtung auf Big Data, wie sie etwa die Statistik-Fakultät der TU Dortmund mit dem Masterstudiengang Datenwissenschaft anbietet, in Deutschland noch dünn gesät. Häufiger bieten Universitäten einzelne Vorlesungen und Seminare an, die sich mit Big Data, Data Mining und Analytics beschäftigen. Bei Online-Plattformen wie Coursera, Udacity oder edX gibt es zudem Kurse, mit denen sich die Grundlagen der Data Science erlernen lassen. Ein Manko dieser Weiterbildungen ist allerdings, dass die Abschlüsse nicht zertifiziert sind - daher ist fraglich, ob sie von potenziellen Arbeitgebern anerkannt werden.

Für Franz Kögl ist die Überwindung dieses Fachkräftemangels überlebensnotwendig für Deutschland. «Wir sind ein ressourcenarmes Land. Unser Kapital ist Wissen, das müssen wir besser nutzbar machen, da müssen die Ausbildungsberufe hingehen.» Jan Wetzke sieht einen Ausweg darin, selbst in die Hand zu nehmen, was die Universitäten nicht hinbekommen. «Die Alternative besteht darin, eigene Mitarbeiter im Umgang mit Datenwerkzeugen auszubilden und Selfservice-Funktionen weiter zu etablieren. Aufgaben wie das Datenqualitätsmanagement sollten sich ohnehin über alle Funktionsbereiche eines Unternehmens erstrecken, sodass sich unternehmensweite Weiterbildungsmassnahmen auszahlen.»

Peter Walker von Information Builders sieht zwei Quellen, aus denen Unternehmen ihren Bedarf an Fachkräften decken können: einerseits extern, indem sie verfügbare Spezialisten oder Absolventen entsprechender Ausbildungsgänge rekrutieren, andererseits über die Weiterbildung geeigneter Kandidaten aus den Fachabteilungen. Die hätten sogar einen Vorteil: «Sie kennen das eigene Unternehmen bereits sehr gut, wissen um die Datenquellen und die Datenqualität und kennen den Bedarf aus ihrem täglichen Arbeitsumfeld.»

“Einer der zentralen Trends ist die Abkehr von einzelnen Tools hin zu durchgängigen BI-Plattformen.„

Peter Walker, Vice President EMEA North bei Information Builders

Walker beobachtet ausserdem, dass einige Unternehmen als Ergänzung zu ihren Data Scientists auf oberster Entscheiderebene die Rolle eines Chief Data Officers oder Chief Digital Officers geschaffen haben, und schliesst daraus, dass «Data as an Asset» im Unternehmen als essenziell und als wichtiger Innovations- und Geschäftsmodelltreiber erkannt worden ist.

Mindbreeze-Gründer Fallmann setzt noch früher an. Er hält Vorträge an Universitäten und Hochschulen und will die jungen Leute frühzeitig in den Unternehmensablauf einbeziehen. Gerade im Bereich der Ausbildung gebe es noch viel Luft nach oben.

Im Gespräch mit Henrik Jorgensen, Country Manager DACH bei Tableau

Henrik Jorgensen: Country Manager DACH bei Tableau

Quelle: Tableau

Computerworld: Welche relevanten Trends sehen Sie bei Big Data und in der Business Intelligence?

Henrik Jorgensen: Interessant finde ich das Thema ethischer Umgang mit Daten. Eine Gartner-Umfrage unter CDOs von 2017 offenbarte, dass die Zahl der CDOs, die ethische Fragen als Teil ihres Aufgabenbereichs begreifen, in einem Jahr um 10 Prozentpunkte gestiegen ist. Damit reagieren die Verantwortlichen auf die steigende Bedeutung der Daten. Ein Ethikkodex könnte künftig helfen, datenethische Grundsätze zu vermitteln.

Computerworld: Wird «Data as a Product» zum Trend, also Daten als Produkt zu verkaufen?

Jorgensen: Wie sich Daten monetarisieren lassen, das treibt Start-ups ebenso um wie etablierte Unternehmen. Mit der intelligenten Nutzung von Daten lassen sich ganz neue Business-Modelle, Dienstleistungen und andere geschäftsfördernde Massnahmen auf den Weg bringen.

Hier nur ein Beispiel: Der Konzern General Electric bietet mit seiner IoT-Plattform Predix eine standardisierte Möglichkeit, industrielle Anwendungen in der Cloud zu entwickeln. Nutzer können dabei mit Tableau in Predix Echtzeitdaten in umsetzbare Erkenntnisse umwandeln, indem sie Maschinen und Daten mit dem gesamten Unternehmen verbinden.

Computerworld: Wie schätzen Sie die Bedeutung von Datenanalyse in natürlicher Sprache ein?

Jorgensen: Wir denken natürlich über Möglichkeiten zur Integration mit führenden Sprachdiensten nach, konzentrieren uns momentan aber darauf, unseren Kunden ein bestmögliches Benutzererlebnis mit der Texteingabe zu bieten. Da unsere Kunden Tableau hauptsächlich auf Geräten mit Bildschirmen nutzen, ist es nur natürlich, dass Text die bevorzugte Eingabemethode ist.

Computerworld: Wie funktioniert das?

Jorgensen: Anwender können in natürlicher Sprache eine Frage wie «Was waren meine Vertriebszahlen in diesem Monat?» in Tableau eingeben und erhalten eine interaktive Datenvisualisierung als Antwort. Das ermöglicht es jedem, quasi mit seinen Daten in den Dialog zu treten. Die technische Basis hierfür bilden die natürliche Sprachverarbeitung (NLP) sowie anspruchsvolle Algorithmen, die in der Lage sind, die Absichten hinter einer Frage zu erkennen, und sich nicht nur auf Keywords stützen.

Computerworld: Kann man den Ergebnissen von Künstlicher Intelligenz und Machine Learning denn vertrauen? Fehlt es dafür nicht an Transparenz?

Jorgensen: Die Grundlage für jede vertrauenswürdige Künstliche Intelligenz sind saubere, vertrauenswürdige Daten. Nur wenn meine Datengrundlage entsprechend gepflegt ist und vorher festgelegten Unternehmensstandards entspricht, dann kann ich mich auch darauf verlassen, dass die Ergebnisse der KI dem Input entsprechen. Datenanalysen können aber umgekehrt auch helfen, die KI- und Machine-Learning-Ergebnisse transparenter und nachvollziehbar zu machen. Diese erklärbare Künstliche Intelligenz wird in Zukunft an Bedeutung gewinnen.

Autor(in)

Andreas

Dumont