Tatsächliche Aufmerksamkeit wird messbar

Nur 7 Sekunden am Stück und 4 Mal abgelenkt

Und derartige Technologien scheinen je länger je notwendiger zu werden. Bâces Untersuchungen zeigen nämlich, dass die visuelle Aufmerksamkeit, die wir dem Smartphone zukommen lassen, heute ausgesprochen zerstückelt ist. Gerade einmal rund 7 Sekunden dauert ein Augenkontakt mit dem Bildschirm im Durchschnitt, bevor der Blick abschweift.

Und das passiert nach jeder Entsperrung vier Mal für rund 2 Sekunden. Wie ablenkbar die Nutzer sind, hängt dabei von der einzelnen Persönlichkeit, aber auch der Umgebung des Nutzers sowie der Art der App ab, die gerade im Einsatz ist. Medizinische Anwendungen oder auch solche, die der Ausbildung dienen, fesseln beispielsweise wesentlich länger als Unterhaltungs-Apps.

Basis für unterschiedlichste Forschung

Den grossen Wert seiner Arbeit sieht Bâce aber nicht nur in diesen konkreten Untersuchungsresultaten, die mit dem System gewonnen werden konnten: «Unser System soll vor allem auch eine Basis für andere Wissenschaftler darstellen. Wir werden darum neben den gesamten Videodaten auch alle unsere Algorithmen veröffentlichen.»

Profitieren könnten zukünftig nicht nur App-Entwickler, sondern beispielsweise auch Soziologen oder Psychologen, die mit dem System ohne grossen technischen Aufwand Studien zum Einfluss von verschiedenen Faktoren auf die Aufmerksamkeit durchführen könnten. Aber auch die Medizin wäre ein möglicher Abnehmer der Technologie. Änderungen im Aufmerksamkeitsverhalten könnten beispielsweise beim Monitoring von Patienten eingesetzt werden und auf problematische Entwicklungen hinweisen.

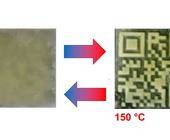

Bei der Entwicklung des Systems kam eine App zum Einsatz, die zusätzlich zum Aufnehmen von Frontkamera-Videos bei jeder Handy-Entsperrung und dem parallelen Sammeln verschiedener Sensor- und Metadaten auch noch Datenschutz- und Verifizierungsfunktionalitäten enthielt.

So konnten die Studienteilnehmenden über eine Review-Komponente selbst entscheiden, welche Videos sie zur Auswertung freigeben, und über ein Annotations-Game liessen sich Videosequenzen von anderen Teilnehmenden beurteilen. Mit Hilfe dieser dritten Komponente wurden in der Entwicklungsphase die Resultate der automatischen Blickkontakterkennung überprüft.

Autor(in)

Daniel

Meierhans, ETH-News