AI-Forschung

20.10.2020, 06:35 Uhr

Deep-Learning - Weniger Neuronen, mehr Intelligenz

Künstliche Intelligenz wird effizienter und zuverlässiger, wenn man sich enger an biologischen Vorbildern orientiert: Neue Ansätze der AI-Forschung bewähren sich im Experiment.

Künstliche Intelligenz (KI) ist längst in unserem Alltag angekommen - von der Suchmaschine bis zum selbstfahrenden Auto. Das hat mit der gewaltigen Rechenleistung zu tun, die in den letzten Jahren verfügbar geworden ist. Doch neue Ergebnisse aus der AI-Forschung zeigen nun, dass man mit einfacheren, kleineren neuronalen Netzen bestimmte Aufgaben noch besser, effizienter und zuverlässiger lösen kann als bisher.

Ein Forschungsteam der TU Wien, des IST Austria und des MIT (USA) hat eine neue Art künstlicher Intelligenz entwickelt, die sich an biologischen Vorbildern orientiert, etwa an einfachen Fadenwürmern. Das neue AI-Modell kann ein Fahrzeug steuern, mit einer verblüffend kleinen Zahl an künstlichen Neuronen. Das System hat entscheidende Vorteile gegenüber bisherigen Deep-Learning-Modellen: Es kommt mit unsauberen Eingabedaten viel besser zurecht, und aufgrund seiner Einfachheit kann man seine Funktionsweise im Detail erklären. Man muss es nicht einfach als komplexe "Black Box" betrachten, sondern es kann von Menschen verstanden werden. Dieses Deep-Learning-Modell wurde nun im Journal "Nature Machine Intelligence" publiziert.

Lernen von der Natur

Ähnlich wie lebendige Gehirne bestehen Neuronale Netze am Computer aus vielen einzelnen Zellen. Ist eine Zelle aktiv, sendet sie ein Signal an andere Zellen. Alle Signale, die die nächste Zelle erhält, entscheiden gemeinsam darüber, ob diese Zelle ebenfalls aktiv wird. Auf welche Weise eine Zelle die Aktivität der nächsten genau beeinflusst, ist zunächst offen - diese Parameter werden in einem automatischen Lernprozess so lange angepasst, bis das neuronale Netzwerk eine bestimmte Aufgabe lösen kann.

«Schon seit Jahren dachten wir darüber nach, was man von der Natur lernen kann, um künstliche neuronale Netze zu verbessern», sagt Professor Radu Grosu, Leiter der Forschungsgruppe «Cyber-Physical Systems» an der TU Wien. «Der Fadenwurm C. elegans zum Beispiel kommt mit einer verblüffend kleinen Zahl von Nervenzellen aus, und trotzdem zeigt er interessante Verhaltensmuster. Das liegt an der effizienten und harmonischen Art, wie sein Nervensystem Information verarbeitet.»

«Die Verarbeitung der Signale innerhalb der einzelnen Zellen gehorcht bei uns anderen mathematischen Regeln als bei bisherigen Deep Learning Modellen», sagt Ramin Hasani, Postdoc am Institut für Computer Engineering der TU Wien und am CSAIL, MIT. «Ausserdem wurde nicht jede Zelle mit jeder anderen verbunden - auch das macht das Netz einfacher.»

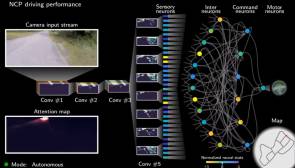

Die Aufgabe: Autonomes Spurhalten

Um die neuen Ideen zu testen, wählte das Team eine besonders wichtige Testaufgabe: Das Spurhalten beim Autonomen Fahren. Das neuronale Netz bekommt als Input ein Kamerabild der Strasse und soll daraus automatisch entscheiden, ob man nach rechts oder nach links lenken muss.

«Für Aufgaben wie Autonomes Fahren verwendet Deep Learning heute oft Modelle mit Millionen an Parametern», sagt Mathias Lechner, TU Wien Alumnus und PhD-Student am IST Austria. «Unser neuer Zugang macht es allerdings möglich, die Grösse des Netzwerks um zwei Grössenordnungen zu reduzieren. Unsere Systeme kommen mit 75'000 trainierbaren Parametern aus.»

Alexander Amini, PhD-Student am CSAIL, MIT, erklärt, dass das neue System aus zwei Teilen besteht: Der Kamera-Input wird zunächst von einem sogenannten konvolutionalen Netzwerk verarbeitet, das die visuellen Daten nur wahrnimmt, um in den Pixeln strukturelle Bildeigenschaften zu erkennen. Das Netzwerk entscheidet, welche Teile des Kamerabilds interessant und wichtig sind und gibt dann Signale an den eigentlich entscheidenden Teil des Netzwerks weiter - an das Kontrollsystem, das dann das Fahrzeug lenkt.

Beide Teilsysteme werden zunächst gemeinsam trainiert. Viele Stunden an Verkehrs-Videos von menschgesteuerten Autofahren in der Gegend von Boston wurden gesammelt und in das Netzwerk gefüttert, gemeinsam mit der Information, wie das Auto in den jeweiligen Situationen gesteuert werden soll - so lange, bis das System die richtige Verknüpfung von Bild und Lenkrichtung gelernt hat und selbstständig auch mit neuen Situationen umgehen kann.

Das Kontrollsystem des neuronalen Netzwerks (genannt «neural circuit policy», oder NCP), das die Daten aus dem visuellen Netz in einen Steuerungsbefehl übersetzt, besteht nur aus 19 Zellen. Mathias Lechner: «Diese NCPs sind um drei Grössenordnungen kleiner als es mit bisherigen State-of-the-art-Modellen möglich wäre.»

Kausalität und Interpretierbarkeit

Das neue Deep-Learning-Modell wurde in einem echten autonomen Fahrzeug getestet. «Unser Modell erlaubt uns, genau zu untersuchen, worauf das Netzwerk beim Fahren seine Aufmerksamkeit richtet. Es konzentriert sich auf ganz bestimmte Bereiche des Kamerabildes: Auf den Strassenrand und den Horizont. Dieses Verhalten ist höchst erwünscht, und es ist einzigartig bei Systemen, die auf künstlicher Intelligenz beruhen», sagt Ramin Hasani. «Ausserdem haben wir gesehen, dass sich die Rolle jeder einzelnen Zelle bei jeder einzelnen Entscheidung identifizieren lässt. Wir können die Funktion der Zellen verstehen und ihr Verhalten erklären. Dieses Mass an Interpretierbarkeit ist in grösseren Deep Learning Modellen unmöglich.»

Robustheit

«Um zu testen, wie robust unsere NCPs im Vergleich zu bisherigen Deep Learning Modellen sind, haben wir die Bilder künstlich verschlechtert und analysiert, wie gut das System mit Bildrauschen zurechtkommt», sagt Mathias Lechner. «Während das für andere Deep Learning Netzwerke zum unlösbaren Problem wurde, ist unser System sehr widerstandsfähig gegenüber Artefakten beim Input. Diese Eigenschaft ist eine direkte Folge des neuartigen Modells und seiner Architektur.»

«Interpretierbarkeit und Robustheit sind die zwei entscheidenden Vorteile unseres neuen Modells», sagt Ramin Hasani. «Aber es gibt noch mehr: Durch unsere neuen Methoden können wir die Dauer des Trainings reduzieren und schaffen die Möglichkeit, künstliche Intelligenz in relativ einfachen Systemen zu implementieren. Unsere NCPs machen imitierendes Lernen in einem weiten Anwendungsbereich möglich, von automatisierter Arbeit in Lagerhallen bis hin zur Bewegungssteuerung von Robotern. Die neuen Ergebnisse eröffnen wichtige neue Perspektiven für die AI-Community: Die Grundlagen der Datenverarbeitung in biologischen Nervensystemen sind eine grossartige Wissensressource um high-performance interpretierbare künstliche Intelligenz zu erzeugen - als Alternative zu den Black-Box-Machine-Learning Systemen, die wir bisher kannten.»

Weitere Informationen sind im kostenpflichtigen Originalpublikation einsehbar. Das Code Repository mit dem Python-Code zu NCP steht auf GitHub bereit.

Autor(in)

Bernhard

Lauer