14.06.2012, 10:40 Uhr

Was bringt Big Data Analytics?

Die Fans sprechen begeistert von der Big-Data-Revolution, den Kritikern reichen Datenbank-Queries völlig aus. Für welche Märkte, Branchen und Unternehmen lohnen sich Investitionen in Big Data Analytics?

Wer Big-Data-Strategien entwirft, muss sich an Rekorde gewöhnen – und daran, dass die Rekorde immer wieder gebrochen werden. Das liegt daran, dass wir selbst immer mehr Daten produzieren. In der Halbdekade von 2010 bis 2015 werde sich das im Internet übertragene Datenvolumen vervierfachen, schätzt der Netzwerkspezialist Cisco in seinem aktuellen Visual Networking Index. Ende 2015 beginnt demnach das sogenannte Zettabyte-Zeitalter. Zur Veranschaulichung: Stellt man sich ein heute gebräuchliches Gigabyte als Kaffeetasse vor, dann ergäbe ein Zettabyte an Kaffeetassenvolumen etwa die Grösse der chinesischen Mauer, die sich über eine Länge von gut 6600 Kilometern erstreckt. Die chinesische Mauer gilt als das grösste Bauwerk der Welt und soll sogar aus dem Weltall mit blossem Auge erkennbar sein. In Zahlen: 1 Zettabyte = 1000 Exabyte = 1000000 Petabyte = 1000000000 Terabyte = 10 hoch 21 Byte.

Wer braucht so viel?

Für die grossen Datensammler der digitalen Welt, etwa Google, Facebook, eBay oder internationale Grosskonzerne wie Walmart, sind das keine blossen Zahlenspielereien. Sie schliessen schon heute mehrere Tausend Rechner zu sogenannten Hadoop-Clustern zusammen, um ihre tera- und petabytegrossen Datenbestände parallelisiert in Sekunden zu analysieren. Aber brauchen Schweizer Mittelständler, das Rückgrat der Schweizer Wirtschaft, teure IT-Technologie zur Analyse ihrer geschäftlichen Daten? «Vielleicht», meint Markus Andres, beim ERP-Marktführer SAP verantwortlich für Global SME. Entscheidend seien die Anwendungsszenarien und die dadurch realisierbaren Wettbewerbsvorteile. Bei grossen Datenmengen falle die Kaufentscheidung leicht. Bei kleineren Volumina könnten treffsichere Prognosen oder performantere mobile (BI-)Anwendungen den Ausschlag geben, meint Andres.

Komplettsysteme für Big Data

SAP brachte vor etwa einem Jahr seine In-Memory-Appliance HANA auf den Markt, die komprimiert mehrere Terabyte in den Arbeitsspeicher lädt und dadurch sehr schnelle Analysen über den Gesamtdatenbestand ermöglicht. Zusammen mit Hardware-Partnern wie Fujitsu und HP bietet SAP seine HANA als fertig konfigurierte Appliances an, die Kunden sehr schnell in Betrieb nehmen können. Die kleinste Konfektionsgrösse von Fujitsu Schweiz mit einem

Arbeitsspeicher von 128 Gigabyte (und zwei Intel-X760-CPUs) wäre auch für Schweizer Mittelständler eine interessante Option. «Wir können den durch HANA generierten Mehrwert anhand von Kundenbeispielen nachweisen», betont Stefan Sigg, HANA-Entwicklungsleiter bei SAP. Der japanische Elektronik-Discounter Yodobashi etwa hat mit HANA die Performance seiner Budgetplanung extrem gesteigert: Aus drei Wartetagen wurden drei Sekunden. Ein zweites Beispiel: Nomura Research in Tokyo will mit SAP HANA Störmeldungen aus dem Strassenverkehr auswerten und an die

Taxileitzentrale weitergeben. Mit diesen Informationen können Taxifahrer Staus ausweichen, unnötige Standzeiten vermeiden und dementsprechend mehr Umsatz generieren. Als weitere HANA-Referenzkunden nennt SAP Honeywell Aerospace, Red Bull, die deutsche Krankenkasse AOK und das Berliner Krankenhaus Charité. Fest steht: Mit Big Data Analytics lassen sich in vielen Branchen wettbewerbsrelevante Vorteile erzielen. Nur punkto Technologie scheinen die Meinungen auseinander zu gehen. SAPs In-Memory-HANA wird, insbesondere von der Konkurrenz, sehr kontrovers diskutiert. Es ergebe keinen Sinn, Daten zu 100 Prozent in den Arbeitsspeicher zu packen, wenn nur 20 Prozent tatsächlich benötigt werden, kritisiert Stephen Brobst, CTO von Teradata, die In-Memory-

Datenbankstrategie von SAP. Das sei ein sehr teurer Brute-Force-Ansatz, den man mit cleverer Software vermeiden könne. Für Daten, auf die seltener zugegriffen werde, streben Unternehmen den niedrigsten Speicherpreis pro Terabyte an. In-Memory sei da schlicht zu teuer, betont Brobst. Lesen Sie auf der nächsten Seite: Streit um den Königsweg

Arbeitsspeicher von 128 Gigabyte (und zwei Intel-X760-CPUs) wäre auch für Schweizer Mittelständler eine interessante Option. «Wir können den durch HANA generierten Mehrwert anhand von Kundenbeispielen nachweisen», betont Stefan Sigg, HANA-Entwicklungsleiter bei SAP. Der japanische Elektronik-Discounter Yodobashi etwa hat mit HANA die Performance seiner Budgetplanung extrem gesteigert: Aus drei Wartetagen wurden drei Sekunden. Ein zweites Beispiel: Nomura Research in Tokyo will mit SAP HANA Störmeldungen aus dem Strassenverkehr auswerten und an die

Taxileitzentrale weitergeben. Mit diesen Informationen können Taxifahrer Staus ausweichen, unnötige Standzeiten vermeiden und dementsprechend mehr Umsatz generieren. Als weitere HANA-Referenzkunden nennt SAP Honeywell Aerospace, Red Bull, die deutsche Krankenkasse AOK und das Berliner Krankenhaus Charité. Fest steht: Mit Big Data Analytics lassen sich in vielen Branchen wettbewerbsrelevante Vorteile erzielen. Nur punkto Technologie scheinen die Meinungen auseinander zu gehen. SAPs In-Memory-HANA wird, insbesondere von der Konkurrenz, sehr kontrovers diskutiert. Es ergebe keinen Sinn, Daten zu 100 Prozent in den Arbeitsspeicher zu packen, wenn nur 20 Prozent tatsächlich benötigt werden, kritisiert Stephen Brobst, CTO von Teradata, die In-Memory-

Datenbankstrategie von SAP. Das sei ein sehr teurer Brute-Force-Ansatz, den man mit cleverer Software vermeiden könne. Für Daten, auf die seltener zugegriffen werde, streben Unternehmen den niedrigsten Speicherpreis pro Terabyte an. In-Memory sei da schlicht zu teuer, betont Brobst. Lesen Sie auf der nächsten Seite: Streit um den Königsweg

Streit um den Königsweg

Das Argument überzeugt nur teilweise: Nach klassischer Methodik organisieren Unternehmen ihre grossen, stark nachgefragten Datenbestände in mehrdimensionalen Data Warehouses. Etwa 80 bis 90 Prozent der in einem Unternehmen anfallenden Anfragen werden von Data Warehouses (Infocubes) sehr performant bedient, niemand braucht dafür In-Memory. Das Problem sind jedoch die restlichen 10 bis 20 Prozent. Dafür müssen Daten neu geladen und die Infocubes zeitaufwendig reorganisiert werden (sogenannte ETL-Operationen: Extract, Load, Transform), was je nach Volumen mehrere Stunden bis mehrere Tage dauert. Für diesen Business Case sind In-Memory-Datenbanken wie HANA klar im Vorteil. Schweizer Firmen sollten also mit spitzem Bleistift nachrechnen, wie viel ihnen der allzeitige, extrem schnelle Zugriff auf 100 Prozent ihrer Daten tatsächlich wert ist. Dabei muss es nicht unbedingt SAPs HANA sein. Um die Nachteile der starren Infocubes zu vermeiden, ziehen Data-Warehouse-Anbieter wie Teradata ein zusätzliches semantisches Layer ein, das Cubes zwar virtuell nachbildet, ohne sie jedoch physisch zu implementieren. Laut Teradata-CTO Stephen Brobst entfallen dadurch die langen ETL-Reorganisationszeiten.

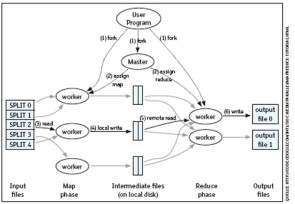

Eine weitere Alternative: SAP-Konkurrent Oracle brachte vor zwei Monaten seine neue, fertig konfigurierte Big-Data-Appliance auf den Markt. Big Data wie Kreditkartentransaktionen, Social-Media- oder Sensor-Daten (Kassendaten, RFIDs) fallen typischerweise in sehr kurzen Zeiträumen und sehr hohen Volumina an. Diese grösstenteils unstrukturierten Daten müssen zunächst einmal erfasst und in eine analysierbare Struktur gebracht werden. Herkömmliche relationale Datenbanken wie Oracles 11g, IBMs DB2 oder Microsoft SQL Server sind dafür nicht geeignet. Auch Data Warehouses setzen bereits eine feste Datenstruktur voraus. In Oracles neuer Big-Data-Appliance arbeiten daher ein auf unstrukturierte Daten spezialisierter NoSQL-Datenspeicher und die Open-Source-Technologien Hadoop und MapReduce (vgl. Grafik). «Herkömmliche, auf SQL basierende transaktionale Abfragesprachen sind für (unstrukturierte) Sensordaten nicht geeignet; neue Architekturmodelle wie Hadoop/MapReduce werden in Zukunft immer wichtiger werden», betont Teradata-CTO Brobst. Hadoop zerlegt dabei die riesigen Datenberge in kleinere Pakete, die dann auf Hunderte oder mehrere Tausend Rechnerknoten verteilt und parallel, also sehr schnell, bearbeitet werden können. MapReduce extrahiert aus den Sensordaten, typischerweise Schlüsseldatenpaare (key value pairs), die für die nachfolgende Analyse entscheidenden Informationen. Lesen Sie auf der nächsten Seite: Qualität erhöhen, Kosten senken

Qualität erhöhen, Kosten senken

Andrew Sutherland, Senior Vice President Technology bei Oracle, nennt als Praxisbeispiel für Big-Data-Analysen das Gesundheitswesen, und dort insbesondere die Überwachung von Risikopatienten, die etwa an Diabetes, Fettleibigkeit oder Bluthochdruck leiden. Ein kleines Messgerät übermittelt Sensordaten in Echtzeit an einen zentralen Datenspeicher, wo die roten Lampen leuchten, falls kritische Grenzwerte überschritten werden. Kostspielige Operationen und stationäre Krankenhausaufenthalte liessen sich damit reduzieren. «Wir sind fest davon überzeugt, dass in Big Data immense Möglichkeiten liegen, die zurzeit nur sehr unzureichend ausgeschöpft werden», betont Teradata-CTO Brobst, der den amerikanischen Präsidenten Barack Obama punkto Technologie-Investments berät. Auch für Brobst steht, neben der Energieversorgung, der Landessicherheit und Erziehung/Ausbildung, das Gesundheitswesen im Fokus. «Wir müssen die riesigen Datensammlungen nutzen, um eine bessere Gesundheitsvorsorge zu niedrigeren Kosten hinzubekommen», sagt er. Big Data könne die Medizin personalisieren, etwa durch DNA-Analysen, persönliche Risikoprofile und proaktive Vorsorge. Für die Schweizer Pharmaindustrie, so Brobst, sei das eine interessante Perspektive (mehr dazu im Exklusiv-Interview mit Stephen Brobst).