Künstliche Intelligenz

09.05.2019, 06:00 Uhr

Frameworks erleichtern den KI-Einstieg

In der Cloud und On-Premise gibt es immer bessere KI-Werkzeuge. Firmen sollten mit der Einführung jedoch nicht zu lange warten, um wettbewerbsfähig zu bleiben.

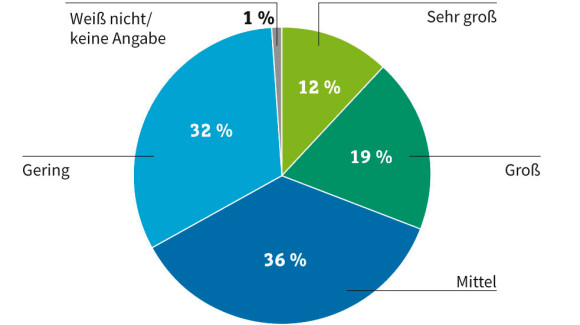

An die 30 Prozent der Mitarbeiter in deutschen Unternehmen wünschen sich, ein KI-System träte an die Stelle ihres Chefs. Weitere 17 Prozent würden lieber mit einer KI-Instanz zusammenarbeiten als mit bestimmten Kollegen. Das ergab eine Studie des Digitalverbands Bitkom. Auch wenn solche Hoffnungen derzeit noch vergeblich sein dürften, so ist doch klar: Künstliche Intelligenz hat auch und gerade in Unternehmen Einzug gehalten. Laut des Reports «Machine Learning/Deep Learning 2019» von IDG setzen rund 60 Prozent der deutschen Firmen bereits mindestens ein KI- oder Machine-Learning-Verfahren ein. Das heisst aber auch: 40 Prozent sind noch nicht auf den KI-Zug aufgesprungen. Und auch bei den anderen 60 Prozent ist noch die Frage, wie all die schönen KI-Versprechungen in Praxis umgesetzt werden.

Der Artikel stellt deshalb zunächst verschiedene Möglichkeiten vor, wie man KI-Technologie ins Unternehmen holen kann, und beleuchtet dann die wichtigsten Hürden bei der praktischen Umsetzung von KI-Projekten. Ergänzt wird er mit einer Marktübersicht für KI-Frameworks.

Cloud als Einstiegshilfe

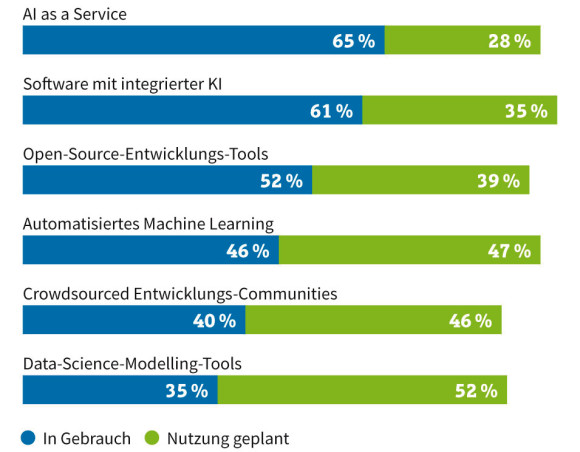

Wie kommt Künstliche Intelligenz denn nun in ein Unternehmen? Ein Grossteil der Firmen in Deutschland entwickelt jedenfalls keine eigenen KI- und Machine-Learning-Lösungen. Das belegt die Deloitte-Studie «AI in the Enterprise 2018». Unternehmen beziehen KI- und Machine-Learning-Software lieber von Cloud-Providern wie AWS, Google, IBM und Microsoft. Dieser Weg ist beileibe nicht nur etwas für grosse Konzerne, sondern bietet sich besonders auch für mittelständische Unternehmen an. Christian Mehrtens, Leiter des Geschäftsbereichs Mittelstand und Partner bei SAP Deutschland, betont: «Gerade für kleinere Unternehmen, denen keine grossen personellen oder finanziellen Ressourcen zur Verfügung stehen, sind intelligente ERP-Systeme und Cloud-Services eine Möglichkeit, um auf KI-Lösungen zurückzugreifen.»

“Gerade für kleinere Unternehmen ohne große personelle und finanzielle Ressourcen sind intelligente ERP-Systeme und Cloud-Services eine Möglichkeit, auf KI-Systeme zurückzugreifen.„

Christian Mehrtens

Leiter des Geschäftsbereichs Mittelstand und

Partner bei SAP Deutschland

Partner bei SAP Deutschland

Fast ebenso beliebt bei deutschen Firmen ist der Ansatz, KI-Funktionen als Bestandteil von Unternehmens-Software zu ordern. Die Marktführer auf diesem Sektor haben bereits KI-Technologie in ihre Produkte integriert, allen voran SAP, Oracle und Salesforce. Aber auch Business-Intelligence-Anbieter wie Qlik, SAS und Tableau Software stellen den Anwendern ihrer Lösungen bereits KI-gestützte Reports und Analysen («Insights») zur Verfügung.

Eine weitere Option, um eine KI-Lösung im Unternehmen zu implemetieren, bringt Güner Aksoy, Regional Sales Director Central Europe bei Pure Storage, ins Spiel: «Unternehmen sollten heute in der Lage sein, Infrastrukturentscheidungen auf der Grundlage dessen zu treffen, was für ihre Anwendungen am besten geeignet ist. Eine datenzentrierte, einheitliche hybride Cloud-Architektur ist ein praktikables, zeitgemässes und zukunftsorientiertes Modell. Es gibt modernen Unternehmen die nötige Agilität und schafft die Grundlage für die Unterstützung neuer Anwendungen wie KI, Machine Learning und Analytics.»

Frameworks

Unternehmen, die erste Gehversuche mit Künstlicher Intelligenz, maschinellem Lernen sowie neuronalen Netzen und Deep Learning starten wollen, steht eine breite Palette von Software-Paketen zur Verfügung - über die Cloud und On-Premise. Neben den proprietären Angeboten von AWS, Google, IBM und Microsoft gibt es viele auch kostenlos als Open Source. Wer sich auf maschinelles Lernen konzentrieren möchte, kann auf etablierte Frameworks wie scikit-learn oder SystemML zurückgreifen, das ursprünglich von IBM stammt, mittlerweile aber unter der Apache-Lizenz freigegeben wurde. Alternativen sind Apache Mahout und Microsofts Machine-Learning-Toolkit DMTK.

Komplexere KI-Anwendungen lassen sich mit Hilfe von Deep Learning (DL) und neuronalen Netzen erstellen. Die Mehrzahl der entsprechenden Frameworks basiert auf der Programmiersprache Python und ist ebenfalls als Open-Source-Software erhältlich. Allerdings plädieren Entwicklungsfirmen wie Skymind für Lösungen auf Basis von Java wie Deeplearning4j. Ein Grund dafür ist die höhere Performance, ein weiterer die weite Verbreitung von Java und Java Virtual Machine (JVM) in Unternehmen.

Unter den Deep-Learning-Frameworks auf Grundlage von Python bieten sich Klassiker wie TensorFlow und das einsteigerfreundliche Keras an. Zu den neueren Paketen zählt Caffe2, ein schnelles und leichtgewichtiges Framework, das auch für grosse Produktivumgebungen tauglich ist.

Ebenfalls für grosse Datenbestände ausgelegt ist Microsofts Open-Source-Toolkit CNTK. Zu dessen Vorzügen gehören der hohe Optimierungsgrad der Komponenten, der geringe Ressourcenbedarf und die Performance. Abstriche müssen Nutzer beim Support machen: Er ist wegen der kleineren Community nicht so ausgeprägt wie bei einigen anderen Frameworks.

Komplettsysteme

Unternehmen sind für KI-Anwendungen aber nicht allein auf Public-Cloud-Services oder Frameworks angewiesen. Eine, allerdings nicht ganz billige Alternative sind Komplettsysteme, wie sie zum Beispiel Pure Storage und Dell EMC anbieten. Ein Vorteil solcher KI-Pakete ist, dass Unternehmen alles aus einer Hand erhalten: Server, Grafikprozessoren, Storage sowie KI-Frameworks und Bibliotheken für Machine Learning oder dessen Schwestertechnologie Deep Learning.

Pure Storage hat gemeinsam mit Cisco die hyperkonvergente Appliance FlashStack for AI entwickelt. Die Server und Netzwerk-Switches steuert Cisco bei. Die für KI-Anwendungen optimierten Grafikprozessoren kommen von Nvidia, die Flash-Speicher-Komponenten von Pure Storage. Ausserdem hat Pure Storage zusammen mit Nvidia eine «AI-Ready Infrastructure» (AIRI) entwickelt. Auch sie basiert auf FlashBlade-Speichersystemen von Pure Storage sowie DGX-1-Systemen von Nvidia. Mit AIRI Mini steht zudem eine Einstiegslösung für kleinere Unternehmen zur Verfügung. Von Nvidia selbst gibt es zudem eine Data Science Workstation. Sie soll sich besonders für Data Scientists eignen, die eher traditionelle Datenanalysen mit Machine Learning betreiben wollen.

Einen vergleichbaren Ansatz bietet Dell EMC. Mit Hilfe von HPC-Servern (High-Performance Computing) wie dem PowerEdge C4140 und integrierten Tesla-Grafikkarten von Nvidia können Unternehmen beispielsweise die Qualitätssicherung in der Fertigung um KI- und ML-Funktionen erweitern.

KI-Anbieter finden

Doch steckt im Lösungspaket wirklich Künstliche Intelligenz drin oder handelt es sich um eine Mogelpackung? Das ist für Unternehmen oft schwer ersichtlich. Wer eine KI-Lösung sucht, sollte daher die Hersteller und ihre Produkte anhand mehrerer Kriterien prüfen.

Für Gérard Bauer, Vice President EMEA von Vectra, einem Anbieter von IT-Sicherheitsplattformen auf Basis von KI und Machine Learning, ist eine Frage entscheidend: Wie tief und breit ist die Entwicklungskompetenz eines Anbieters? Ein Indikator dafür sei die Zahl der Mitarbeiter, die einen «Background» in KI, Machine Learning (ML) und Data Science haben. Wenn beim Anbieter nur ein einziger Entwickler vorhanden ist, der zudem eine geringe ML-Erfahrung hat, ist Bauer zufolge höchstwahrscheinlich nur eine Open-Source-Bibliothek im Einsatz. Und das heisst, es wird mit KI nur «herumgespielt».

Laut Bauer sollten Unternehmen ausserdem versuchen, herauszufinden, ob bei einem infrage kommenden KI-Anbieter für den Bereich, in dem man nach Lösungen sucht, passende Fachkräfte vorhanden sind. «In vielen Fällen der angewandten KI geht es nicht nur darum, grosse Datenmengen zu erfassen und Berechnungen auszuführen», so Bauer. «In der Cybersicherheit brauchen wir beispielsweise erfahrene Sicherheitsforscher, die technische Verhaltensweisen von Angreifern hypothetisieren und validieren können. Ein Datenwissenschaftler allein hätte hier nicht den nötigen Einblick.» Nur in Zusammenarbeit mit dem Sicherheitsforscher könne der Datenwissenschaftler einen effektiven Algorithmus zur Erkennung von Cyberangriffen entwickeln.

Pluspunkte sollte man auch KI-Anbietern geben, die sich nachweislich langfristig für Innovationen und praxisrelevante Ergebnisse engagieren. Auszeichnungen und Branchenanerkennungen deuteten diesbezüglich auf Glaubwürdigkeit und Relevanz in der Branche hin. Ein Indikator dafür ist, ob ein Unternehmen von etablierten Branchenanalysten genannt wird, ein weiterer, ob die Firma Patente angemeldet hat oder - noch besser - eigenentwickelte KI-Technologien patentieren liess.

“KI ist ein reales Werkzeug und kein fernes Ziel. Es geht darum, wie KI eingesetzt wird.„

Ein weiteres Kriterium bei der Anbieter-Suche sind die Daten, die dieser für das Erstellen, Trainieren, Testen und Betreiben seiner Algorithmen verwendet. Denn bei Data Science geht es Bauer zufolge nicht einfach nur darum, komplizierte Algorithmen zu entwickeln. «Neben der Auswahl algorithmischer Ansätze muss der Datenwissenschaftler auch das Kuratieren der Daten, die Auswahl und Extraktion von Merkmalen sowie das Training managen», so der Vectra-Manager. Unternehmen sollten ihren zukünftigen KI-Anbieter deshalb auch nach seiner Datenbasis fragen: «Suchen Sie nach Informationen über die Herkunft, Qualität, Verwaltung und Sicherheit der Daten sowie darüber, wie und wo sie verwendet werden.»

Besonders bei jüngeren Unternehmen empfehle sich ausserdem ein kritischer Blick auf das Führungsteam und die Mitarbeiter. Wichtig sei, dass sie über Erfahrung in der Branche verfügen. Weitere Kriterien sind die Erfolgsbilanz und der Ruf des Unternehmens sowie Informationen darüber, in welche Bereiche es seine Investitionen lenkt.

«Denken Sie ausserdem daran, dass KI ein reales Werkzeug ist und kein fernes Ziel. Es geht darum, wie KI eingesetzt wird», betont Gérard Bauer. Daher sollte ein KI-Tool auf autonome Weise für Effizienzgewinne oder neue Erkenntnisse sorgen. Wenig hilfreich sei eine herkömmliche Lösung mit «angeflanschter» Automatisierung, die durch Prozesse hinter den Kulissen unterstützt wird.

“Was fehlt ist ein praktisches Verständnis, wann welche Probleme mit KI und Machine Learning sinnvoll adressiert werden können.„

Des Weiteren empfiehlt Bauer, auf unabhängige, verifizierte Tests der Lösungen eines Anbieters und die Resonanz von User-Communities zu achten. Solche Informationsquellen seien neutraler als Referenzen, die der Hersteller bereitstellt.

Besonders wichtig ist schliesslich das Testen eines KI-Tools im eigenen Unternehmen. Nur so lasse sich dessen Effizienz ermitteln. «Suchen Sie nach Evaluierungs- oder Proof-of-Concept-Programmen, die es Ihnen ermöglichen, in Ihrer Umgebung praktische Erfahrungen zu sammeln und die richtige Lösung zu finden», so der Experte.

Mitarbeiter mitnehmen

Damit KI-Projekte den gewünschten Nutzen bringen, braucht es mehr als Frameworks, Rechnerplattformen und Cloud-Services: «KI-Initiativen benötigen einen organisatorischen Rahmen», betont Kay Müller-Jones, Leiter Consulting und Services Integration beim Beratungs- und Technologiehaus Tata Consultancy Services (TCS). «Die Mitarbeiter selbst stehen dabei im Fokus. Die Anforderungen an deren Tätigkeiten ändern sich.» Damit steige die Bedeutung einer stetigen Weiterbildung. «So selbstverständlich wie Mitarbeiter heute Microsoft Office nutzen, werden sie künftig KI-Lösungen einsetzen. Dieser Wandel muss durch geeignete Change-Management-Massnahmen begleitet werden», fordert Müller-Jones.

Doch auch wenn die Mitarbeiter oft eine gewisse Grundskepsis mitbringen - vor allem, wenn sie ständig lesen müssen, wie viele Jobs die KI kosten wird -, freunden sie sich nach den Erfahrungen des Customer-Experience-Spezialisten Genesys schnell mit KI an, wenn sie in der Praxis damit in Berührung kommen: «Die Mitarbeiter eines unserer Kunden hegten vor Beginn der Einführung Bedenken, dass KI ihre Arbeit negativ beeinflussen könnte», sagt Heinrich Welter, Vice President Sales and General Manager DACH bei Genesys. „Nach sechs Monaten zeigten interne Umfragen, dass die Mitarbeiter zufrieden waren. Als besonders positiv empfanden sie, dass ihnen KI mehr Zeit für anspruchsvolle Aufgaben liess.»

“KI ist kein blosser Trend, sondern entscheidend für die Zukunftsfähigkeit von Unternehmen.„

Praxistransfer mangelhaft

Und wenn dann ein KI-Anbieter gefunden ist und die Beschäftigten eingebunden sind, gibt es bei KI-Projekten noch eine letzte grosse Hürde: der Transfer von Technik und Theorie in die Praxis. Matthias Keller, Head of Data Science beim Digitalisierungsspezialisten Echobot, erklärt das Probelm: «Die Lern-Algorithmen und deren Optimierung sind eher das Handwerk. Die Kunst und eigentliche Herausforderung ist, ein spezifisches Praxisproblem und vorhandene Daten in lösbare Machine-Learning-Probleme zu überführen.

Echbot-CEO Bastian Karweg ergänzt: «Die Nachfrage nach KI-Lösungen ist sehr hoch. Das Interesse ist dabei aber vor allem durch die grossen Effizienzgewinne und Einsparungspotenziale motiviert. Was fehlt ist ein praktisches Verständnis, wann welche Probleme mit KI und ML sinnvoll adressiert werden können.»

Ausserdem haben Karweg zufolge viele Unternehmen ihre Hausaufgaben nur mangelhaft erledigt: «Ihre Datenwelt ist veraltet, unvollständig oder fehlerhaft. Darauf lässt sich natürlich nicht aufbauen.»

Fazit & Ausblick

In einem sind sich so gut wie alle Fachleute einig: Die deutschen Unternehmen sollten nicht warten, bis Konkurrenten aus dem Ausland an ihnen vorbeigezogen sind, die bereits heute KI und maschinelles Lernen auf breiter Basis einsetzen. «Bei neuen Technologien ist es nicht ungewöhnlich, dass viele Firmen sie erst einführen, wenn der Wettbewerb damit bereits erfolgreich am Markt ist», erklärt Kay Müller-Jones von TCS. Aber diese Strategie sei im Fall von KI riskant. «KI ist kein blosser Trend, sondern wird als entscheidend für die Zukunftsfähigkeit von Unternehmen angesehen. Und mit jedem Tag des Abwartens wachsen der Rückstand auf die führenden Firmen und der Druck des Marktes.»

Schützenhilfe geben den Unternehmen die Bundesregierung mit ihrer «Nationalen KI-Strategie» und Organisationen wie der KI Bundesverband. Die Regierung will bis 2025 rund drei Milliarden Euro in die Förderung von Forschungsvorhaben und Projekten stecken. Und der Verband hat jüngst das Gütesiegel «AI Made in Germany» vorgestellt hat.

“Nur 18 Prozent der Deutschen empfinden Chat-Bots beim Kundenservice als irritierend. Viel mehr Verbraucher ärgern sich über lange Wartezeiten, falsche Informationen und darüber, von einem Berater zum nächsten weitergereicht zu werden.„

Um im Konzert der «Grossen» mitzuspielen, braucht es allerdings eine umfassende Kooperation von Unternehmen, Forschungseinrichtungen und Staat. Die oft gegen neue Techniken skeptischen deutschen Verbraucher scheinen jedenfalls das geringere Problem zu sein. Sie gewöhnen sich offenbar schnell an KI, wenn sie ihnen im Alltag begegnet. Wer die Kundendienst-Hotline eines Produktherstellers, eines Finanzdienstleisters oder einer Versicherung anruft, spricht ja oft schon mit einer KI-Instanz, besser gesagt einem Software-Roboter (Bot): «Nur 18 Prozent der Befragten empfinden Chat-Bots als irritierend beim Kundenservice», berichtet Genesys-Mann Heinrich Welter. «Viel mehr Verbraucher ärgern sich über lange Wartezeiten, falsche Informationen und darüber, von einem Berater zum nächsten weitergereicht zu werden.»

Übersicht: Frameworks für Künstliche Intelligenz (Teil 1)

Frameworks für Künstliche Intelligenz

| Frameworks für Künstliche Intelligenz (Teil 1) | |||

| Anbieter | Lösung(en) | Schwerpunkte | Besonderheiten |

| Amazon Web Services | Amazon SageMaker | Machine Learning (ML); Managed Service zum Erstellen, Trainieren und Bereitstellen von ML-Modellen | Gesamter Workflow von ML-Projekten abgedeckt; vorgefertigte Workflows und Schnittstellen für gängige Kennzeichnungsaufgaben; laut AWS um 70 Prozent geringerer Aufwand beim Markieren von Daten; Unterstützung von Frameworks wie TensorFlow, PyTorch, Apache MXNet |

| Amazon Web Services | KI-, DL- und ML-Services wie Comprehend, Forecast, Polly, Translate oder Rekognition | Vortrainierte KI-Services für Bild-/Videoanalyse, Personalisieren von Kundenerfahrungen, Dokumentenanalyse, Natural Language Processing etc. | Unterstützung von Frameworks wie TensorFlow, PyTorch, Apache MXNet |

| Apache | Mahout | Verteiltes Framework für das Erstellen von ML-Applikationen; Open Source | Basis: Hadoop MapReduce; hohe Skalierbarkeit; für effizientes Data-Mining bei großen Datenbeständen ausgelegt; Kritikpunkt: unzureichende Visualisierungsfunktionen |

| Apache | Mlib (Spark) | ML-Bibliothek für Python, Java, Scala und R; Open Source | Unterstützung von Spark und NumPy; Implementierung auf Hadoop, Apache Mesos, Kubernetes, Cloud, firmeneigenen Data-Centern; Einsatzfelder u. a. Regressionsanalysen, Clustering, Entscheidungsbäume, Empfehlungsalgorithmen |

| Apache | MXNET | DL-Bibliothek und Framework mit breiter Unterstützung von Programmiersprachen; Open Source | Unterstützt u. a. Python, C++, Julia, R und JavaScript; hohe Skalierbarkeit; Einsatz vor allem bei Sprach- und Bilderkennung, Natural Language Processing und Prognosen im Rahmen großer Projekte; gute Unterstützung von Grafikprozessoren; nicht so populär wie andere Frameworks |

| Apache | Singa | Deep Learning (DL); verteilte Plattform für Deep Learning; Open Source | Unterstützung von neuronalen Netzwerken wie Convolutional Neural Networks (CNN), Restricted Boltzmann Machines (RBM) und Recurrent Neural Networks (RNN); Fokus auf Anwendungen im Gesundheitsbereich und mit geringem Ressourcenbedarf; breite Hardware-Unterstützung; für synchrone, asynchrone und hybride Trainings-Frameworks |

| Apache | SystemML | ML-Framework; ursprünglich von IBM; seit Ende 2018 Open Source | Anwendungen u. a. deskriptive Statistiken, Klassifizierungen, Regressionsanalysen, Matrix-Faktorisierung; für die Analyse großer Datenbestände; läuft in Apache-MapReduce- oder Apache-Spark-Umgebungen |

| Berkeley Vision and Learning Center | Caffe | DL-Framework auf Basis von C++ mit Python-Interface und Schwerpunkt auf Bilderkennung | Nachfolger ist Caffe2; Anwendungen - neben Bildanalyse - Spracherkennung und Robotics-Applikationen; weniger geeignet für Text- und Sprachanalyse und Zeitreihenanalyse; Unterstützung von Convolutional Neural Networks; Schnittstellen zu C, C++, Python, Matlab |

| BigDL | BigDL | Verteilte DL-Library auf Basis von Python für Apache Spark; für Intel-Prozessoren | Erstellen von DL-Anwendungen als Spark-Programme; Ausführung auf Spark- oder Hadoop-Clustern; Unterstützung von Frameworks wie TensorFlow, Keras und Torch; hohe Performance und Skalierbarkeit |

| Caffe2 | Caffe2 | DL-Framework für Python; ursprünglich von Facebook entwickelt | Ziel: einfacher Zugang zu Deep-Learning-Modellen; vortrainierte Modelle; hohe Skalierbarkeit und Effizienz; enge Anbindung an PyTorch; noch keine optimale Lösung für komplexe DL-Projekte, die Debugging-Tools erfordern |

| Chainer | Chainer | DL-Framework auf Basis von Python; unterstützt von AWS, IBM, Intel und Nvidia | Anwendung vor allem bei der Spracherkennung; hohe Flexibilität und intuitive Bedienung; hohe Performance; Möglichkeit, vorhandene Netzwerke während der Laufzeit (Runtime) zu modifizieren; schwer zu debuggen; kleine Community |

| CLIPS | Pattern | ML; Web-Mining-Modul für Python | Anwendungen u. a. Data-Mining (Google, Twitter, Wikipedia etc.), Natural Language Processing, Clustering, Netzwerkanalyse |

| Gluon | Gluon | DL-Interface zum Erstellen von Modellen auf Basis von Toolkits wie Apache MXNET und Cognitive Toolkit von Microsoft | Von AWS und Microsoft vorgestellt; Ziel: Erstellen von DL-Modellen mit geringem Programmieraufwand |

| H2O | H2O | ML-Plattform auf Basis von Python und R; Open Source; auch als kommerzielle Enterprise-Plattform verfügbar | Anwendungsfelder u. a. Forderungsmanagement, Analyse, Betrugserkennung; Unterstützung von Random Forests, GLM, GBM, XGBoost, GLRM, Word2Vec; Workflow-Automatisierung mit AutoML; In-Memory-Datenbanken werden unterstützt |

Frameworks für Künstliche Intelligenz

| Frameworks für Künstliche Intelligenz (Teil 1) | |||

| Anbieter | Lösung(en) | Schwerpunkte | Besonderheiten |

| Amazon Web Services | Amazon SageMaker | Machine Learning (ML); Managed Service zum Erstellen, Trainieren und Bereitstellen von ML-Modellen | Gesamter Workflow von ML-Projekten abgedeckt; vorgefertigte Workflows und Schnittstellen für gängige Kennzeichnungsaufgaben; laut AWS um 70 Prozent geringerer Aufwand beim Markieren von Daten; Unterstützung von Frameworks wie TensorFlow, PyTorch, Apache MXNet |

| Amazon Web Services | KI-, DL- und ML-Services wie Comprehend, Forecast, Polly, Translate oder Rekognition | Vortrainierte KI-Services für Bild-/Videoanalyse, Personalisieren von Kundenerfahrungen, Dokumentenanalyse, Natural Language Processing etc. | Unterstützung von Frameworks wie TensorFlow, PyTorch, Apache MXNet |

| Apache | Mahout | Verteiltes Framework für das Erstellen von ML-Applikationen; Open Source | Basis: Hadoop MapReduce; hohe Skalierbarkeit; für effizientes Data-Mining bei großen Datenbeständen ausgelegt; Kritikpunkt: unzureichende Visualisierungsfunktionen |

| Apache | Mlib (Spark) | ML-Bibliothek für Python, Java, Scala und R; Open Source | Unterstützung von Spark und NumPy; Implementierung auf Hadoop, Apache Mesos, Kubernetes, Cloud, firmeneigenen Data-Centern; Einsatzfelder u. a. Regressionsanalysen, Clustering, Entscheidungsbäume, Empfehlungsalgorithmen |

| Apache | MXNET | DL-Bibliothek und Framework mit breiter Unterstützung von Programmiersprachen; Open Source | Unterstützt u. a. Python, C++, Julia, R und JavaScript; hohe Skalierbarkeit; Einsatz vor allem bei Sprach- und Bilderkennung, Natural Language Processing und Prognosen im Rahmen großer Projekte; gute Unterstützung von Grafikprozessoren; nicht so populär wie andere Frameworks |

| Apache | Singa | Deep Learning (DL); verteilte Plattform für Deep Learning; Open Source | Unterstützung von neuronalen Netzwerken wie Convolutional Neural Networks (CNN), Restricted Boltzmann Machines (RBM) und Recurrent Neural Networks (RNN); Fokus auf Anwendungen im Gesundheitsbereich und mit geringem Ressourcenbedarf; breite Hardware-Unterstützung; für synchrone, asynchrone und hybride Trainings-Frameworks |

| Apache | SystemML | ML-Framework; ursprünglich von IBM; seit Ende 2018 Open Source | Anwendungen u. a. deskriptive Statistiken, Klassifizierungen, Regressionsanalysen, Matrix-Faktorisierung; für die Analyse großer Datenbestände; läuft in Apache-MapReduce- oder Apache-Spark-Umgebungen |

| Berkeley Vision and Learning Center | Caffe | DL-Framework auf Basis von C++ mit Python-Interface und Schwerpunkt auf Bilderkennung | Nachfolger ist Caffe2; Anwendungen - neben Bildanalyse - Spracherkennung und Robotics-Applikationen; weniger geeignet für Text- und Sprachanalyse und Zeitreihenanalyse; Unterstützung von Convolutional Neural Networks; Schnittstellen zu C, C++, Python, Matlab |

| BigDL | BigDL | Verteilte DL-Library auf Basis von Python für Apache Spark; für Intel-Prozessoren | Erstellen von DL-Anwendungen als Spark-Programme; Ausführung auf Spark- oder Hadoop-Clustern; Unterstützung von Frameworks wie TensorFlow, Keras und Torch; hohe Performance und Skalierbarkeit |

| Caffe2 | Caffe2 | DL-Framework für Python; ursprünglich von Facebook entwickelt | Ziel: einfacher Zugang zu Deep-Learning-Modellen; vortrainierte Modelle; hohe Skalierbarkeit und Effizienz; enge Anbindung an PyTorch; noch keine optimale Lösung für komplexe DL-Projekte, die Debugging-Tools erfordern |

| Chainer | Chainer | DL-Framework auf Basis von Python; unterstützt von AWS, IBM, Intel und Nvidia | Anwendung vor allem bei der Spracherkennung; hohe Flexibilität und intuitive Bedienung; hohe Performance; Möglichkeit, vorhandene Netzwerke während der Laufzeit (Runtime) zu modifizieren; schwer zu debuggen; kleine Community |

| CLIPS | Pattern | ML; Web-Mining-Modul für Python | Anwendungen u. a. Data-Mining (Google, Twitter, Wikipedia etc.), Natural Language Processing, Clustering, Netzwerkanalyse |

| Gluon | Gluon | DL-Interface zum Erstellen von Modellen auf Basis von Toolkits wie Apache MXNET und Cognitive Toolkit von Microsoft | Von AWS und Microsoft vorgestellt; Ziel: Erstellen von DL-Modellen mit geringem Programmieraufwand |

| H2O | H2O | ML-Plattform auf Basis von Python und R; Open Source; auch als kommerzielle Enterprise-Plattform verfügbar | Anwendungsfelder u. a. Forderungsmanagement, Analyse, Betrugserkennung; Unterstützung von Random Forests, GLM, GBM, XGBoost, GLRM, Word2Vec; Workflow-Automatisierung mit AutoML; In-Memory-Datenbanken werden unterstützt |

Übersicht: Frameworks für Künstliche Intelligenz (Teil 2)

| Frameworks für Künstliche Intelligenz (Teil 2) | |||

| Anbieter | Lösung(en) | Schwerpunkte | Besonderheiten |

| Intel Nervana | Intel Neon | DL-Framework auf Basis von Python; Open Source; von Intels Unternehmensbereich Nervana entwickelt | Anwendungsfelder u. a. Bild- und Sprachanalyse, Videospiele, Natural Language Processing; optimiert für Intel-Prozessorarchitektur (Xeon); Unterstützung von Modellen wie Convolutional Neural Networks, RNNs, LSTM |

| Keras | Keras | DL; Open-Source-Bibliothek mit Schnittstellen-Funktion zu ML-/DL-Frameworks; Ziel: Deep-Learning-Experimente, die schnelle Resultate erbringen | Unterstützung von TensorFlow, Theano, Microsoft Cognitive Toolkit und der Programmiersprachen Python und R; für Convolutional Neural Networks und Recurrent Neural Networks; einfache Handhabung, daher auch für Einsteiger tauglich |

| Mathworks |

Matlab Deep Learning Toolbox |

DL-Framework für den Entwurf und die Implementierung von tiefen neuronalen Netzen | Anwendungsfelder u. a. Klassifikation und die Regression für Bild-, Zeitreihen- und Textdaten; Unterstützung von CNNs und LSTM-Netzen; Nutzung vortrainierter Modelle von TensorFlow und Caffe; vergleichbare Toolbox für ML verfügbar |

| Microsoft | Azure AI | DL- und KI-Services auf Microsofts Cloud-Plattform Azure | Anwendungsfelder: Bild-und Sprachanalyse, maschinelle Textübersetzung; kombiniert Angebote von Microsoft wie Machine Learning und Knowledge Mining mit Azure Search |

| Microsoft |

Azure Machine Learning |

Cloudbasierter ML-Service von Microsoft auf Basis von Python; Bereitstellung über Azure | Ziel: Erstellen und Trainieren von ML-Modellen; Unterstützung von Tools wie Visual Studio Code (VS Code), PyCharm, Jupyter und Azure Databricks; Unterstützung von ML- und DL-Frameworks wie scikit-learn, PyTorch, TensorFlow |

| Microsoft | CNTK | DL-Toolkit auf Open-Source-Basis für umfangreiche Deep-Learning-Projekte | Unterstützung von Python, C++, C#, Java; für Convolutional Neural Networks und Recurrent Neural Networks; wird in Skype, Xbox und beim Sprachassistenten Cortana verwendet; unterstützt Apache Spark; Einbindung in Microsoft-Cloud-Plattform Azure; hoher Optimierungsgrad und geringer Ressourcenbedarf |

| Microsoft DMTK | DMTK | Verteiltes ML-Toolkit auf Basis von C++; Open Source; stammt von Microsoft | DMTK Framework als Basis für Parallelisierung von Daten und Aufbau hybrider Datenstrukturen sowie Training von Modellen; schnelle und skalierbare Modelle; Multisense-Word-Embedding-Funktion; vor allem für die Analyse großer Datenbestände (Big Data) |

| Nvidia | Deep Learning SDK |

Software Development Kit mit Tools und Libraries für Entwicklung von DL- und ML- Anwendungen auf Basis von Grafikprozessoren von Nvidia |

Beispiele: Nvidia NCCL für optimierten Zugriff von Frameworks auf Systeme mit mehreren, parallel arbeitenden GPUs; Deep Learning Primitives (cuDNN) mit Komponenten für DL-Anwendungen; Deep Learning GPU Training System (DIGITS) zum Trainieren von DL-Netzen für Aufgaben wie Bilderkennung und Identifizieren von Objekten |

| PaddlePaddle | PaddlePaddle | DL-Frameworks auf Basis von Python; entwickelt vom chinesischen Unternehmen Baidu; Open Source | Basis: Deep Learning Programming Language; Anwendungsfelder u. a. komplexe Berechnungen, Bild- und Sprachanalyse; Visualisierungs-Tool für DL vorhanden |

| PyTorch | PyTorch | DL-Framework; Nachfolger von Torch auf Basis von Python; Open Source; Konkurrent von TensorFlow; von Facebook entwickelt | Schwerpunkt auf schneller und effizienter Entwicklung von DL-Modellen; einfache Modellierung; Unterstützung bekannter Debugging-Tools wie PyCharm und ipdb; viele vortrainierte Modelle; Support für Text, Natural Language Processing, Bildanalyse und verstärkendes Lernen |

| scikit-learn | scikit-learn | ML-Framework auf Basis von Python; Open Source | Funktionen u. a. Regressionsanalyse, Clustering, Klassifizierung von Objekten; Einsatz in Spam-Erkennung, Bildanalyse, Preisvergleich, Segmentierung von Kundengruppen; große und aktive Community; weite Verbreitung |

| Skymind | DL4J | DL-Framwework auf Basis von Java und Scala; Open Source | Anwendungsfelder u. a. Bildanalyse, Natural Language Processing, Text-Mining; Unterstützung von Convolutional Neural Networks (CNN), Recurrent Neural Networks (RNN), Long Short-Term Memory (LTSM); hohe Performance und Skalierbarkeit; Support von Apache Hadoop und Spark |

| TensorFlow | TensorFlow | Open-Source-Plattform für ML; Schwerpunkt: schnelles und effizientes Training von DL-Modellen; als Ersatz für Theano konzipiert | Einfaches Modellierungsverfahren; viele vortrainierte Modelle; Unterstützung diverser Programmiersprachen wie Python, C++ und R; Anwendungsfelder u. a. Sprach-, Text- und Bilderkennung, Zeitreihenanalysen, Videoanalyse; verteiltes Training möglich; laut einigen Fachleute niedrigere Performance als CNTK und MXNET sowie anspruchsvolles Debugging |

| Frameworks für Künstliche Intelligenz (Teil 2) | |||

| Anbieter | Lösung(en) | Schwerpunkte | Besonderheiten |

| Intel Nervana | Intel Neon | DL-Framework auf Basis von Python; Open Source; von Intels Unternehmensbereich Nervana entwickelt | Anwendungsfelder u. a. Bild- und Sprachanalyse, Videospiele, Natural Language Processing; optimiert für Intel-Prozessorarchitektur (Xeon); Unterstützung von Modellen wie Convolutional Neural Networks, RNNs, LSTM |

| Keras | Keras | DL; Open-Source-Bibliothek mit Schnittstellen-Funktion zu ML-/DL-Frameworks; Ziel: Deep-Learning-Experimente, die schnelle Resultate erbringen | Unterstützung von TensorFlow, Theano, Microsoft Cognitive Toolkit und der Programmiersprachen Python und R; für Convolutional Neural Networks und Recurrent Neural Networks; einfache Handhabung, daher auch für Einsteiger tauglich |

| Mathworks |

Matlab Deep Learning Toolbox |

DL-Framework für den Entwurf und die Implementierung von tiefen neuronalen Netzen | Anwendungsfelder u. a. Klassifikation und die Regression für Bild-, Zeitreihen- und Textdaten; Unterstützung von CNNs und LSTM-Netzen; Nutzung vortrainierter Modelle von TensorFlow und Caffe; vergleichbare Toolbox für ML verfügbar |

| Microsoft | Azure AI | DL- und KI-Services auf Microsofts Cloud-Plattform Azure | Anwendungsfelder: Bild-und Sprachanalyse, maschinelle Textübersetzung; kombiniert Angebote von Microsoft wie Machine Learning und Knowledge Mining mit Azure Search |

| Microsoft |

Azure Machine Learning |

Cloudbasierter ML-Service von Microsoft auf Basis von Python; Bereitstellung über Azure | Ziel: Erstellen und Trainieren von ML-Modellen; Unterstützung von Tools wie Visual Studio Code (VS Code), PyCharm, Jupyter und Azure Databricks; Unterstützung von ML- und DL-Frameworks wie scikit-learn, PyTorch, TensorFlow |

| Microsoft | CNTK | DL-Toolkit auf Open-Source-Basis für umfangreiche Deep-Learning-Projekte | Unterstützung von Python, C++, C#, Java; für Convolutional Neural Networks und Recurrent Neural Networks; wird in Skype, Xbox und beim Sprachassistenten Cortana verwendet; unterstützt Apache Spark; Einbindung in Microsoft-Cloud-Plattform Azure; hoher Optimierungsgrad und geringer Ressourcenbedarf |

| Microsoft DMTK | DMTK | Verteiltes ML-Toolkit auf Basis von C++; Open Source; stammt von Microsoft | DMTK Framework als Basis für Parallelisierung von Daten und Aufbau hybrider Datenstrukturen sowie Training von Modellen; schnelle und skalierbare Modelle; Multisense-Word-Embedding-Funktion; vor allem für die Analyse großer Datenbestände (Big Data) |

| Nvidia | Deep Learning SDK |

Software Development Kit mit Tools und Libraries für Entwicklung von DL- und ML- Anwendungen auf Basis von Grafikprozessoren von Nvidia |

Beispiele: Nvidia NCCL für optimierten Zugriff von Frameworks auf Systeme mit mehreren, parallel arbeitenden GPUs; Deep Learning Primitives (cuDNN) mit Komponenten für DL-Anwendungen; Deep Learning GPU Training System (DIGITS) zum Trainieren von DL-Netzen für Aufgaben wie Bilderkennung und Identifizieren von Objekten |

| PaddlePaddle | PaddlePaddle | DL-Frameworks auf Basis von Python; entwickelt vom chinesischen Unternehmen Baidu; Open Source | Basis: Deep Learning Programming Language; Anwendungsfelder u. a. komplexe Berechnungen, Bild- und Sprachanalyse; Visualisierungs-Tool für DL vorhanden |

| PyTorch | PyTorch | DL-Framework; Nachfolger von Torch auf Basis von Python; Open Source; Konkurrent von TensorFlow; von Facebook entwickelt | Schwerpunkt auf schneller und effizienter Entwicklung von DL-Modellen; einfache Modellierung; Unterstützung bekannter Debugging-Tools wie PyCharm und ipdb; viele vortrainierte Modelle; Support für Text, Natural Language Processing, Bildanalyse und verstärkendes Lernen |

| scikit-learn | scikit-learn | ML-Framework auf Basis von Python; Open Source | Funktionen u. a. Regressionsanalyse, Clustering, Klassifizierung von Objekten; Einsatz in Spam-Erkennung, Bildanalyse, Preisvergleich, Segmentierung von Kundengruppen; große und aktive Community; weite Verbreitung |

| Skymind | DL4J | DL-Framwework auf Basis von Java und Scala; Open Source | Anwendungsfelder u. a. Bildanalyse, Natural Language Processing, Text-Mining; Unterstützung von Convolutional Neural Networks (CNN), Recurrent Neural Networks (RNN), Long Short-Term Memory (LTSM); hohe Performance und Skalierbarkeit; Support von Apache Hadoop und Spark |

| TensorFlow | TensorFlow | Open-Source-Plattform für ML; Schwerpunkt: schnelles und effizientes Training von DL-Modellen; als Ersatz für Theano konzipiert | Einfaches Modellierungsverfahren; viele vortrainierte Modelle; Unterstützung diverser Programmiersprachen wie Python, C++ und R; Anwendungsfelder u. a. Sprach-, Text- und Bilderkennung, Zeitreihenanalysen, Videoanalyse; verteiltes Training möglich; laut einigen Fachleute niedrigere Performance als CNTK und MXNET sowie anspruchsvolles Debugging |

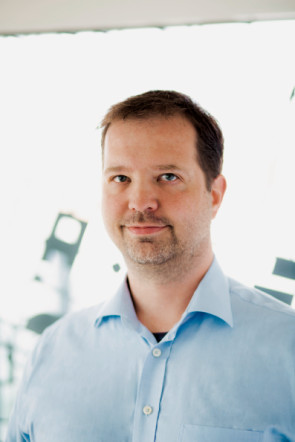

Im Gespräch mit Dr. Christop Angerer von Nvidia

Eigentlich steht Deutschland in Bezug auf Künstliche Intelligenz nicht gar so schlecht da, meint Christoph Angerer, Manager AI Developer Technologies Europe bei Nvidia. Doch einige Hürden gebe es doch.

Computerworld: Wo liegen hierzulande die grössten Hemmnisse für den Einsatz von KI?

Christoph Angerer: In vielen Bereichen mangelt es noch immer am nötigen Know-how und an den Ressourcen für die Umsetzung von KI-Projekten. Viele Infrastrukturprojekte werden nach wie vor von IT-Abteilungen definiert und ausgeführt. Dort ist jedoch die Fachkenntnis für die Implementierung der geeigneten KI-Umgebung oft nicht ausreichend. Ausserdem sind häufig die Daten für KI-Projekte oder maschinelles Lernen aus den verschiedenen Abteilungen nicht greifbar oder lassen sich aus technischen Gründen nicht zusammenführen. Deshalb bedarf es einer gut durchdachten Datenstrategie, um die Qualität der Daten zu gewährleisten und um sicherzustellen, dass ausreichende Informationsbestände zur Verfügung stehen.

Computerworld: Oft mangelt es auch an KI-Spezialisten.

Angerer: Ja, häufig fehlt es Unternehmen an Datenwissenschaftlern, die für die Implementierung der KI-Plattformen nötig sind. Der Mangel an KI-Fachkräften ist in Deutschland ein akutes Thema, das von vielen Seiten angegangen werden muss. Die Universitäten bieten jetzt zwar deutlich mehr Kurse für Data Science an, aber eine Weiterbildung für spezielle Branchen ist noch schwierig. Hier setzt das von Nvidia gegründete Deep Learning Institute an. Es bietet Firmen online oder vor Ort rund 50 Kurse zu Themen an wie KI im Gesundheitswesen, autonomes Fahren, Finanzwesen, Robotics und Intelligent Video Analytics.

Computerworld: Wie steht es um die Akzeptanz von KI in deutschen Unternehmen. Erkennen sie den Nutzen der Technologie?

Angerer: Laut einer IDC-Studie von 2017 war Deutschland im Bereich IoT führend, hinkte aber beim Einsatz von KI hinterher. Stark vertreten in der Entwicklung von KI-Produkten waren eher Start-ups, die flexibler und schneller die neuen Strömungen in der KI-Methodik umsetzen konnten. 2018 und 2019 haben aber viele grosse deutsche Unternehmen in die KI-Entwicklung investiert und Kooperationen mit der Forschung und Start-up-Hubs gestartet. Einen grossen Schub hat die Initiative appliedAI von UnternehmerTUM gebracht. Sie stellt jungen Unternehmen eine Infrastruktur mit KI-Plattformen zur Verfügung, mit der sie ihre Projekte vorantreiben und Kontakte in die Industrie aufbauen können. Doch auch grössere Firmen haben mittlerweile das Potenzial der Initiative erkannt und sind ihr beigetreten. Im Automobilbereich ist dadurch im baden-württembergischen Cyber Valley eine der grössten Forschungskooperationen Europas aus Wissenschaft und Wirtschaft entstanden.

Computerworld: Wird Deutschland in der KI-Forschung von Ländern wie China, Indien, USA oder Korea abgehängt?

Angerer: Deutschland hat im Bereich der KI-Forschung eine lange Tradition. Nicht umsonst beherbergt es mit dem DFKI das grösste KI-Forschungszentrum Europas. Auch viele Universitäten haben in der KI-Forschung umfangreiches Wissen und Talent angesammelt. Der Unterschied zum Silicon Valley liegt eher an der konservativeren Ausrichtung bei der Unterstützung von neuen Initiativen und Start-ups. Solche jungen Unternehmen müssen in Deutschland mehr Unterstützung finden und leichter mit grösseren Firmen kooperieren können.

Computerworld: Deutschland ist ein Land des Mittelstands. Wie können solche Unternehmen KI-Anwendungen entwickeln?

Angerer: Eine Hürde für viele mittelständige Unternehmen ist die Planung und Erstellung einer hauseigenen KI-Infrastruktur. Abhilfe können vorgefertigte KI-Lösungen und Plattformen schaffen, die sich für Einsteiger eignen, aber auch im Rechenzentrumsbereich eingesetzt werden können. Solche Systeme enthalten in der Regel die Hardware und das komplette Software-Paket für den Einsatz von KI. Dies reduziert den Aufwand für das Aufsetzen der Software-Umgebung von Tagen oder Wochen auf wenige Stunden. Für Unternehmen, die erst einmal mit KI experimentieren wollen, bietet sich auch die Cloud an. Grosse Unternehmen auf diesem Gebiet bieten inzwischen KI- und ML-Instanzen für die Datenanalyse an. So können Firmen testen, ob die Implementierung von KI für sie sinnvoll ist. Darüber hinaus haben sie die Möglichkeit, durch die Miete von weiteren Instanzen die Testszenarien flexibel zu skalieren und gegebenenfalls später in die eigene IT-Infrastruktur zu verlagern.

Kasten: Wie intelligent ist KI?

Intelligenztest

Wie intelligent sind KI-Algorithmen wirklich? Mit dieser Frage beschäftigten sich Forscher der TU Berlin, des Fraunhofer-Heinrich-Hertz-Instituts (HHI) und der Singapore University of Technology and Design. Wissenschaftlern und Nutzern von KI-Lösungen bleibt nämlich meist unklar, wie ein KI-System zu einer Entscheidung kommt. Und damit ist auch nicht transparent, ob eine solche Lösung tatsächlich «intelligente» Entscheidungen trifft oder nur statistisch erfolgreiche Methoden verwendet. Um das herauszufinden, haben die Forscher die Verfahren «Layerwise Relevance Propagation» (LRP) und «Spectral Relevance Analysis» (SpRAy) entwickelt. Damit können auch in grossen Datensätzen unerwünschte Entscheidungen identifiziert werden.

Die Untersuchung von KI-Lösungen mit Hilfe von SpRAy brachten ein sehr interessantes Ergebnis: «Selbst moderne KI-Systeme haben nicht immer einen aus menschlicher Perspektive sinnvollen Lösungsweg gefunden, sondern nutzten bisweilen Clever-Hans-Strategien», berichtet Wojciech Samek, Gruppenleiter am Fraunhofer HHI.

Der «kluge Hans» war ein Pferd, das in den Jahren vor dem Ersten Weltkrieg dafür berühmt war, komplexe Rechenaufgaben lösen zu können. Doch stellte sich letztlich heraus, dass das Pferd an der Mimik und Körpersprache der Zuschauer erkannte, ob es das richtige Ergebnis per Klopfen mit dem Huf oder Schütteln des Kopfes erraten hatte.

Auch bei einigen KI-Systemen stiessen die Forscher auf naive Lösungsansätze. Ein preisgekröntes Bildanalysesystem stufte beispielsweise Bilder anhand des Kontexts ein. So wurden Aufnahmen als «Schiff» klassifiziert, wenn viel Wasser zu sehen war, oder als «Zug», wenn die Aufnahme Schienen zeigte. Eine korrekte Identifizierung des eigentlichen Objekts unterblieb, also etwa des Zugs. Laut TU Berlin und HHI ist denkbar, dass etwa die Hälfte der eingesetzten KI-Systeme nach dem Verfahren «Kluger Hans» arbeitet. Das sei problematisch, wenn solche Lösungen in sicherheitskritischen Bereichen oder der medizinischen Diagnostik eingesetzt würden.

Doch konnten die Forscher auch KI-Anwendungen ermitteln, die tatsächlich «schlau» vorgehen. Dazu zählten Systeme, die Spiele wie «Pinball» und «Breakout» beherrschen. Ihre Algorithmen verstanden nicht nur die Funktionsweise der Spiele, sondern fanden auch höchst originelle Wege, um möglichst viele Punkte zu erzielen.

Die Test-Software der TU Berlin und des Heinrich-Hertz-Instituts steht als Open Source allen interessierten Fachleuten zur Verfügung.