Herausforderung KI

14.07.2020, 12:00 Uhr

KI-Hype zwischen Erfolg und enttäuschter Hoffnung

Algorithmen sind dümmer, als wir denken. KI-Systeme sind nur in ihrem eng begrenzten Einsatzgebiet höchst effizient. Weichen die Voraussetzungen jedoch ab, droht ein Scheitern.

Es war eine Sternstunde der KI-Forschung: Google-CEO Sundar Pichai demonstrierte live auf der Entwicklerkonferenz «Google I/O 2018» einen Sprachbot, dessen Konversationsfähigkeiten sich nicht mehr von denen eines Menschen unterscheiden liessen. Der Google-Assistent unterhielt sich locker mit seinen Gesprächspartnern, buchte einen Friseurtermin und liess sich selbst von einer begriffsstutzigen Restaurantmitarbeiterin nicht aus der Ruhe bringen, die seine Reservierungsversuche torpedierte. Sogar typisch menschliche Füllwörter wie «mh» und «äh» fügte der Assistent in seine Rede ein. Basis dieser Revolution sei die Technologie Google Duplex, so Pichai, an der das Unternehmen seit Jahren arbeite.

Doch schon bald nach der beeindruckenden Demo mehrten sich Zweifel an der Echtheit der vorgespielten Konversationen. Nach Ansicht der investigativen Nachrichtenseite Axios unterschieden sich die Aufnahmen deutlich von realistischen Anrufen bei Friseuren oder in Restaurants. Die Gesprächspartner nannten nicht wie üblich den Namen des Betriebs, es gab keinerlei Hintergrundgeräusche und es wurden keine Telefonnummern abgefragt. Google reagierte auf diese Vorwürfe mit Schweigen, Nachfragen wurden nicht beantwortet.

Egal ob die Aufnahmen echt waren oder nicht - die meisten Chatbots und Sprachassistenten sind nach wie vor viel dümmer als uns die Anbieter glauben machen wollen. «Niemand mag Chatbots», sagt Pieter Buteneers, CTO des Bot-Entwicklers Chatlayer.ai auf der «ML Conference 2019» in München. «Die Interaktion mit ihnen ist meist eine lausige Erfahrung.» Bots scheitern oft schon daran, zu verstehen, was der Mensch von ihnen will. Um mit einem Menschen eine Unterhaltung zu führen, muss der Assistent nämlich zunächst einmal dessen Absicht (Intent) erkennen. Traditionelle regelbasierte Systeme stossen hier schnell an ihre Grenzen, daher setzen Bot-Programmierer für die Intent-Erkennung heute meist auf maschinelles Lernen. Unternehmen wie Microsoft, Google oder IBM bieten dazu vorgefertigte NLU-Systeme (Natural Language Unterstanding), die auf das Verstehen menschlicher Sprache trainiert wurden. Buteneers Erfahrungen mit diesen Werkzeugen waren jedoch alles andere als berauschend. «Wir testeten als Erstes Microsoft LUIS», berichtet er auf der ML Conference 2019, «aber wir stellten sehr schnell fest, dass die Performance wirklich schlecht war.» Nach Tests von Chatlayer.ai erzielte LUIS nur eine Trefferquote von 80 Prozent. «Das klingt hoch», so Buteneer, «aber es bedeutet im Umkehrschluss, dass jede fünfte Konversation falsch klassifiziert wird.» Google DialogFlow und IBM Watson leisteten sich deutlich weniger Fehler, irrten aber immer noch in 10 bis 15 Prozent der Fälle.

Ein zweiter Grund für die schlechte Erkennungsrate liegt in der Wahl des Trainingsmaterials. «Wenn die für das Training verwendeten Ausdrücke zu ähnlich sind, lernt das System die falschen Zusammenhänge», erklärt Buteneers. Es sei daher wichtig, auf eine möglichst grosse Variation in der Wortreihenfolge zu achten und für Schlüsselwörter so viele Synonyme wie möglich einzubeziehen. Viele Unternehmen vergessen laut Buteneers ausserdem, den Chatbot kontinuierlich zu verbessern. «Das liegt wahrscheinlich daran, dass viele Bots erst gar nicht in den produktiven Einsatz gelangen.»

Hintergrund

Schwache versus starke KI

Künstliche Intelligenz lässt sich prinzipiell in zwei Klassen einteilen:

Schwache KI: Diese Programme und Algorithmen können konkrete Fragestellungen bearbeiten und sind für spezifische Anwendungsfälle konzipiert. Ändern sich die Voraussetzungen oder lässt sich das Problem mit der vorgegebenen Verfahrensweise nicht lösen, scheitert schwache KI. Sie muss dann von Menschen neu trainiert oder umprogrammiert werden. Typische Anwendungsfälle für schwache KI sind Bild-, Text- und Spracherkennung, Empfehlungs- und Navigationssysteme, automatische Übersetzung und Korrekturvorschläge in Rechtschreib- und Suchprogrammen sowie Expertensysteme. Alle derzeit verfügbaren KI-Anwendungen gehören in die Klasse der schwachen KI.

Starke KI: Ein starkes KI-System würde die kognitiven Fähigkeiten von Menschen erreichen oder sogar übertreffen. Es könnte frei und in natürlicher Sprache mit Menschen kommunizieren, logische Schlussfolgerungen ziehen, Pläne erstellen und diese situativ an veränderte Rahmenbedingungen anpassen, sich Ziele setzen und diese verfolgen. Ob auch Bewusstsein, Selbsterkenntnis oder gar Weisheit zu den obligatorischen Merkmalen gehören, wird kontrovers diskutiert. Ebenfalls umstritten ist die Frage, ob es überhaupt jemals starke KI-Systeme geben kann. Derzeit gibt es keine Anzeichen dafür, dass in absehbarer Zeit eine solche Superintelligenz entwickelt werden könnte.

Sag mir, wie ich mich fühle

Auch bei der KI-basierten Emotionsanalyse klaffen Wunsch und Wirklichkeit deutlich auseinander. Der Markt boomt, Analysten prognostizieren ein durchschnittliches globales Umsatzwachstum von 15 bis 17 Prozent pro Jahr, das Marktvolumen soll in drei Jahren bis zu 25 Milliarden Dollar betragen. Das ist kein Wunder, verspricht doch die Erkennung von Emotionen mit Hilfe von KI Kundengespräche effizienter und Werbemassnahmen wirksamer zu machen, die Personalsuche zu erleichtern und Betrüger schneller zu entlarven. Selbst Krankheiten wie Parkinson und Depressionen sollen sich über die Analyse emotionaler Zustände frühzeitig diagnostizieren lassen. Auch die Auto-Industrie setzt auf emotionale Kontrolle. Indem sie den Gefühlszustand des Fahrers überwachen, sollen intelligente Fahrzeugsysteme Unfälle durch Übermüdung und Konzentrationsschwäche verhindern helfen.

Wie meist in boomenden Märkten ist die Zahl der Anbieter gross und wächst ständig. Neben Branchenriesen wie Amazon, Microsoft und IBM beschäftigen sich jede Menge Start-ups wie Affectiva, Braingeneers, HireVue, Retorio oder Sightcorp mit der Deutung von Gesichtsausdrücken, Verhalten und Stimme. Auch deutsche Unternehmen wie Audeering, Precire Technologies oder Soma Analytics mischen kräftig mit.

Die Anbieter versprechen meist, Emotionen zuverlässiger erkennen zu können als ein menschliches Gegenüber. «Das mag durchaus stimmen», erklärt Ralph Ohnemus, Vorstand und CEO der K&A BrandResearch AG, der selbst viel Geld in Emotionsforschung investiert hat. «Menschen sind in der Regel nicht sehr gut darin, die Gefühle von anderen zu erkennen.»

“Wenn die grundlegenden Annahmen nicht stimmen, kann auch die beste KI keine sinnvollen Ergebnisse liefern„

Ralph Ohnemus, Vorstand und CEO bei K&A BrandResearch

Das Problem ist nur: Innere Zustände lassen sich gar nicht so eindeutig äusseren Gefühlsregungen zuordnen, wie es uns die Emotionsanalytiker glauben machen wollen. Ihre Systeme basieren meist auf Theorien wie der von Paul Ekman und Wallace V. Friesen. Die beiden Forscher entwickelten in den 1970er-Jahren das Facial Action Coding System (FACS). Ekman und Friesen zufolge lassen sich die Bewegungen der Gesichtsmuskulatur in 46 «Action Units» einteilen, aus deren Kombination sieben Basis-Emotionen ablesbar sind (Wut, Freude, Trauer, Ekel, Verachtung, Angst, Überraschung). Entsprechende Theorien gibt es auch für akustische Parameter in der Stimme und für Körperbewegungen.

Diese Vorstellung wird heute von den meisten unabhängigen Experten abgelehnt. In einer Metastudie analysierte etwa ein Wissenschaftlerteam um die amerikanische Psychologin Lisa Feldman Barrett mehrere Hundert Forschungsberichte zur Emotionserkennung. Das Ergebnis: Die Art und Weise, wie Menschen Gefühle kommunizieren, unterscheidet sich erheblich von Kultur zu Kultur, von Situation zu Situation und sogar von Mensch zu Mensch innerhalb derselben Situation. Darüber hinaus können ähnliche Kombinationen von Gesichtsbewegungen sehr unterschiedliche innere Zustände repräsentieren. Ein finsterer Blick etwa hängt nicht notwendigerweise mit Ärger oder Wut zusammen. «Wir haben ein falsches Emotionsmodell im Kopf», sagt Ralph Ohnemus. Emotionen seien weder unkontrollierbar noch eindeutig. «Es gibt eine extreme Bandbreite, wie wir Gefühle erleben», erläutert der Marktforscher. Das reiche bei Wut etwa von eiskaltem Schweigen bis zum unbeherrschten Herumbrüllen. «Das Erregungslevel ist bei beiden hoch, wie es sich nach aussen ausdrückt, ist jedoch extrem unterschiedlich.»

Besonders problematisch werden Emotionsanalysen dann, wenn auf ihrer Basis das Leben von Betroffenen beeinträchtigt oder sogar gefährdet wird. So nutzen die amerikanischen Zoll- und Einwanderungsbehörden ICE (Immigration and Customs Enforcement) und CBP (Customs Border Patrol) den KI-Service Amazon Rekognition, um illegale Einwanderer zu identifizieren. Rekognition soll furchtsame Menschen anhand ihres Gesichtsausdrucks erkennen können, und furchtsame Menschen haben etwas zu verbergen, so die Logik. «Amazon bietet das technologische Rückgrat für die brutale Deportations- und Inhaftierungsmaschine, die bereits heute Einwanderergemeinschaften terrorisiert», beklagt sich Audrey Sasson, die Exekutivdirektorin von Jews For Racial and Economic Justice in einer E-Mail-Botschaft.

Auch europäische Staaten testen den Einsatz KI-basierter Emotionserkennung für den Grenzschutz. Das von der EU geförderte Projekt iBorderCtrl entwickelt unter anderem einen virtuellen Grenzbeamten, der anhand unwillkürlicher Gesichtsausdrücke feststellen soll, ob eine Person lügt. Ohnemus hat da grundsätzliche Bedenken: «Ich glaube, dass das Modell, wie Menschen Emotionen ausdrücken, prinzipiell falsch ist», erklärt er. «Und wenn die grundlegenden Annahmen nicht stimmen, kann auch die beste KI keine sinnvollen Ergebnisse liefern.»

Kunden, die dieses Buch kauften …

Online-Shops, Streaming-Anbieter und Vermittlungsplattformen lieben sie: Empfehlungsalgorithmen, die Kunden zuverlässig auf der Webseite halten, sie zu zusätzlichen Käufen oder Klicks animieren und dabei auch noch Nutzererlebnis und Zufriedenheit steigern. Bei der Entwicklung solcher Empfehlungssysteme gibt es allerdings eine Reihe prinzipieller Probleme. Das erste liegt in der Topologie einer Webseite begründet. Viele Entwickler nutzen Informationen aus dem Klick-Stream der Kunden, um Empfehlungsmodule zu trainieren. Wenn ein Nutzer zunächst Produkt A und dann Produkt B anklickt, wird eine positive Verknüpfung zwischen A und B hergestellt. Die Klickreihenfolge hängt jedoch stark von der Positionierung der Elemente auf einer Webseite ab. Werden Produkte nebeneinander angezeigt, steigt die Wahrscheinlichkeit, dass beide angeklickt werden. Empfehlungsalgorithmen, die solche topologischen Faktoren nicht berücksichtigen, verwechseln Relevanz mit Nachbarschaft und verknüpfen unter Umständen die falschen Produkte. Hung-Hsuan Chen und andere konnten nachweisen, dass Algorithmen, bei deren Training nicht auf die Positionierung der Waren geachtet wird, eher das Layout einer Webseite repräsentieren als die tatsächliche Relevanz von Produkten für den Nutzer («Common pitfalls in training and evaluating recommender systems»).

Ein ähnliches Problem tritt auf, wenn ein bereits vorhandenes Empfehlungssystem durch ein neues ersetzt werden soll, das gerade trainiert wird. Die Wahrscheinlichkeit ist sehr hoch, dass der neue Empfehlungsalgorithmus bei Tests schlechter performt als der alte, auch wenn seine Empfehlungen tatsächlich besser sind. Auch dieses Problem hängt mit der Verfügbarkeit zusammen. Legt ein Kunde auf der Webseite ein Produkt in den Warenkorb, werden ihm die Empfehlungen des bereits implementierten alten Systems angezeigt. Die Wahrscheinlichkeit ist daher gross, dass er eine dieser Empfehlungen wählt. Die Vorschläge des neuen Systems sieht der Nutzer aber nicht, da dieses ja noch nicht implementiert ist. Für eine belastbare Aussage über die Vorhersagegüte müssen daher beide Algorithmen in einem A/B-Test gegeneinander antreten.

Auch die Click Through Rate (CTR) als gern genommenes Mass für die Güte eines Empfehlungsalgorithmus kann zu falschen Ergebnissen führen. Sie misst das Verhältnis von tatsächlichen Klicks auf ein Produkt zu der Häufigkeit, mit der es in den Empfehlungen auftaucht. Chen und die Mitautoren konnten zeigen, dass die CTR nur sehr schwach mit dem Umsatz korreliert, der durch die Empfehlung erzeugt wird. Mit anderen Worten: Empfehlungsalgorithmen, die auf eine möglichst hohe CTR hin optimiert sind, gewährleisten nicht unbedingt, dass Kunden tatsächlich auch mehr kaufen.

Ein von Chen und seinen Kollegen durchgeführter A/B-Test stellt den Sinn von Empfehlungssystemen sogar prinzipiell infrage. Die Autoren lenkten 5 Prozent der Nutzer einer asiatischen E-Commerce-Seite auf einen Channel mit und 5 Prozent auf denselben Channel ohne Empfehlungssystem. Tatsächlich kauften die Nutzer auf dem Channel mit Empfehlungssystem vermehrt die empfohlenen Produkte. Verglich man jedoch den Umsatz auf beiden Testseiten, so ergab sich ein nahezu deckungsgleiches Bild. Die Kunden hatten auch ohne Empfehlung in etwa gleich viel gekauft. «Empfehlungssysteme können die Nutzererfahrung des Kunden verbessern, sie sorgen aber nicht zwangsläufig für zusätzliche Einnahmen», lautet das Fazit der Autoren.

Der künstliche Kunde

Auch das Marketing setzt vermehrt auf Künstliche Intelligenz. Einer Studie der MIT Sloan School of Management und Google zufolge («Improving Strategic Execution with Machine Learning») glaubten 74 Prozent der Umfrageteilnehmer, die Ziele der Organisation besser erreichen zu können, wenn mehr in die Bereiche maschinelles Lernen und Automatisierung investiert würde. KI soll Kundenverhalten und Trends vorhersagen, Wettbewerber und Zielgruppen analysieren, Werbe- und Lead-Generierungs-Kampagnen optimieren und insgesamt Marketing-Aktivitäten automatisieren.

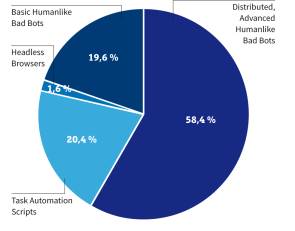

Bei dem Versuch, den Kunden zielgenau zu adressieren, ihn besser kennenzulernen und ihn zu mehr Umsatz zu motivieren, treffen die Marketing-Experten jedoch immer häufiger auf ein Problem: Das Gegenüber ist kein Mensch. Dem Sicherheitsunternehmen Imperva zufolge wurden im vergangenen Jahr rund 24 Prozent des Internetverkehrs von bösartigen Bots generiert, ein Zuwachs um 18 Prozent gegenüber dem Vorjahr. Besonders E-Commerce-Anbieter leiden unter den künstlichen Kunden. Im Jahr 2019 waren laut einer Studie des Sicherheitsexperten Radware 30 Prozent des Verkehrs auf Login-Seiten von Online-Shops auf Bots zurückzuführen. Auf Produktseiten betrug der Anteil 27 Prozent, und Warenkörbe wurden zu einem Fünftel von nicht menschlichen Einkäufern befüllt. 58 Prozent der Attacken entfielen dabei auf intelligente Bots, die menschliches Verhalten nachahmen und üblichen Abwehrmassnahmen entgehen können. Selbst bei einfachen Angriffen wie dem Scraping, bei dem Bots die Preise oder Inhalte auf einer Webseite abgreifen, verzeichnete Radware einen Anteil menschenähnlicher Bots von über 50 Prozent.

Ohne Spezialwerkzeuge sind Shop-Betreiber weitgehend machtlos dagegen. «Herkömmliche Abwehrmethoden beschränken sich auf die Verfolgung gefälschter Cookies, User Agents und IP-Reputation», erklärt Michael Tullius, Managing Director DACH bei Radware. «Um diese Art von Angriffen zu verhindern, benötigt man speziell entwickelte Lösungen zur Bot-Abwehr, die ausgeklügelte automatisierte Aktivitäten erkennen und dabei helfen können, vorbeugende Massnahmen zu ergreifen.»

Auch Captcha (Completely Automated Public Turing Test to Tell Computers and Humans Apart) schützen nicht vor den bösen Bots. Schon 2012 stellten Claudia Cruz-Perez und ihre Kollegen von der Universidad de las Américas Puebla im mexikanischen Cholula eine KI-basierte Methode zur Captcha-Überwindung vor. Sie nutzten Support-Vector Machines (SVM) und erzielten beim Knacken von Captchas eine Erfolgsquote von 82 Prozent. Durch den Einsatz von Deep Learning liess sie sich sogar auf über 90 Prozent steigern.

Artificial Discrimination

Noch immer hält sich die Vorstellung hartnäckig, Computerprogramme seien neutral, unbestechlich und vorurteilsfrei. Ein gutes Beispiel für diese Einstellung ist der Chef des österreichischen Arbeitsmarktservices AMS, Johannes Kopf. Auf Vorwürfe, die vom AMS eingeführten Algorithmen zur Bewertung von Arbeitslosen diskriminierten ältere, alleinerziehende und ausländische Arbeitssuchende, reagierte er mit Unverständnis: «Nicht das System diskriminiert, sondern es gibt alleine Auskunft über die Arbeitsmarktchancen», erklärte Kopf gegenüber dem Netzmagazin «Futurezone». Auch die Trefferquote von 85 Prozent hielt Koch für «sehr gut», obwohl diese Rate bedeutet, dass rund 50'000 Menschen im Jahr falsch klassifiziert werden.

Sarah Spiekermann, Leiterin des Lehrstuhls für Wirtschaftsinformatik und Gesellschaft an der Wirtschaftsuniversität Wien, kritisiert diese Einstellung scharf: «Der gegenwärtig mir bekannte Stand der Technik gibt es nicht her, verlässlich über einzelne Personen mit solcher Präzision zu urteilen, dass man darauf die weitere Förderung durch den Staat basieren dürfte», schreibt sie in ihrem Blog «Die ethische Maschine» auf «DerStandard.at». Spiekermann bezeichnet den Einsatz von Algorithmen zur Menschenklassifizierung als entwürdigend und naiv. «KIs stecken Menschen in Schubladen auf Basis von Regeln, die sie aus einer grossen Grundgesamtheit von Daten abgeleitet haben.»

“KIs stecken Menschen in Schubladen auf Basis von Regeln, die sie aus einer grossen Grundgesamtheit von Daten abgeleitet haben„

Prof. Dr. Sarah Spiekermann, Leiterin des Lehrstuhls für Wirtschaftsinformatik und Gesellschaft an der Wirtschaftsuniversität Wien

Der Einsatz von KI zur Bewertung von Arbeitslosen mag fragwürdig sein und berührt mit Sicherheit die Grundrechte der Betroffenen, es geht aber noch schlimmer. Falsch eingesetzt sind Algorithmen sogar in der Lage, das Leben von Menschen nachhaltig zu beeinträchtigen oder sogar zu zerstören. So verwenden etwa viele US-Justizbehörden das Vorhersagesystem COMPAS (Correctional Offender Management Profiling for Alternative Sanctions), um die Rückfallwahrscheinlichkeit von Straftätern abzuschätzen. Das System berechnet drei Scores: «Pretrial Release Risk» bezeichnet das Risiko, dass ein auf Kaution freigelassener Angeklagter noch vor dem Prozess Straftaten begeht, «General Recidivism» bewertet die generelle Rückfallwahrscheinlichkeit und «Violent Recidivism» prognostiziert die Wahrscheinlichkeit, dass der Delinquent zukünftig Gewalttaten verübt. Der Hersteller Equivant behauptet, auf Basis von nur sechs Faktoren eine Prognosegüte von 70 Prozent zu erreichen. Wissenschaftler bezweifeln den Nutzen solcher Systeme jedoch massiv. Laut Julia Dressel und Hany Farid vom Dartmouth College sind die Vorhersagen von COMPAS nicht besser als die von Menschen ohne oder mit geringem Fachwissen im Bereich der Strafjustiz.

Doch damit nicht genug: Der COMPAS-Algorithmus ist nicht nur unzuverlässig, sondern auch diskriminierend. Der Nachrichtenplattform «ProPublica» zufolge treten bei afroamerikanischen Straftätern rund doppelt so viele falsche Zuordnungen zur Hochrisikogruppe auf wie bei weissen (45 versus 23 Prozent). Die Diskriminierung durch Algorithmen ist im Übrigen nicht die Ausnahme, sondern die Regel. Laut dem Marktforschungsunternehmen Gartner werden bis 2022 rund 85 Prozent aller KI-Projekte fehlerhafte Ergebnisse liefern, weil die Datenbasis verzerrt ist oder bei der Programmierung und beim Training der Algorithmen unbewusst menschliche Vorurteile eingeflossen sind.

Fazit & Ausblick

Die Leistungen KI-basierter Systeme sind beeindruckend. Sie sind schneller, effizienter und zuverlässiger als jeder menschliche Experte, wenn es um die Mustererkennung in grossen Datenmengen und vieldimensionalen Datenräumen geht. In allen heutigen Anwendungsfällen handelt es sich jedoch um sogenannte «schwache KI».

Die Systeme sind in ihrem eng begrenzten Einsatzgebiet höchst effizient, scheitern aber schnell, wenn sich die Voraussetzungen auch nur ein wenig ändern. Die erstaunlichen Fortschritte dürfen nicht darüber hinwegtäuschen, dass Forschung und Entwicklung nach wie vor meilenweit von einer «starken KI» entfernt sind und nicht einmal in die Nähe menschlicher Intelligenzleistungen kommen. Es ist daher unseriös und gefährlich, ihnen Entscheidungen zu überlassen, die nur Menschen treffen können und dürfen.

Besonders problematisch wird der Glaube an die Allmacht der Algorithmen, wenn deren Empfehlungen das Leben der Betroffenen massiv beeinträchtigen können. Scheinbar gute Trefferquoten von 70, 80 oder auch 90 Prozent sind in solchen Fällen absolut inakzeptabel, denn sie bedeuten, dass Hunderte oder gar Tausende von Menschen falsch klassifiziert und damit unter Umständen entsprechend ungerecht behandelt werden.