Fujitsu Forum 2019: alles auf digitale Transformation

Deep Learning – KI-basiert und ressourcenschonend

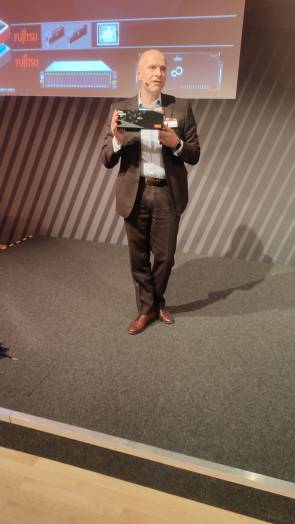

Neben der Digital-Annealer-Technologie will sich Fujitsu aber auch bei einer weiteren, spannenden Technologie mit grossen Zukunftsperspektiven breitmachen. Gemeint ist «Deep Learning», die sich an KI (künstliche Intelligenz) anlehnt. So präsentierte man auf der Messe seinen eigenen DLU-Chip (engl. für «Deep Learning Unit»).

Der KI-Chip soll, laut Fujitsu, für Kunden bereitstehen, die in ihren Produktionsprozessen in hohem Masse auf Deep-Learning-Modelle angewiesen sind – etwa in der Automobilbranche beim autonomen Fahren respektive bei der Bilderkennung und Auswertung. Die Voraussetzung dabei: Um überhaupt lernen zu können, sind, als zentraler Bestandteil eines entsprechenden Prozesses, eine möglichst grosse Anzahl qualitativ hochwertiger Daten Pflicht. Denn sie ermöglichen erst das KI-basierte Lernen. Im Fall des angesprochenen selbstständigen Fahrens von Autos sind für eine automatisierte Merkmalsextraktion und das Training teilweise eine siebenstellige Anzahl an Bilder und eine ähnlich hohe Anzahl an Videos nötig, um Fahrsituationen aufzuzeigen.

Aktuell ist Fujitsus AI-Zinarai-Deep-Learning-System, das während der Veranstaltung gezeigt wurde. Es soll einen Leistungs-pro-Watt-Wert, im Vergleich zu ähnlichen Systemen, um den Faktor zehn verbessern können, womit, so Reger nochmals eine deutliche Steigerung der Effizienz gegeben ist. Der teils erhebliche Zeitaufwand, der durch das Antrainieren entsteht, lässt sich durch geschicktes Vorgehen und durch parallelisierte sowie leistungsstarke Hardware, wie eben etwa Fujitsus KI-Chip, signifikant verkürzen.

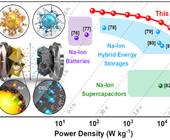

Hintergrund: Deep-Learning-Architekturen respektive -Chips spielen ihr Potenzial immer dann aus, wenn sie mithilfe grosser Datenmengen trainiert werden. Im Vergleich zu GPUs, wie etwa von AMD oder Nvidia, sind solche Deep-Learning-Chips noch spezieller auf das Durchführen solcher komplexer Arithmetikaufgaben spezifiziert. Im Gegenzug können solche hochgezüchteten KI-Chips keine Rendering-Aufgaben durchführen, wie sie Grafikchips eben auch beherrschen.