Big Data

08.02.2016, 14:36 Uhr

erfolgreiche Schweizer Mega-Cases

Die FIFA bekämpft Wettbetrügereien, LeShop optimiert Kunden-Segmente, die SBB will 600 Gigawatt-Stunden einsparen, 10 Prozent Umsatzsteigerung hat eine Schweizer Nahrungsmittelgruppe mit Predictive Analytics erreicht.

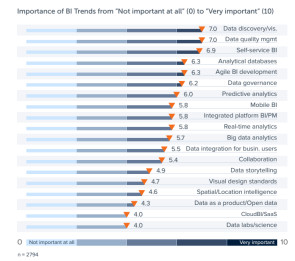

Leidenschaftlich diskutiert werden zurzeit Trendthemen wie Machine Learning und Real-Time Analytics. Aber lassen Sie sich nicht täuschen. Das sind nicht unbedingt auch die Geschäftsbereiche, in die bereits signifikante Investitionen fliessen. Es gilt wie immer die alte Regel: Erst wird diskutiert, dann investiert. Die Trendthemen bleiben vorerst den Early Adopters vorbehalten. Das auf BI spezialisierte Business Application Research Center (BARC) hat 2794 Anwenderunternehmen gefragt, was ihnen hier und heute unter den Nägeln brennt. 62 Prozent der Umfrageteilnehmer stammen aus der DACH-Region, die Studie ist also auch für die Schweiz interessant. Dabei kam heraus: Oberste Priorität geniesst in der Mehrzahl der Unternehmen die bedienfreundliche Visualisierung der Daten, wo man das Wichtigste auf einen Blick, oder spätestens auf den zweiten Blick, erkennt. Fast gleich wichtig ist den Teilnehmern die Datenqualität. Kaum verwunderlich, denn ohne qualitativ hochwertige Daten brauchen Sie mit Analysen gar nicht erst anzufangen. Eine sehr gute Datenqualität ist die Voraussetzung für alle darauf folgenden Analyseschritte. Auf dem dritten Platz landete das Thema «Self-service BI».

Power BI in der Praxis

Jürg Hilgert, Leiter Business & Infonomics bei der Schweizer Amag, hat vor Kurzem Microsofts Power BI eingeführt. Die Amag importiert die Automobil-Marken VW, Audi, Seat, Skoda und Volkswagen Nutzfahrzeuge in die Schweiz. Hilgarth hatte festgestellt, dass «das interne BI-Team für die Fachanwender viele Reports erstellt, die nur für eine kleine User-Gruppe von Interesse sind. Solche Ad-hoc-Datenanalysen sind zeitkritisch und es macht wenig Sinn, damit die regulären Prozesse der konzerninternen IT zu behindern.» In Zukunft sollen deshalb Abteilungen wie Marketing, Controlling oder Assistenz in die Lage versetzt werden, selbst Enduser-BI zu betreiben. Das erste Feedback ist positiv. «Unser Controller fühlt sich recht wohl mit Power BI, sonst hätte bei mir schon das Telefon geklingelt», erzählt Hilgarth, ergänzt aber kritisch: «Ich werde Power BI auch daran messen, welcher Unterstützungsaufwand von der IT geleistet werden muss.» Die Microsoft-Lösung muss noch beweisen, dass sie tatsächlich so leicht und leistungsfähig ist, wie sie verspricht. Konkurrenzprodukte hat Hilgarth zwar im Haus gehabt und die hätten zu Beginn auch sehr gut und intuitiv ausgesehen. Der Teufel liege aber im Detail, meint er. Ausserdem haben viele Endanwender bereits intensiv mit Excel gearbeitet und zum Beispiel jede Menge Pivot-Tabellen erstellt, deshalb «haben wir uns für Power BI entschieden». Nächste Seite: aktuelle Big-Data-Projekte bei den SBB Täglich reisen etwa 1,2 Millionen Fahrgäste mit den Schweizer Bundesbahnen. Die SBB ist eine der pünktlichsten Bahnen mit einem der dichtesten Netze der Welt. Zu den Stosszeiten, den Peaks in den Morgen- und Abendstunden, fahren die Züge extrem dicht getaktet im Abstand von nur 90 Sekunden auf den Neubaustrecken. Viel Zeitpuffer bleibt da nicht, und schon kleine Verspätungen drohen den ganzen Fahrplan durcheinander zu bringen.

"Wir haben mehrere brauchbare Business Cases auf der Agenda: zum Beispiel der Schienenmessfahrzug, der den Zustand des Schweizer Schienennetzes per Ultraschall überprüft", sagt Schindler. Der Zug checkt die Schienen auf Unebenheiten, macht aber auch Bildmaterial und prüft die Oberleitung. Das Bildmaterial kann eine Aussage über potentielle Gefahren machen, zum Beispiel ob ein Baum am Wegrand schief steht und die Gefahr besteht, dass er auf die Strecke fallen könnte. Da fallen natürlich riesige Datenmengen an. Wir sind zurzeit vor allem dabei, alle Streckendaten, Fotos und Ultraschall-Messungen sozusagen millimetergenau zusammenzubringen. Auf den Daten entwickeln Modelle, Methoden und Werkzeuge für die Prognosefähigkeit der Fahrbahn. Ziel ist es, damit ein proaktive Anlagenmanagement für die SBB zu ermöglichen. "Ein zweiter Big-Data-Case ist die Türstörung. Das hört sich erst einmal lapidar an. Türstörungen können aber grosse Probleme verursachen, gerade bei der engen Taktung zu Stosszeiten, die wir fahren", erzählt Schindler. Schliesst eine Tür am Perron nicht korrekt, kann der Zug nicht losfahren. Das heisst, wir müssen den Fahrplan komplett neu kalkulieren, denn der blockierte Zug muss natürlich später in den eng getakteten Fahrplan wieder eingephast werden. Ausserdem wird der Perron blockiert. Die Pendler, die auf nachfolgende Züge warten, müssen informiert werden, dass ihr Zug von einem anderen Perron abfährt.

"Es gibt zwei Ansätze, um dieses Problem in den Griff zu kriegen", erklärt Schindler. Der erste: Die SBB benutzen die polystrukturierten Instandhaltungsmeldungen, die jeder Wartungstechniker nach der Reparatur eines schadhaften Teils im SAP ausfüllt. Ein zweiter Ansatzpunkt ist die Schliessgeschwindigkeit der Tür. Dauert das Öffnen und Schliessen der Tür länger als gewöhnlich, ist das ein Warnzeichen. Jeder Türhersteller gibt einen Schwellenwert an, und wenn der durchbrochen wird, ist das ein Hinweis auf einen baldigen Ausfall. Nimmt man dann noch die Temperatur, die Luftfeuchtigkeit und den Hydraulikdruck hinzu, kann man recht genau eine Türstörung vorhersagen. "Energie-Controlling Traktion heisst unserer dritter Big Data Case", so Schindler. Die SBB will über die nächsten Jahre Energie sparen, bis 2025 etwa 600 Gigawatt-Stunden. Der Energieverbrauch der Loks, die Qualität der Schienen und Umweltdaten kommen auf eine Big-Data-Plattform, um dort durch Simulationen Muster zu erkennen, wie wir zukünftig den Energieverbrauch reduzieren können. Ein Szenario wäre zum Beispiel, Baustellen anders zu takten, sodass ein Zug zwischen Bern und Zürich nicht dreimal abbremsen und wieder beschleunigen muss. Das kann aber auch eine Optimierung der energieeffizientere Fahrweise sein. Nächste Seite: Machine Learning bei LeShop

Mehrwert von Azure Machine Learning

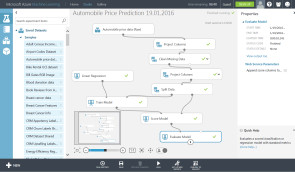

Julien de Perrot arbeitet als Professional Analyst bei Le Shop, einer Tochter der Migros. De Perrot hat jahrelange Erfahrung mit der Entwicklung von OLAP Cubes, einem klassischen, komplexen IT-Konstrukt der Business Intelligence. Jetzt aber hat er mit Azure Machine Learning begonnen, baut Prognosemodelle, analysiert unübersichtliche Datenmengen. Besonderes Potenzial und einen Mehrwert für Le Shop sieht de Perrot in logistischen Simulationen und vor allem im smarten Clustering der Kunden. Discounter teilen ihre Kundschaft zum Beispiel in die Gruppen ältere Menschen, doppelt verdienende Ehepaare und junge Familien auf, mit unterschiedlichen Kaufprofilen und Cross-Selling-Opportunitäten. Zwar offerieren Dienste wie Azure Machine Learning bereits fertige Komponenten zum Beispiel für die Sentiment Analyse oder die «Azure Stream Analytics for Real-Time Fraud Detection». Um anspruchsvolle Aufgaben zu meistern, sind aber Kenntnisse in der Statistiksprache «R» oder in Python unerlässlich.

Machine Learning steht noch nicht ganz oben auf der Prioritätenliste der meisten Anwenderunternehmen, noch gehört de Perrot zu den Vorreitern. Aber er ist überzeugt: «Die Zeit eilt uns (den Discountern und Online Shops) davon; wir müssen uns schnell in diese Technik einarbeiten, sonst sind wir in ein paar Jahren nicht mehr auf dem Markt präsent». Nächste Seite: IBMs DB2 entthront Oracle

Backend: IBM überholt Oracle

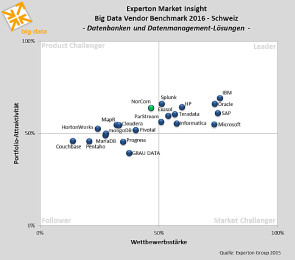

Benutzerfreundliche, intuitiv bedienbare Frontends tragen Business Intelligence/Analytics in die Fachabteilungen. Anbieter wie Qlik und Tableau arbeiten daran, den aus der Gaming-Industrie entlehnten Ansatz des explorativen, spielerischen Data Mining auf Analyse-Frontends zu übertragen: Datenanalyse als spannende Entdeckungsreise, das macht die Bedienung noch leichter (vgl. Interview mit BI-Innovationsguru Donald Farmer: Software mit Spassfaktor). Aber die intuitiven Frontends stehen auf den Schultern komplexer Datenbanken, Business Warehouses oder In-Memory-Lösungen im Backend, die von Experten aufgesetzt wurden. Dort hat sich ein Wachwechsel vollzogen. Im jüngsten Big Data Vendor Benchmark (Schweiz) von Experton hat Oracle den Datenbank-Thron an IBM verloren. Der aktuelle Marktführer IBM habe – so Experton – das zurzeit reichhaltigste Portfolio an Datenbanken und ergänzenden Lösungen auf dem Markt.

Die Lösungen seien technologisch sehr weit fortgeschritten. Das Kernstück für Big-Data-Anwendungen sei weiterhin DB2 mit den Beschleunigertechnologien Blu und IDAA. Die Analysten loben auch das sehr gute Beratungs- und Service-Angebot von IBM (vgl. Schweizer Big Data: Wie gut sind IBM, Oracle, Microsoft, IBM, EMC).

Analytics als Abenteuer

In den USA werde die IBM-Lösung Lift Insights oft verwendet, sagt Herwig Diessner von IBM DACH, und erklärt: Dass Händler von Outdoor- und Camping-Artikeln externe Meteo-Daten in ihre Verkaufsprognosen einbeziehen, sei mittlerweile nicht mehr sonderlich innovativ. Diessner berichtet aber von folgendem Fall: Ein Campingausstatter hatte ein neues Kochgeschirr ins Sortiment aufgenommen, das wie Blei in den Regalen liegen blieb. Der Händler war kurz davor, den Artikel wieder zu entfernen. Eine Analyse hat dann jedoch ergeben, dass eine andere Produktgruppe – Camping-Stühle – seitdem viel stärker verkauft wurde. Ohne Lift Analytics wäre niemand dieser Korrelation auf die Spur gekommen, der Camping-Ausstatter hätte die falsche Entscheidung getroffen und das Kochgeschirr wieder aus dem Sortiment genommen.

«Wir gehen weg von einzelnen Produkten, hin zu Lösungen», erklärt Diessner IBMs BI/Big-Data-Strategie und das gute Abschneiden bei Experton. Mit Cognos Analytics sei es einfach, Business-Analysen mit natürlicher Sprache zu fahren. Cognos gibt Optimierungstipps für Detailhändler, berät zum Beispiel bei Artikelpräsentation und der Lagerhaltung. Grundlage für die Optimierungstipps sind Algorithmen, die das Lernen des menschlichen Gehirns simulieren. Für den noch jungen Markt der Industrie 4.0 entstand auf der Basis von IBMs Analyse-Lösung eine Paket-Handling-Maschine. Kamera-Sensoren überprüfen Pakete und sortieren mithilfe von Mustererkennungs-Algorithmen beschädigte Pakete aus. Nächste Seite: Inselspital Bern wechselt auf SAP Hana

Wechsel auf Hana

Experton zählt in seinem Big Data Vendor Benchmark (Schweiz) IBM, Oracle, Microsoft und SAP zu den führenden Big-Data-Datenbankanbietern. Und auf dem Schweizer Markt jagen sich die vier Spitzenreiter gegenseitig Kunden ab. Das Inselspital Bern etwa ist von SAP BW mit Oracle auf SAP BW on Hana migriert. «Die Hardware-Verträge für das Business Warehouse waren abgelaufen und wir mussten uns überlegen, wie es weitergeht», erzählt Sabine Herbel vom Inselspital. «Der Hana-Case hat sich für uns gerechnet. Wir haben eine Sandbox für ein Hana-Pilotprojekt aufgesetzt, und Hana hat gehalten, was uns versprochen wurde».

Die Migration von Oracle auf Hana habe die Performance verdoppelt. Die technische Migration, so Herbel, sei an einem Wochenende über die Bühne gegangen, das BW lief gleich auf Hana. SAPs In-Memory-Plattform bietet gegenüber einer relationalen Datenbank aber einige weitere Vorteile: Die Indizes, unerlässlich für die schnelle Suche in klassischen Systemen, fallen in Hana weg. Sie werden nicht mehr benötigt. Ausserdem hat Hana ganz neue Daten-Objekte, eine schnellere Change-Bearbeitung und das ganze zugrunde liegende Datenmodell ist einfacher. Um in den Genuss sämtlicher (Performance-)Vorteile zu kommen, muss man daher an einigen Schrauben drehen. Für die optimierte Migration hat das Inselspital deshalb drei bis vier Monate gebraucht. Bis sämtliche Prozesse auf das neue Datenmodell optimiert angepasst sind, wird es wohl nochmals einige Monate dauern. «Für alle operativen Prozesse, von der Patientenaufnahme bis zur -abrechnung, gibt es bei uns eine SAP-Strategie», sagt Herbel. Dabei geht es zunächst um das Controlling, die Finanz- und Leistungskennzahlen. Natürlich könnte Hana viel mehr, zum Beispiel Patientenhistorien miteinander vergleichen, um auf Basis von Genom-Analysen die bestmögliche Therapie für einen einzelnen Patienten herauszufinden. Wie diese Funktionen im Bereich Personalisierter Medizin dann in der Insel Gruppe umgesetzt werden, ist momentan noch offen. Klar ist, dass eine konkrete Realisierung solcher Anwendungsszenarien einige Zeit in Anspruch nehmen wird, räumt Herbel ein. Nächste Seite: Big Data - 33 Use Cases

Big Data: 33 Use Cases

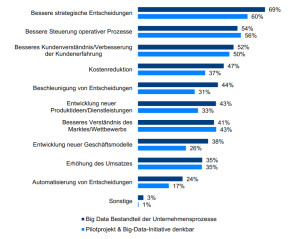

Das Gesundheitswesen ist nur einer von ganz vielen Big-Data-Anwendungsbereichen. Firmen prognostizieren damit die Unternehmensentwicklung, indem sie etwa mit der schnellen SAP Hana einen simulierten Jahresabschluss nicht in zwei Wochen, sondern in wenige Minuten erstellen. Big Data wird zur Betrugserkennung und Verbrechensprävention, für die Kalkulation von Ausfallrisiken, für vorausschauende Wartung (predictive Maintenance), bessere Profitabilitätsanalysen oder die Verkaufsgruppenanalyse – wie bei Le Shop weiter oben – eingesetzt. Einen knappen Überblick gibt Ihnen der Artikel «Big Data Analytics: 33 konkrete Use Cases». Von Big-Data- und BI-Initiativen versprechen sich Unternehmen bessere und schnellere strategische Entscheidungen, eine bessere Steuerung der operativen Prozesse (Inselspital Bern) und ein besseres Kundenverständnis (Le Shop). Auch die Überlegung, die Kosten zu reduzieren, spielt eine nicht unerhebliche Rolle (vgl. BARC: Big Data Use Cases 2015, Getting real on data monetization).

In der Regel werden die Erwartungen, die Unternehmen an BI/Big-Data-Projekte knüpfen, noch übertroffen, hat das BARC herausgefunden. So wollten 60 Prozent der Teilnehmer ihre strategischen Entscheidungen verbessern, und ein Jahr später in der einer nachfolgenden Studie stellte sich heraus, dass sich bei 69 Prozent diese Erwartung auch erfüllt hatte. Schaut man aber auf die Geschäftsbereiche in den Unternehmen, dann wird Big-Data-Technologie ganz unterschiedlich adaptiert. Vorreiter sind dabei die operativen, auf den Kunden konzentrierten Abteilungen Marketing und Vertrieb. Das Marketing ist Big Data gegenüber am aufgeschlossensten und setzt die Technologie auch am häufigsten ein. Nächste Seite: 10% Umsatzplus mit der Hauspastete

10% Umsatzplus mit Analytics

Ein Anwendungsbeispiel aus Marketing und Vertrieb: Eine börsenkotierte Schweizer Nahrungsmittelgruppe mit 1200 Mitarbeitenden und einem Jahresumsatz 2014 von über einer halben Milliarde Franken will das Produktverständnis für seine Hauspastete verbessern und das Marktpotenzial in Erfahrung bringen. Insbesondere wollte man wissen, welche demografischen Merkmale des Erfolg des Produktes beeinflussen.

Das Unternehmen ist im B2B-Geschäft tätig und kennt nur die Umsatz-/Absatzzahlen und Adressen der einzelnen Filialen der Detailhändler, die es beliefert. Zunächst wurden Tausende Filialadressen geocodiert, also den verschiedenen Regionen zugeordnet. Dann hat die Nahrungsmittelgruppe die geocodierten Absatz- und Umsatzzahlen mit den Daten des Bundesamtes für Statistik (BFS) in Beziehung gesetzt. Das BFS bietet kostenlos demografische Infos wie Alter, Geburtenrate, Einkommensklassen auf Gemeinde- und Bezirksebene. Eine Regressionsanalyse (Machine Learning) hat danach die Faktoren identifiziert, die einen signifikanten Einfluss auf die Verkaufszahlen haben. Durch Nachfrageprognosen wurden die Läden identifiziert, die hinter den Erwartungen zurückblieben, und die Ursachen analysiert. Insgesamt konnte die Gruppe den Umsatz mit seiner Hauspastete um 10 Prozent steigern (zum Einsatz kamen die Geo-Fingerprint-Analyse von IT-Logix, die Statistik-Software R, SAP Predictive Analytics, Microsoft Azure Machine Learning/oder SQL Server 2016). Nächste Seite: Interview FIFA - mit Big Data gegen Wettbetrug

FIFA im Interview: Wettbetrug per Big Data aufspüren

Thomas Hartmann ist Head of IT bei der Early Warning System GmbH (EWS), einer 100-prozentigen Tochter des Weltfussballverbandes FIFA. Als zentrales Ziel verfolgt die EWS den Schutz von Fussballspielen sämtlicher FIFA-Turniere durch Überwachung (Monitoring) und Analyse des internationalen Sportwettenmarktes. Dazu müssen Hartmann und sein Team grosse Mengen an Daten analysieren und auswerten.

Herr Hartmann, worin genau besteht Ihre Aufgabe?

Hartmann: Wir wollen durch unsere Arbeit Absprachen aufdecken und Betrügereien verhindern. Unser Ziel heisst «Fraud Detection». Dazu überwachen wir den Online-Sportwettenmarkt, werfen also ein wachsames Auge auf die Quotenbewegungen der Buchmacher und suchen IT-gestützt nach Auffälligkeiten. Das ist im Sinne der Wett-Teilnehmer und der Buchmacher, denn auch ein Buchmacher braucht eine ausgeglichene Bilanz.

Wie gehen Sie dabei vor?

Hartmann: Das EWS verfolgt eine 3-Säulen-Strategie. Von den Wettanbietern selbst erhalten wir Informationen über unregelmässige und verdächtige Wettaktivitäten. Unser IT-Monitoring-System überwacht und analysiert zusätzlich den globalen Sportwettenmarkt. Ein Informationsnetzwerk aus Kontaktpersonen und Dienstleistern, die dritte Säule, versorgt uns mit Infos, die zur Aufdeckung von Betrugsfällen wichtig sein können.

Wie häufig treten Betrügereien auf, und wie gehen die Manipulateure vor?

Hartmann: Sie können versuchen, die Akteure im sportlichen Wettkampf, also zum Beispiel die Spieler, den Torwart oder den Schiedsrichter, zu beeinflussen. Über solche Fälle wurde in den Medien bereits verschiedentlich berichtet. Bei den grossen FIFA-Turnieren ist das Risiko von Absprachen eher gering. Wir beobachten aber auch die Landesligen, und in Zweit- und Drittligen wird häufiger gemogelt, weil dort der Aufwand kleiner und – sozusagen – die Wege kürzer sind.

Sie haben kürzlich eine Big Data Appliance (BDA) von Oracle erworben. Weshalb?

Hartmann: Mit der BDA wollen wir unsere Analysen zur Betrugserkennung um zusätzlichen Dimensionen verfeinern. Die BDA erfasst zum Beispiel auch Sport-Performance-Kennzahlen wie die Laufleistung der einzelnen Spieler, die sie dann mit seiner durchschnittlichen Laufleistung vergleichen können. Krass untypische Leistungswerte können ein Hinweis auf vorab getroffene Absprachen sein, dem wir dann nachgehen. Das EWS analysiert aber nur und sendet seine Reports an die FIFA. Es ist dann Sache der FIFA, daraus Schlussfolgerungen zu ziehen und gegebenenfalls Sanktionen auszusprechen.

Warum haben Sie sich für die Oracle BDA entschieden?

Hartmann: Wir haben bereits die Exadata, die Datenbank-Appliance von Oracle, im Einsatz. Die Exadata und die BDA im Tandem bieten uns Integrationsvorteile, die wir mit Konkurrenzsystemen nicht so einfach erzielen können. Es ist möglich, SQL-Statements zur Abfrage der BDA-Daten zu nutzen. Das ist nur ein Beispiel. Die Entscheidung für die Oracle BDA ist uns deshalb nicht schwer gefallen. Die neue Lösung ist allerdings noch nicht im produktiven Einsatz. Das Projekt hat gerade begonnen und wird voraussichtlich in den nächsten Monaten abgeschlossen.