Big Data

23.05.2012, 02:05 Uhr

EMCs Datenkrake - Googles Trick

EMC hat eine riesige Big-Data-Maschine zusammengeschraubt: 1000 Server, 48 Terabyte Memory und 24 Petabyte Plattenspeicher. Google testet intern seine neue Hadoop-Analytics-Engine.

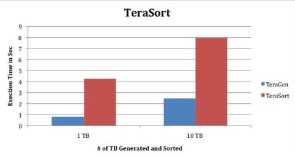

EMC-Chef Joe Tucci glaubt fest daran: Für ihn ist "Real Time Analytics", also die Analyse riesiger Datenmengen in Echtzeit, die Killer-App der Cloud, so wie es in der abgelaufenen Client-Server-Ära CRM- oder ERP-Systeme waren. Mit seiner Big-Data-Maschine Greenplum (EMC hat Greenplum im Juni 2010 übernommen) verdient Tucci zwar noch nicht viel. Aber die Betonung liegt auf "noch", und EMC geht mit seinem Prototypen "Hadoop out of the Box" in die Offensive. An der neue Hadoop-Monstermaschine, genannt Greenplum Analytics Workbench, hat EMC mit etwa einem halben Dutzend Partnern herumgeschraubt. Supermicro steuerte 1000 Enterprise-Server bei. Micron warf 1000 DDR3 RDIMM Speicherriegel (jeder 8 Gigabyte) in die Waagschale, insgesamt also 48 Terabyte Arbeitsspeicher. Jeder der tausend Knoten im Cluster kann auf 48 Gigabyte RAM zugreifen. Intel beteiligte sich mit 2000 X5670-Westmere-Prozessoren, jeder mit 6 Kernen ausgestattet und mit 2,93 GHz getaktet. Seagate ist mit 12.000 2-Terabyte-Festplatten mit von der Partie, was summa summarum 24 Petabyte Festplattenspeicher ergibt. Im Test: Greenplum Analytics Die Analytic Workbench unterstützt den gesamten Hadoop-Stack, also das für Cluster ausgelegte Dateisystem HDFS, MapReduce, die Query-Schnittstelle Hive, die kolumnenorientierte Datenbank Hbase, die Parallelsprache Pig und Mahout-Algorithmen. Im Big-Data-Industriebenchmark Terasort brauchte die Hadoop-Monstermaschine für das Sortieren von 1 Terabyte gut 4 Sekunden und für 10 Terabyte 8 Sekunden. Geplant ist, das Cluster auf 100 Terabyte und 1 Petabyte zu erweitern. EMC beabsichtigt, seine Greenplum Analytic Workbench mit dem "Network attached Storagesystem" (NAS) Isilon zu bundeln, das gerade in einer verbesserten, sogenannten Mavericks-Version herauskam. Isilon übernimmt dabei die Funktion eines persistenten Backup-Speichers. Eine ähnliche Strategie hat vor einem halben Jahr auch Oracle eingeschlagen. Oracle-Chef Larry Ellison stellt seiner Big-Data-Analysemaschine Exalytics den Datenbank-Giganten Exadata zur Seite. Durch Greenplum wird die Luft für Oracle dünner. Lesen Sie auf der nächsten Seite: Googles SQL-Trick Googles SQL-Trick Laut EMC glänzt die Greenplum Analytics Workbench mit zwei Vorteilen: (i) Sie ist ein fertig konfiguriertes, also sofort einsatzbereites Hadoop-Cluster "out of the box" und (ii) als Query-Sprache eignet sich auch SQL.Normalerweise sind die einfach gestrickten Key-Value-Paare eines Hadoop/Mapreduce-Clusters nicht per SQL recherchierbar. Der Komfort eines relationalen Datenbanksystems fehlt. Die entscheidenden Pionierarbeiten, so gab Greenplums Scott Yara auf einer Pressekonferenz auf der EMC World in Las Vegas offen zu, habe Google mit seinem Projekt Tenzing geleistet. Google setzt Tenzing bisher nur intern ein. Dahinter steckt eine Query-Engine, die Google für die Analyse seiner riesigen Userdaten-Bestände entwickelt hat - in SQL. Googles Suchmaschine bedient etwa 1 Milliarde Suchvorgänge pro Tag, und der Suchmaschinenprimus nutzt die eingehenden Userdaten für sozioprognostische Analysen. Das Problem dabei war: Das von Konzernen wie Google, Facebook oder Ebay eingesetzte Big-Data-Framework Hadoop/Mapreduce versteht kein SQL. Die Struktur der Big Data gibt das nicht her. Google intern: Big-Data-Analytics Ein einfaches SQL-Statement, das etwa die Mitarbeiter von Abteilungen nach Gehaltshöhe sortiert, versteht Hadoop/Mapreduce nicht. Es muss über mehrere Zwischenschritte übersetzt werden. So wird aus dem SQL-Befehl: SELECT abtlg, mitarb, gehalt RANK() OVER ( PARTITION BY abtlg ORDER BY gehalt DESC) AS gehalt_rank FROM mitarbeiter schliesslich der Hadoop-Sortierbefehl (key/value): Mapper::Map(in) { OutputToReducerWithSort( key = in.abtlg, value = {in.mitarb, in.gehalt})} (Entnommen aus: Tenzing, A SQL Implementation on the MapReduce Framework) Tenzing wird intern von etwa 1000 Google-Mitarbeitern für die Recherche in 1,5 Petabyte an Daten eingesetzt. Tenzing implementiert eine voll funktionale SQL-Engine plus zusätzlicher analytischer Funktionen auf Mapreduce. Das Hadoop/Mapreduce-Framework musste dafür, so Google, nur geringfügig verändert werden. Die Zukunft von Big Data Analytics sieht nach EMCs Scott Yara so aus: Die Abfragesprache SQL wird über ein eigenes SQL-Layer in Hadoop integriert, ebenso In-Memory Computing über ein eigenes Processing Layer. Lösungen von EMC, SAP und Oracle weisen in diese Richtung. "Unser Ziel ist es, eine Unified-Analytics-Plattform für Big Data zu bauen", so Yara in Las Vegas.