30.11.2012, 11:58 Uhr

Amazon lanciert die «Daten-Pipline»

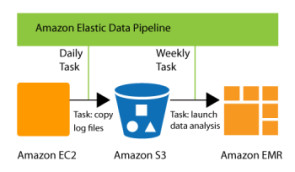

Auf der User-Konferenz AWS re:invent hat Amazon einen Daten-Pipeline-Dienst vorgestellt, der an unterschiedlichen Orten gespeicherte Informationen zur Analyse zusammenführt.

Der neue Service «Data Pipeline» ist dafür vorgesehen, die Analyse und das Management von Daten standortübergreifend zu ermöglichen. Mit Hilfe eines grafischen User-Interfaces können Anwender ihre Daten verändert und erkunden, unabhängig davon, ob sie in Amazons AWS-Cloud oder im eigenen Data Center abgelegt wurden. Data Pipeline ist selbstverständlich in allen Speicherumgebungen von AWS einsetzbar, dazu zählen etwa die Dienste «Simple Storage Service» (S3), die NoSQL-Implementation «DynamoDB» sowie der gestern vorgestellte Data-Warehouse-Dienst Redshift. Auf der Anwenderkonferenz re:invent in Las Vegas, die am gestrigen Donnerstag zu Ende gegangen ist, demonstrierte Matt Wood, Big-Data-Chef bei AWS die Funktionsweise, indem er eine DynamoDB-Datenbank so konfigurierte, dass Informationen ##{"type":"InterRed::Userlink","linktype":"b","linkoffset":0,"ziel_ba_name":"cwx_artikel","bid":0,"cid":0,"extern":"","fragment":"","t3uid":"60171","page":0,"text":"automatisch im Speicherdienst S3","target":"_top","alias":"","_match":"","_custom_params":[]}#! sowie in BI-Tools repliziert werden. Der neue Dienst ergänzt andere AWS-Angebote rund um das Speichern und Auswerten von Daten. Anfang des Jahres hatte Amazons Web-Geschäftsbereich bereits den Service Glacier für dauerhaftes Speichern vorgestellt. Zudem wurde im AWS-Marktplatz eine eigene Big-Data-Sektion eingerichtet, wo Anwender Applikationen zur Verarbeitung von Massendaten finden. AWS gab auf der Konferenz bekannt, dass S3 nun über eine Billionen Dateien speichere. Neben der Pipeline-Lösung kündigte Amazon zwei weitere Optionen für das Processing und die Analyse von Big Data an. Dabei handelt es sich um neuen Instanztypen für den Dienste «Elastic Cloud Compute» (EC2). Die Version «Cluster High Memory» bietet 240 Gigabyte RAM und zweimal 120 Gigabyte SSD-Speicher. Die zweite, neue Instanzoption «High Storage» wird mit 117 Gigabyte RAM und 48 Terabyte Disk-Speicher bereitgestellt.