Praxistest

12.11.2014, 15:47 Uhr

Storage-Architektur von Microsoft ersetzt SAN

Die Virtualisierung erfordert meist klassische SAN-Speichernetze, die teuer sind. Microsoft bietet eine Software-basierte Storage-Architektur als Alternative an. Die GAD, ein Spezialist für Banken-IT aus Deutschland, hat die Microsoft-Lösung intensiv getestet und klärt, ob damit ein SAN ersetzbar ist.

Mit der Virtualisierung steigt die Nachfrage nach SANs (Storage Area Network), weil die fortgeschrittenen Funktionen es erfordern, die virtuellen Maschinen zentral zu speichern. Allerdings sind die Kosten solcher Speichersysteme eine wesentliche Hürde auf dem Weg zur Private Cloud. NAS- und SAN-Leistungsfähigkeit ohne teure Speicher-Arrays - das verspricht Microsoft mit einer Reihe neuer Storage-Funktionen aus Windows Server 2012. Diese reichen von den Storage Spaces, den Cluster Shared Volumes bis hin zur neuen Version 3.0 des Server-Kommunikationsprotokolls SMB (Server Message Block).

Ein wichtiger Baustein ist dabei der Scale-out File-Server (SOFS). Microsoft positioniert ihn als Speicher für Applikationsdaten, besonders für VM-Images und SQL-Datenbanken. Kombiniert man den Scale-out File-Server mit den neuen Storage-Funktionen, so lässt sich eine SAN-ähnliche Architektur schaffen, die Einsatzgebiete abdeckt, die bislang SANs vorbehalten waren. Die Speichervirtualisierung wird damit direkt im Betriebssystem verankert. Der grosse Vorteil der Lösung liegt darin, dass sich diese Speichersysteme relativ preiswert mit Standard-Hardware und -Netzwerken realisieren lassen. Statt der teuren SANs kann ein JBOD-System (Just a Bunch of Disks) eingebunden werden und im Bereich Netzwerk genügen einfache Switche statt Komponenten für das Unternehmensnetz. Dennoch unterstützt dieser Software Defined Storage alle wesentlichen Funktionen von Hyper-V.

Wie reif diese Architektur ist und ob sie tatsächlich an die Funktionen eines SAN heranreicht, das hat die GAD nun in zwei Umgebungen ausgiebig getestet und ein Hardware-Konzept dazu entwickelt. Die GAD eG ist Spezialist für Banken-IT und betreibt nach eigenen Angaben eines der sichersten Rechenzentren Europas. Hier sind auf 450 Hyper-V-Hosts rund 4000 virtuelle Maschinen in Betrieb - bis Mitte 2015 sollen es 7000 sein. Nächste Seite: Test einer Microsoft-Cloud im Mega-Cluster

Wie reif diese Architektur ist und ob sie tatsächlich an die Funktionen eines SAN heranreicht, das hat die GAD nun in zwei Umgebungen ausgiebig getestet und ein Hardware-Konzept dazu entwickelt. Die GAD eG ist Spezialist für Banken-IT und betreibt nach eigenen Angaben eines der sichersten Rechenzentren Europas. Hier sind auf 450 Hyper-V-Hosts rund 4000 virtuelle Maschinen in Betrieb - bis Mitte 2015 sollen es 7000 sein. Nächste Seite: Test einer Microsoft-Cloud im Mega-Cluster

Test einer Microsoft-Cloud im Mega-Cluster

Der erste Test kam durch einen Zufall zustande: Für ein grosses Projekt hatte die GAD im Frühsommer 2014 64 Blade-Server angeschafft, die bereits drei Wochen vor ihrem Einsatz zur Verfügung standen. Das IT-Team beschloss daher, für den anstehenden Lasttest einen Hyper-V-Cluster mit 64 Knoten und 8000 virtuellen Maschinen aufzubauen.

«Wir wollten die Microsoft-Cloud testen und ihre Support-Grenzen überschreiten», erzählt Thomas Büdenbender, Systems Engineer bei der GAD. Büdenbender und sein IT-Team haben bereits einiges Know-how bezüglich Windows Server 2012 und Hyper-V aufgebaut, da die GAD als Technical Adoption Partner von Microsoft die Versionen in einer frühen Phase testet und dabei auch an der Entwicklung neuer Funktionen beteiligt ist.

Der Test zeigte einmal, dass sich der Hyper-V-Cluster auch mit 8000 virtuellen Maschinen problemlos managen liess. «Am Ende umfasste der Cluster fast 12'000 virtuelle Maschinen und sein Limit war noch nicht erreicht», berichtet Büdenbender.

«Wir wollten die Microsoft-Cloud testen und ihre Support-Grenzen überschreiten», erzählt Thomas Büdenbender, Systems Engineer bei der GAD. Büdenbender und sein IT-Team haben bereits einiges Know-how bezüglich Windows Server 2012 und Hyper-V aufgebaut, da die GAD als Technical Adoption Partner von Microsoft die Versionen in einer frühen Phase testet und dabei auch an der Entwicklung neuer Funktionen beteiligt ist.

Der Test zeigte einmal, dass sich der Hyper-V-Cluster auch mit 8000 virtuellen Maschinen problemlos managen liess. «Am Ende umfasste der Cluster fast 12'000 virtuelle Maschinen und sein Limit war noch nicht erreicht», berichtet Büdenbender.

Shared Storage für 12'000 virtuelle Maschinen

Bei diesem Test setzte das IT-Team erstmals einige der neuen Storage-Funktionen ein. «Windows Server 2012 R2 bietet mit dem Scale-out File-Server und dem Server-Protokoll SMB 3.0 erstmals die Möglichkeit, Datei-Server als Shared Storage für Hyper-V-Cluster einzusetzen», erörtert Büdenbender. «Anlässlich des Cloud-Tests wollten wir sehen, ob die neue Datei-Server-Technik so hohe Lastanforderungen verkraftet.»

Daher wurden zwei Dell PowerEdge R720 mit 384 GByte RAM und zwei CPUs mit 8 Cores in die Testarchitektur. Die beiden dienten als Scale-out File-Server und sollten den Shared Storage für das Hyper-V-Cluster bereitstellen. Für die Anbindung an das Cluster waren die Dell-Server mit je zweimal 10-GBit-Netzwerk ausgestattet.

Bei diesem Lasttest musste das IT-Team noch auf ein klassisches SAN zurückgreifen, da es über kein geeignetes JBOD-System verfügte. Daher wurden die beiden Dell-Server über je zweimal 8 GBit Fibre Channel an ein SAN angebunden, das 491 Festplatten und 145 TByte Kapazität bereitstellte.

Bei den Tests in dem Cluster mit zunächst 8000 und dann 12'000 virtuellen Maschinen konnte die Storage-Architektur mithalten. «Es war beeindruckend, wie performant der Scale-out File-Server ist», berichtet Büdenbender. «Wir haben 200 virtuelle Maschinen zwischen den Knoten hin und her geschwenkt. Die Datei-Server-Technik erreichte nicht ihre Grenzen, obwohl die beiden Scale-out File-Server über Fibre-Channel-Verbindungen mit nur 8 GBit an den Storage angebunden waren.» Nächste Seite: Netzwerk verkraftet Bootstorm mit 8000 Maschinen

Daher wurden zwei Dell PowerEdge R720 mit 384 GByte RAM und zwei CPUs mit 8 Cores in die Testarchitektur. Die beiden dienten als Scale-out File-Server und sollten den Shared Storage für das Hyper-V-Cluster bereitstellen. Für die Anbindung an das Cluster waren die Dell-Server mit je zweimal 10-GBit-Netzwerk ausgestattet.

Bei diesem Lasttest musste das IT-Team noch auf ein klassisches SAN zurückgreifen, da es über kein geeignetes JBOD-System verfügte. Daher wurden die beiden Dell-Server über je zweimal 8 GBit Fibre Channel an ein SAN angebunden, das 491 Festplatten und 145 TByte Kapazität bereitstellte.

Bei den Tests in dem Cluster mit zunächst 8000 und dann 12'000 virtuellen Maschinen konnte die Storage-Architektur mithalten. «Es war beeindruckend, wie performant der Scale-out File-Server ist», berichtet Büdenbender. «Wir haben 200 virtuelle Maschinen zwischen den Knoten hin und her geschwenkt. Die Datei-Server-Technik erreichte nicht ihre Grenzen, obwohl die beiden Scale-out File-Server über Fibre-Channel-Verbindungen mit nur 8 GBit an den Storage angebunden waren.» Nächste Seite: Netzwerk verkraftet Bootstorm mit 8000 Maschinen

Netzwerk verkraftet Bootstorm mit 8000 Maschinen

Ein weiterer Blick galt dem Netzwerk. Die Anbindung der Applikations-Server im Hyper-V-Cluster erfolgte nicht über iSCSI oder Fibre Channel, sondern über SMB 3.0. «Das Server-Kommunikationsprotokoll funktionierte sehr gut, das Netzwerk lief ausreichend schnell», schildert Büdenbender. «Es verarbeitete sogar einen Bootstorm, bei dem wir alle 8000 virtuellen Maschinen des Cluster gleichzeitig heruntergefahren und wieder gestartet haben.»

Die Ergebnisse des Tests waren so vielversprechend, dass das IT-Team beschloss, die neue Storage-Architektur intensiv in einem Proof of Concept zu testen. Nun sollte statt eines SAN wie im ersten Test ein JBOD mit Storage Spaces zum Einsatz kommen. Ziel war, eine schnelle und performante Speicherumgebung zu schaffen und dabei die Kosten möglichst gering zu halten.

Die Ergebnisse des Tests waren so vielversprechend, dass das IT-Team beschloss, die neue Storage-Architektur intensiv in einem Proof of Concept zu testen. Nun sollte statt eines SAN wie im ersten Test ein JBOD mit Storage Spaces zum Einsatz kommen. Ziel war, eine schnelle und performante Speicherumgebung zu schaffen und dabei die Kosten möglichst gering zu halten.

Im Visier: Quantensprung im Storage-Netzwerk

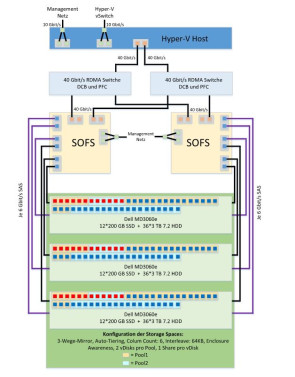

Dabei orientierte sich das Team um Büdenbender an dem Building-Block-Gedanken: «Wir wollten Hyper-V-Hosts, Scale Out File Server und das JBOD mit Storage Spaces in einer Lösung vereinen und das Ganze in einem Rack aufbauen.»

Der Clou dabei: «Liegen die Server für die Hyper-V-Hosts und für den Scale-out File-Server sowie das JBOD nahe beieinander, können wir sie dank SMB 3.0 über RDMA-fähige Switche mit 40 GBit verkabeln», erläutert Büdenbender. «Das ermöglicht uns einen Quantensprung im Netzwerk. Bislang mussten wir für den Storage in unser Unternehmensnetz und da stehen uns Switche mit 10 GBit zur Verfügung, was auch schon schnell ist.» Dank der kurzen Wege kann die Storage-Lösung also seine Stärke auch im Netzwerk ausspielen.

Für den Proof of Concept holte das IT-Team Dell ins Boot, das bei der Auswahl der Hardware beriet. Ebenfalls begleitete ein auf Virtualisierung spezialisierter Techniker von Microsoft den Test.

Das Client-System bestand aus acht Knoten, auf denen vorwiegend 40 virtuelle Maschinen liefen. Auf einzelnen Konten waren auch mehrere 100 virtuelle Maschinen in Betrieb, um die Grenzen der Architektur auszuloten. Das produktive Hyper-V-Cluster wurde über zweimal 40-GBit-Netzwerk an ein Cluster aus zwei Scale-out File-Server angebunden. Für diese wurden zwei Dell PowerEdge R720 herangezogen.

Der Clou dabei: «Liegen die Server für die Hyper-V-Hosts und für den Scale-out File-Server sowie das JBOD nahe beieinander, können wir sie dank SMB 3.0 über RDMA-fähige Switche mit 40 GBit verkabeln», erläutert Büdenbender. «Das ermöglicht uns einen Quantensprung im Netzwerk. Bislang mussten wir für den Storage in unser Unternehmensnetz und da stehen uns Switche mit 10 GBit zur Verfügung, was auch schon schnell ist.» Dank der kurzen Wege kann die Storage-Lösung also seine Stärke auch im Netzwerk ausspielen.

Für den Proof of Concept holte das IT-Team Dell ins Boot, das bei der Auswahl der Hardware beriet. Ebenfalls begleitete ein auf Virtualisierung spezialisierter Techniker von Microsoft den Test.

Das Client-System bestand aus acht Knoten, auf denen vorwiegend 40 virtuelle Maschinen liefen. Auf einzelnen Konten waren auch mehrere 100 virtuelle Maschinen in Betrieb, um die Grenzen der Architektur auszuloten. Das produktive Hyper-V-Cluster wurde über zweimal 40-GBit-Netzwerk an ein Cluster aus zwei Scale-out File-Server angebunden. Für diese wurden zwei Dell PowerEdge R720 herangezogen.

Ausfallsicherheit auf hohem Niveau

Jeder der beiden Scale-out File-Server erhielt über SAS (Serial Attached SCSI) jeweils zwei Anbindungen an alle drei eingesetzten JBODs. So konnte das IT-Team das Storage-System als drei-Wege-Spiegel konfigurieren, um eine hohe Ausfallsicherheit zu gewährleisten. In jedem JBOD arbeiteten zwölf SSDs mit 200 GByte und 48 HDDs mit 3 TByte - die Laufwerke sind so verteilt, wie es Microsoft empfiehlt.

Diese Laufwerke fasste das IT-Team mittels Storage Spaces zu zwei gleich grossen Pools zusammen, die die virtuellen Disks für den Scale-out File-Server bereitstellen. Die Konfiguration und die gesamte Verwaltung der Storage Spaces erfolgen also in Windows Server 2012 R2.

Das ganze System - die produktiven Server und die Storage-Lösung - passt mehrfach in ein Standard-Rack mit 42 Höheneinheiten hinein: Die JBODs messen vier Höheneinheiten, die Scale-out File-Server drei und der Hyper-V-Host zwei. Zunächst wurde das Storage-System eine Woche bei Dell in Frankfurt getestet, danach weitere vier Wochen im Rechenzentrum der GAD in Münster. Nächste Seite: Schnelles Netzwerk - der Storage hält mit

Diese Laufwerke fasste das IT-Team mittels Storage Spaces zu zwei gleich grossen Pools zusammen, die die virtuellen Disks für den Scale-out File-Server bereitstellen. Die Konfiguration und die gesamte Verwaltung der Storage Spaces erfolgen also in Windows Server 2012 R2.

Das ganze System - die produktiven Server und die Storage-Lösung - passt mehrfach in ein Standard-Rack mit 42 Höheneinheiten hinein: Die JBODs messen vier Höheneinheiten, die Scale-out File-Server drei und der Hyper-V-Host zwei. Zunächst wurde das Storage-System eine Woche bei Dell in Frankfurt getestet, danach weitere vier Wochen im Rechenzentrum der GAD in Münster. Nächste Seite: Schnelles Netzwerk - der Storage hält mit

Schnelles Netzwerk - der Storage hält mit

Der Proof of Concept bestätigte die Ergebnisse des ersten Tests. «Die ganze Konstruktion läuft schon sauber. Mit Scale-out File-Server hatten wir keine Probleme und auch die 40-GBit-Technik lieferte überzeugende Performance-Raten, obwohl sie sehr neu ist», berichtet Büdenbender. «Wir benötigen momentan in unserem Rechenzentrum rund 20 Minuten, um einen Hyper-V-Knoten mit 40 virtuellen Maschinen von einem Host auf den anderen zu verschieben. Mit der neuen Technik reichten 1:13 Minute.»

Das schnellste Netzwerk nutzt aber wenig, wenn das Storage-System nicht mithält. «Im Test stand dem Scale-out File-Server immer ein ausreichend schneller Speicher in Form der Storage Spaces zur Verfügung. Das liegt an den neuen Storage-Funktionen in Windows Server 2012 R2», ergänzt Büdenbender.

Die Funktion Tiered Storage beispielsweise analysiert regelmässig die virtuellen Datenträger und verlagert oft genutzte Daten auf die SSDs, und Daten, die selten benutzt werden, auf die HDDs. Das geschieht standardmässig nachts um ein Uhr per Task Scheduler. Somit stellen die HDDs ausreichend Speicherplatz zur Verfügung und die SSDs sorgen dafür, dass der Pool ausreichend Performance bekommt.

Das schnellste Netzwerk nutzt aber wenig, wenn das Storage-System nicht mithält. «Im Test stand dem Scale-out File-Server immer ein ausreichend schneller Speicher in Form der Storage Spaces zur Verfügung. Das liegt an den neuen Storage-Funktionen in Windows Server 2012 R2», ergänzt Büdenbender.

Die Funktion Tiered Storage beispielsweise analysiert regelmässig die virtuellen Datenträger und verlagert oft genutzte Daten auf die SSDs, und Daten, die selten benutzt werden, auf die HDDs. Das geschieht standardmässig nachts um ein Uhr per Task Scheduler. Somit stellen die HDDs ausreichend Speicherplatz zur Verfügung und die SSDs sorgen dafür, dass der Pool ausreichend Performance bekommt.

Der Building Block senkt die Komplexität

Mit dieser Architektur sinkt auch die Komplexität im Rechenzentrum, so Büdenbender: «Betreiben wir eine Virtualisierungseinheit als Building Block, müssen wir uns für die Bereitstellung weder mit den Netzwerk- und Firewall- noch mit den Storage-Kollegen abstimmen. Davon versprechen wir uns einiges.»

Ein billiger Jakob ist diese Architektur allerdings noch nicht. In den JBODs stecken zwölf Server-SSDs, die für Schreibzugriffe optimiert sind. Allein eine SSD kostete 2500 Euro - mal 36 Stück. «Dennoch agieren wir mit der Microsoft-Technologie in einem ganz anderen Preissegment als mit unserem High-End-SAN. Wir erhalten hier sehr schnellen Storage zu günstigen Preisen und werden auch im Netzwerkbereich immens einsparen», resümiert Büdenbender. «Nach heutigem Stand kann man ab 500 virtuelle Maschinen über so eine Architektur nachdenken.» Nächste Seite: Ab 2015 bereit für den Einsatz

Ein billiger Jakob ist diese Architektur allerdings noch nicht. In den JBODs stecken zwölf Server-SSDs, die für Schreibzugriffe optimiert sind. Allein eine SSD kostete 2500 Euro - mal 36 Stück. «Dennoch agieren wir mit der Microsoft-Technologie in einem ganz anderen Preissegment als mit unserem High-End-SAN. Wir erhalten hier sehr schnellen Storage zu günstigen Preisen und werden auch im Netzwerkbereich immens einsparen», resümiert Büdenbender. «Nach heutigem Stand kann man ab 500 virtuelle Maschinen über so eine Architektur nachdenken.» Nächste Seite: Ab 2015 bereit für den Einsatz

Ab 2015 bereit für den Einsatz

Zuvor muss Microsoft jedoch nach an einigen Punkten nachbessern, so Büdenbender: Bei den Storage Spaces gibt es noch Probleme, wenn einzelne Platten oder ein komplettes JBOD ausfallen. Diese Probleme sind Microsoft schon bekannt. Büdenbender rechnet damit, dass sie bis Ende des Jahres mit den nächsten Fix-Packs behoben sein werden.

Offene Punkte gibt es auch beim Monitoring. «Man muss sich noch überlegen, wie die ganze Konstruktion, also das Zusammenspiel von Hyper-V-Host, Switche, Scale-out File-Server bis hin zu den JBODs, sinnvoll zu überwachen ist», erörtert Büdenbender. Beispielsweise sind die Platten in den JBODs noch nicht 100-prozentig erfasst. Dell will hier in den kommenden Monaten ein Management-Pack für System Center Operations Manager liefern.

Offene Punkte gibt es auch beim Monitoring. «Man muss sich noch überlegen, wie die ganze Konstruktion, also das Zusammenspiel von Hyper-V-Host, Switche, Scale-out File-Server bis hin zu den JBODs, sinnvoll zu überwachen ist», erörtert Büdenbender. Beispielsweise sind die Platten in den JBODs noch nicht 100-prozentig erfasst. Dell will hier in den kommenden Monaten ein Management-Pack für System Center Operations Manager liefern.

Virtueller Storage für die Zukunft

«Wenn alles so gut weiterläuft, können wir wohl Anfang kommenden Jahres beginnen, das System produktiv einzusetzen», berichtet Büdenbender. Zunächst will er die Testsysteme umrüsten und dann nach und nach in die produktive Umgebung gehen.

«Das wird in jedem Fall eine unserer künftigen Storage-Technologien für die Virtualisierung werden», resümiert Büdenbender. «Ich bin sicher: Wenn wir von Virtualisierung sprechen, sprechen wir künftig auch von dem Scale-out File-Server und dem entsprechenden Storage dahinter.»

«Das wird in jedem Fall eine unserer künftigen Storage-Technologien für die Virtualisierung werden», resümiert Büdenbender. «Ich bin sicher: Wenn wir von Virtualisierung sprechen, sprechen wir künftig auch von dem Scale-out File-Server und dem entsprechenden Storage dahinter.»