14.04.2014, 10:24 Uhr

Diese Big-Data-Projekte sind erfolgreich

Die Analyse grosser Datenmengen ist in vielen Schweizer Unternehmen bereits Realität. Aber der NSA-Schock wirkt nach. Computerworld hat Big-Data-Erfolgsszenarien aus fünf Branchen unter die Lupe genommen.

Big Data ist neuerdings in Verruf geraten. Vor zwei Jahren konnten Schweizer und Deutsche mit dem Begriff kaum etwas anfangen, jetzt sehen sie nur noch Sicherheitslücken. «Wir stecken mitten in einer digitalen Depression», sagte Christian Illek, Vorsitzender der Geschäftsführung von Microsoft Deutschland, auf der grössten Computermesse der Welt, der CeBIT. Das hat schon Gewicht, da hört man hin. Die Redaktion der Computerworld erkennt den Trend auch an ihrem eigenen Onlinechannel computerworld.ch. Das Thema Sicherheit wird wie wild geklickt, Tipps fr Paranoide haben Hochkonjunktur. Schweizer Grossunternehmen, die Computerworld anfragte und die eigentlich prädestiniert für den Einsatz von Big-Data-Technologie sind, kommunizieren dagegen sehr vorsichtig. «Der Datenschutz steht bei allen unseren Überlegungen im Vordergrund; beim Umgang mit Daten hält sich Swisscom an die geltende Gesetzgebung», versichert Swisscom-Pressesprecher Olaf Schulze. Und der Migros Genossenschaftsbund bügelte unsere Anfrage schlichtweg ab: «Wir verfolgen die Entwicklungen im Bereich Big Data ? mehr haben wir zum Thema momentan nicht zu sagen», hiess es kurz und bündig. Der Brunnen scheint vergiftet. Microsofts Illek schlägt deshalb einen «New Deal» vor, der wie anno dazumal unter US-Präsident Franklin Delano Roosevelt aus der digitalen Depression herausführen soll. Dazu müssten Anwenderunternehmen, Big-Data-Lösungsanbieter und die Politik gemeinsam an einem Strang ziehen. Der britische Premier David Cameron und die deutsche Bundeskanzlerin Angela Merkel pflichteten ihm auf der CeBIT bei. Wie dieser New Deal, diese unbedingt nötige Vertrauenskampagne, aussehen soll, wusste allerdings keiner der drei genau zu sagen. Wie bei jedem Hype ist es auch hier ratsam, einen Schritt zurückzutreten und die Dinge mit Schweizer Gelassenheit zu betrachten. Big Data ist nicht neu. Viele, auch Schweizer Firmen, setzen Big Data Analytics seit Jahren erfolgreich ein, ohne das aber so zu nennen. Gleichzeitig gibt es spannende neue Entwicklungen. Computerworld hat deshalb exemplarisch fünf Märkte unter die Lupe genommen, wo sich der Einsatz von Big-Data-Technologie besonders lohnt: Handel/Retail, Banken/Versicherungen, Verkehr/Logistik, Gesundheit/Diagnostik und Sensortechnik/Machine to Machine. Lesen Sie auf der nächsten Seite: Big Data im Handel

Big Data im Handel

Warum hat die britische Supermarktkette Tesco, die drittgrösste der Welt hinter Walmart, das 24-Stunden-Shopping eingeführt? Ausschlaggebend war eine Big-Data-Analyse, die das Unternehmen vor einigen Jahren in seinen weltweiten Filialen durchgeführt hat. Wenn sich zu Peak-Zeiten, am Wochenende oder in der Vorweihnachtssaison, in den Kaufhäusern die Kunden drängeln, dann stabilisiert sich die Kundendichte nicht, wie eigentlich zu erwarten, auf diesem hohen Niveau. Im Gegenteil, nach dem Peak fiel die Kundenzahl markant ab. Anscheinend fühlen sich Neukunden vom Gedränge in den Parkhäusern und in den Läden so abgeschreckt, dass sie ihre Einkäufe lieber auf die nächsten Tage verschieben oder gleich zur Konkurrenz gehen. Und dieser Abschreckeffekt wirft einen stundenlangen Schatten. «Ohne unsere Big-Data-Analysen hätten wir dieses Ergebnis niemals vorausgesehen», gibt Matt Atkinson, Chief Marketing Officer bei Tesco, unumwunden zu. Nach dem Peak sinkt die

Kundenzahl signifikant und Tesco verliert bares Geld. «Das war für uns der entscheidende Anstoss, das 24-Stunden-Shopping einzuführen», erinnert sich Atkinson. Manchmal trügen Intuition und Bauchgefühl, die Zahlen sprechen eine andere Sprache. Oft ist der menschliche Verstand aber auch einfach überfordert, sämtliche Einflussgrössen schnell gegeneinander aufzurechnen. Der Schweizer Discounter Coop etwa optimiert mit Big Data Analytics die Logistik seiner schnell verderblichen Frischwaren. Zwar liefert eine Absatzprognose im Wochentakt, bei Coop jahrelang im Einsatz, für die meisten Artikel eine ausreichende Qualität. Bei Frischwaren wie Früchte, Gemüse, Fleisch und Fisch sah der Discounter jedoch Optimierungspotenzial. Die neue Lösung «New Forecast for Fresh Items», die seit 2012 in den Schweizer Coop-Filialen erprobt wurde, liefert nun «tagesaktuelle und hochreaktive Prognosen». Die umfassendere Lösung «SAP Unified Demand Forecast» läuft demnächst auf SAPs In-Memory-Appliance Hana. Damit werden Echtzeitprognosen und Simulationsszenarien über grosse Datenbestände realisierbar.

Kundenzahl signifikant und Tesco verliert bares Geld. «Das war für uns der entscheidende Anstoss, das 24-Stunden-Shopping einzuführen», erinnert sich Atkinson. Manchmal trügen Intuition und Bauchgefühl, die Zahlen sprechen eine andere Sprache. Oft ist der menschliche Verstand aber auch einfach überfordert, sämtliche Einflussgrössen schnell gegeneinander aufzurechnen. Der Schweizer Discounter Coop etwa optimiert mit Big Data Analytics die Logistik seiner schnell verderblichen Frischwaren. Zwar liefert eine Absatzprognose im Wochentakt, bei Coop jahrelang im Einsatz, für die meisten Artikel eine ausreichende Qualität. Bei Frischwaren wie Früchte, Gemüse, Fleisch und Fisch sah der Discounter jedoch Optimierungspotenzial. Die neue Lösung «New Forecast for Fresh Items», die seit 2012 in den Schweizer Coop-Filialen erprobt wurde, liefert nun «tagesaktuelle und hochreaktive Prognosen». Die umfassendere Lösung «SAP Unified Demand Forecast» läuft demnächst auf SAPs In-Memory-Appliance Hana. Damit werden Echtzeitprognosen und Simulationsszenarien über grosse Datenbestände realisierbar.

Kundenbindung per Handy

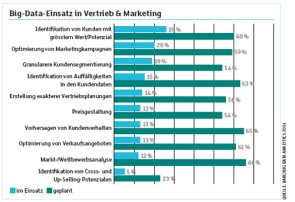

Auch junge Start-ups beschäftigen sich mit Big-Data-Applikationen für den Einzelhandel. Code_n, eine internationale Plattform für Pioniere, Innovatoren und Start-ups, will neue Geschäftsmodelle für die digitale Welt von morgen entwickeln und schrieb auf der CeBIT einen mit 30000 Euro dotierten Förderpreis aus. Der Preis ging an das Start-up Viewsys, dessen Lösung Einzelhändler in die Lage versetzt, die subtilen Analysemethodiken des Onlinehandels auf die reale Welt zu übertragen. Händler, die mit Viewsys zusammenarbeiten, erfassen mithilfe von Sensoren, wenn ein Smartphone-Benutzer ihr Geschäft betritt. Als eindeutiges Identifikationsmerkmal dient die MAC-Adresse des Geräts. Die Händler erfahren dadurch, wie viele Menschen an ihren Geschäften vorbeigegangen sind, wie viele hereinkamen, wo sie sich aufhielten und ob sie am Ende auch etwas gekauft haben. Auch potenzielle Stammkunden lassen sich damit identifizieren. Mit diesen Informationen können die Ladenbetreiber zum Beispiel die Präsentation ihrer Waren in den Regalen optimieren oder wertvolle Mehrfachkunden mit Rabatten oder Sonderangeboten stärker an sich binden. Carsten Bange, Geschäftsführer des Business Application Research Center (BARC) in Würzburg, hat branchenübergreifend 372 Unternehmen aus Deutschland, der Schweiz und Österreich zu ihren Big-Data-Projekten befragt. Die Ergebnisse seiner im März veröffentlichten Studie «Big Data Analytics 2014» punkto Vertrieb und Marketing: 26 Prozent der Teilnehmer haben bereits Technologien im Einsatz, die es erlauben, die Kunden mit dem grössten Wertpotenzial zu identifizieren. 60 Prozent planen in Zukunft den Einsatz solcher Lösungen. Mit Big Data Analytics wollen die Teilnehmer ausserdem ihre Marketingkampagnen verbessern, Auffälligkeiten in den Kundendaten entdecken, den Vertrieb besser planen sowie ihre Lagerhaltung und Preisgestaltung optimieren (vergleiche Grafik unten).

Lesen Sie auf der nächsten Seite: Big Data in der Finanzindustrie

Big Data in der Finanzindustrie

Einen Hochzeitsring kaufen die meisten Menschen im Leben nur einmal. Diese ganz spezielle Investition sprengt in der Regel das normale Ausgabeverhalten und das Kaufprofil des Kontoinhabers. Den Banken, bei denen der glückliche Käufer sein Konto hält, gelingt es trotzdem problemlos, die Grossinvestition vom Kreditkartenmissbrauch, der ja auch vorliegen könnte, zu unterscheiden ? dank Big Data Analytics. Zunächst einmal setzen Kreditkartenbetrüger die gestohlenen Karten typischerweise nicht in Juweliergeschäften für Grosseinkäufe ein, sondern bevorzugen kleinere Beträge in schneller Folge an räumlich benachbarten Lokationen. Dies wiederum ist ein Indiz für möglichen Kreditkartenmissbrauch. Ausserdem kündigt sich der Hochzeitsring im Kaufverhalten des Kontoinhabers an: eine kürzliche Kreditaufnahme, ein intensiveres Sparverhalten, weniger Bars, stattdessen häufigere Restaurantbesuche, höhere Ausgaben für Möbel und Einrichtungsgegenstände lassen Heiratsabsichten als recht genau vorhersagbares Ereignis erscheinen. Banken nehmen für sich in Anspruch, Hochzeiten und Scheidungen bis zu einer Genauigkeitsquote von 98 Prozent prognostizieren zu können. Einen Heiratsring zu erwerben, ist also ? unter finanzieller Perspektive ? gar nicht so ein einmaliges Ereignis, wie wir denken. Ja, sogar die Preismarge, die wir als angemessen empfinden, lässt sich anhand etwa des Gehalts und des historischen Kaufprofils, also der durchschnittlichen Höhe der Alltagseinkäufe, recht genau vorhersagen.

Opportunitäten erkennen

Natürlich setzen die Schweizer Grossbanken Credit Suisse und UBS, die Kantonalbanken und Sparkassen seit Jahren Big Data Analytics ein. Nur nennen sie das nicht so und hängen es auch nicht an die grosse Glocke. Die UBS etwa analysiert ihre Kundendaten mit Lösungen von SAS. Als Informationsquellen dienen Angaben zur Kundenbeziehung, zu Konten, Anlagen, Hypotheken, Darlehen, Kreditkarten, Geschäftsvorfällen und der Rentabilität. Die Analysen geben Aufschlüsse über das Verhalten der Kunden und liefern den Beratern der Bank wertvolle Hinweise auf zukünftige Opportunitäten. Der Wirtschaftsinformationsdienst Teledata kalkuliert Kreditausfallrisiken von Unternehmen und Privatpersonen. Als Kriterien dienen zum Beispiel Betreibungsauskünfte, die Häufigkeit von Namensänderungen, Anzahl der Wechsel in der Vorstandsetage und Konkursmeldungen. Dabei kommt die Analyse-Software «SPSS Modeller» zum Einsatz. Teledata listet die Daten von mehr als einer halben Million Schweizer Betrieben, 1,25 Millionen ins Handelsregister eingetragener Geschäftspersonen und mehr als 6,1 Millionen Privatpersonen auf.

Kredite über Social Media

Auch in Sachen Kreditausfallberechnung betreten Start-ups neue Wege. Die estnische Firma Big Data Scoring, die an der CeBIT auf dem Stand von Code_n ausstellte, benutzt Social Media Analytics. Im Verlauf der Prüfung und Kreditvergabe muss der Kreditnehmer der Plattform Zugriff auf seinen Facebook-Account gestatten. Big Data Scoring liest danach Informationen zu Ausbildung, Beziehungsstatus (Verheiratete sind kreditwürdiger), Anzahl der Freunde, Gefällt-mir-Buttons, Gruppenzugehörigkeiten und Orte aus. Ausserdem trägt die Software Informationen über die Freunde des Kreditnehmers, etwa deren Ausbildung und Arbeitsplatz, zusammen ? nach der Devise: Gleich und gleich gesellt sich gern. Big Data Scoring sammelt auf diese Weise 5000 bis 10000 Zeilen pro Antrag und berechnet daraus die Kreditwürdigkeit. In Finanzwirtschaft und Controlling, so das Ergebnis der Big-Data-Studie von BARC-Chef Carsten Bange, stehen jedoch zurzeit gar nicht Risikoanalysen und die Berechnung von Kreditausfallrisiken im Vordergrund. «Die Medien bringen das gerne als Beispiel für Big Data Analytics», meint Bange. Für die Finanzhäuser stünde aber die Analyse der Detaildaten, also neue Verkaufsopportunitäten, ganz oben auf der Agenda. Als wichtig eingestuft würden ausserdem Simulationen, Vorhersagen und die Bildung von Szenarien. Lesen Sie auf der nächsten Seite: Big Data im Verkehr

Big Data im Verkehr

Wiesloch, eine kleine Stadt im nördlichen Baden-Württemberg, schrieb schon einmal Automobilgeschichte. Dort musste 1888 Bertha Benz einen unfreiwilligen Stopp einlegen, um auf ihrer ersten Fernfahrt ihren leeren Tank aufzufüllen. Auch das Jahr 2013 markiert einen Meilenstein in der Geschichte des Automobils. Zum ersten Mal legte eine Limousine von Mercedes-Benz die etwa 100 Kilometer lange Strecke von Mannheim über Wiesloch nach Pforzheim ohne menschlichen Fahrer zurück. Software sass am Steuer. Die Zürcher Supercomputing Systems AG hat dazu eine kleine, aber extrem wichtige Software-Komponente beigesteuert: Ein Fahrerassistenzsystem, das 25 Bilder pro Sekunde verarbeiten kann. Damit kann das Software-gesteuerte Fahrzeug auch hochkomplexe Situationen autonom meistern. Automobile ähneln heute einem «rollenden Rechenzentrum», wie die NZZ am 13. März titelte, auch wenn ein menschlicher Fahrer am Steuer sitzt. Sensoren überwachen Verschleissteile des Fahrzeugs und schlagen Alarm, wenn die Ausfallwahrscheinlichkeit ein bestimmtes Limit überschreitet. Der ERP-Weltmarktführer SAP hat vor, mithilfe von Sensortechnik in Kombination mit seiner In-Memory-Appliance Hana, sogar in die Formel 1 einzusteigen.

125 Sensoren pro Rennbolide liefern Daten, die Hana während des Rennens in Echtzeit auswertet und Was-wäre-wenn-Szenarien durchspielt. Damit will SAP denn Rennverlauf beeinflussen und Handlungsempfehlungen geben, um die Gewinnchancen des Formel-1-Piloten zu optimieren.

125 Sensoren pro Rennbolide liefern Daten, die Hana während des Rennens in Echtzeit auswertet und Was-wäre-wenn-Szenarien durchspielt. Damit will SAP denn Rennverlauf beeinflussen und Handlungsempfehlungen geben, um die Gewinnchancen des Formel-1-Piloten zu optimieren.

Präzisere Stauprognosen

Swisscom berechnet auf Basis anonymisierter Handy-Daten die Geschwindigkeiten und Reisezeiten pro Autobahnabschnitt. Über die Zeiten eines Wechsels von einer Mobilfunkantenne zur nächsten kann man zum Beispiel erkennen, ob auf einem bestimmten Autobahnabschnitt gerade Stau herrscht. Die bereinigten Reisezeiten und Reisegeschwindigkeiten leitet Swisscom dann zwecks Stauwarnung an das Bundesamt für Strassen (Astra) weiter. Ab Juni 2013 werden die neuralgischen Abschnitte der typischen Urlaubsautobahnen A2, A3 und A13 erfasst. Swisscom-Pressesprecher Olaf Schulze rechnet ab Mai 2014 mit zuverlässigen Aussagen. Lesen Sie auf der nächsten Seite: Big Data im Gesundheitswesen

Big Data im Gesundheitswesen

Auch das menschliche Genom ist Big Data. Die Software des niederländischen Start-ups Genalise hat die Genomanalyse wesentlich beschleunigt und war am CeBIT-Stand von Code_n zu bestaunen. In einem Versuch Ende 2013 soll es dem Unternehmen gelungen sein, auf einem PC mit Intel-Xeon-E5-2620-Prozessor mit 12 Kernen die gesamte menschliche DNA im Durchschnitt in 25 Minuten zu sequenzieren. Normalerweise dauert das Tage. Eine persönliche DNA-Analyse gestattet es, das Risiko für Krankheiten wie Krebs, Tumore, Herzinfarkte oder Schlaganfälle genauer zu beziffern. Sie liefert die Datenbasis für eine personalisierte Therapie und Medikation. Je niedriger die Kosten, desto mehr Menschen werden von der Avantgarde-Medizin profitieren. Das Berliner Krankenhaus Charité analysiert mithilfe von SAP Hana die Krankenakten seiner Krebspatienten. Die Ärzte der Charité analysieren mit Hana die Krankheitsbilder und Krankheitsverläufe Tausender von Krebspatienten. Sie können dadurch besser einschätzen, wie ein individueller Patient auf bestimmte Therapien reagiert und seine Heilungschancen verbessern. Zusammen mit einer performant durchgeführten DNA-Analyse gibt Big Data Analytics dem behandelnden Mediziner ein sehr leistungsstarkes Diagnosewerkzeug an die Hand.

Big Data in der Landwirtschaft

Der Agrarmaschinenhersteller Claas produziert Erntemaschinen wie Mähdrescher und Traktoren. Kombiniert mit IT-Technologie werden daraus Maschinen, die miteinander kommunizieren und dadurch den Ernteprozess optimieren (Machine to Machine, M2M). Claas spricht von «Farming 4.0» und hat die neue Technologie an der Getreideernte 2013 in der Praxis erprobt. Ein Szenario: Bei guten Erntebedingungen drischt ein Mähdrescher zwischen 60 und 100 Tonnen Getreide pro Stunde. Der Korntank ist dann alle 10 Minuten voll und muss geleert werden. Die Maschine weiss, wann ihr Korntank voll sein wird und ruft automatisch per Mobilfunk den Traktor mit Überladewagen. Der Traktor kennt das Gelände, alle Maschinenstandorte und sucht sich den besten Weg zum Mähdrescher. Dabei achtet er auf die Zeit, aber auch auf Bodenschonung. Die übernommene Getreidemenge wird inklusive Qualitätsdaten an das Silomanagement des landwirtschaftlichen Betriebs gemeldet. In der Zwischenzeit hat der Mähdrescher neue Wetterdaten empfangen, in drei Stunden wird es regnen. Die Maschine ändert ihre Strategie und schlägt dem Fahrer vor, ab sofort mit maximaler Geschwindigkeit statt mit minimalem Spritvebrauch zu arbeiten, um das Feld noch vor dem Regen abzuernten. Lesen Sie auf der nächsten Seite: Fazit

Fazit: Big Data ist Realität

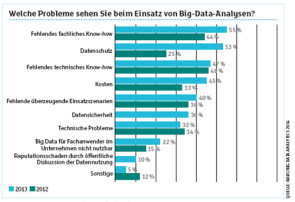

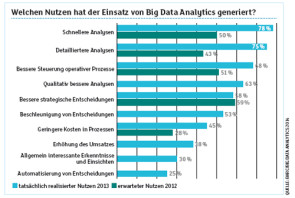

Big Data Analytics ist kein Hype mehr, sondern branchenübergreifend Realität. Schweizer Unternehmen, die Big Data dennoch skeptisch gegenüberstehen, machen die Ergebnisse der Big-Data-Analytics-Studie des BARC Mut (vergleiche Grafiken loben). BARC-Chef Carsten Bange hat die Ergebnisse dieses und des letzten Jahres miteinander verglichen. Heraus kam: Die teilnehmenden Firmen hatten die Herausforderungen, die mit der Durchführung eines Big-Data-Projekts einhergehen, unterschätzt. Insbesondere fehlendes fachliches Know-how machte ihnen zu schaffen, auch die Kosten wurden unterschätzt. Das ist die schlechte Nachricht, aber es gibt auch eine gute. Der Mehrwert und Nutzen von Big Data fiel signifikant höher aus als erwartet. Die Qualität und Performanz der Analysen schnellte in die Höhe. Noch überraschender aber ist dies: 45 Prozent der Studienteilnehmer konnten durch Big-Data-Initiativen ihre Prozesskosten senken und die Transparenz erhöhen. Für 38 Prozent schlug sich das in der Summe sogar in gestiegenen Jahresumsätzen nieder.